既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

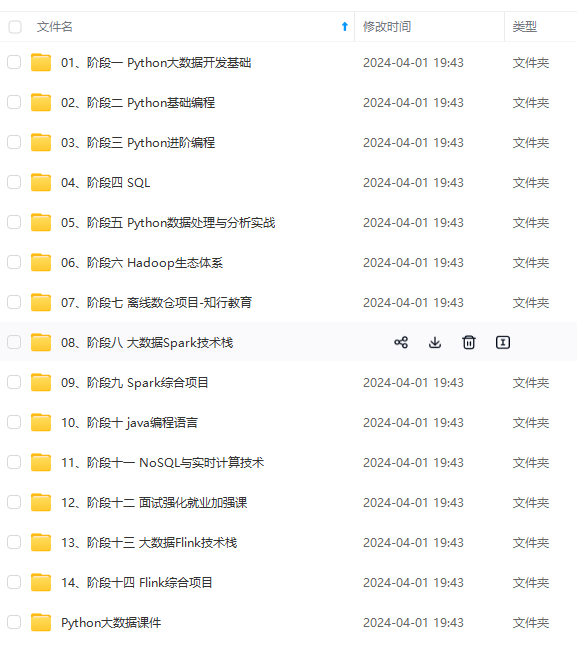

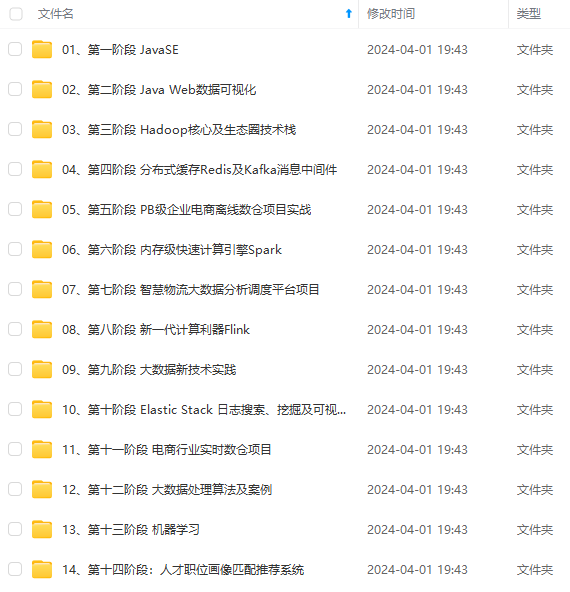

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

需要这份系统化资料的朋友,可以戳这里获取

SparkSQL: Spark Sql 是Spark来操作结构化数据的程序包,可以让我使用SQL语句的方式来查询数据,Spark支持多种数据源,包含Hive表,parquest以及JSON等内容

SparkStreaming: 是Spark提供的实时数据进行流式计算的组件

MLlib:提供常用机器学习算法的实现库

GraphX:提供一个分布式图计算框架,能高效进行图计算

BlinkDB:用于在海量数据上进行交互式SQL的近似查询引擎

Tachyon:以内存为中心高容错的分布式文件系统

四、应用场景

淘宝使用Spark来解决多次迭代的机器学习算法、高计算复杂度的算法等。应用于内容推荐,社区发现等

五、Spark之RDD

5.1什么是RDD

RDD叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变,可分区,里面的元素可并行计算的集合。RDD具有数据流模型的特点:自动容错,位置感知性调度和可伸缩性。RDD允许用户在执行多个查询时显式地将工作集缓存在内存中,后续地查询能够重用工作集,这极大地提升了查询速度。

5.2RDD的属性

(1) 一组分片,即数据集的基本组成单位。对于RDD来说,每个分片都会被一个计算任务处理,并决定并行计算的粒度。

(2)一个计算每个分区的函数。Spark中的RDD的计算以分片为单位的,每个RDD都会实现compute函数以达到这个目的。

(3)RDD之间的依赖关系。RDD的每次转换都会生成一个新的RDD,所以RDD之间就会形成类似于流水线一样的前后依赖关系。部分分区数据丢失时,Spark可以通过这个依赖关系重新计算对视的分区数据,而不是对RDD的所有分区进行重新计算。

(4)一个Partitioner,即RDD的分片函数。当前Spark中实现了两种类型的分片函数,一个是基于哈希的,另一个是基于范围的

(5)一个列表,存储存取每个Partition(分片)的优先位置。对于一个HDFS文件来说,这个列表保存的就是每个Partition所在的块的位置。

5.3通过简单的词频统计来了解RDD

img

六、RDD的创建方式

6.1通过读取文件生成

由外部存储系统的数据集创建,包括本地的文件系统,还有所有Hadoop支持的数据集,比如HDFS、Cassandra、HBase等

6.2通过并行化的方式创建RDD

由一个已经存在的Scala集合创建

6.3其他方式

读取数据库等等其他的操作。也可以生成RDD。

RDD可以通过其他的RDD转换而来的。

七、RDD编程API

Spark支持两个类型(算子)操作:Transformation和Action

7.1Transformation

主要做的是就是将一个已有的RDD生成另外一个RDD。Transformation具有lazy特性(延迟加载)。Transformation算子的代码不会真正被执行。只有当我们的程序里面遇到一个action算子的时候,代码才会真正的被执行。这种设计让Spark更加有效率地运行。

常用的Transformation:

7.2Action

触发代码的运行,我们一段spark代码里边至少需要有一个action操作

常用的Action:

7.3Spark WordCount代码编写

使用maven进行项目搭建

查看官方文档,导入2个依赖包

详细代码-scala

详细代码-jdk8

到此这篇Spark面试题2024(spark面试题面试题)的文章就介绍到这了,更多相关内容请继续浏览下面的相关推荐文章,希望大家都能在编程的领域有一番成就!版权声明:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权、违法违规、事实不符,请将相关资料发送至xkadmin@xkablog.com进行投诉反馈,一经查实,立即处理!

转载请注明出处,原文链接:https://www.xkablog.com/rfx/52644.html