最近有朋友问能否搭建像那样自动回复消息的机器人,网上查了很多资料,关于微信机器人的资料很简略,基本没有从0-1的,相对有一篇算是比较详细的,也是踩了很多坑。

当然了网上有直接使用安装版本的,目前踩过的坑就是,本人使用的是Linux服务器,python默认是2.7版本,需要升级到3以上。费老劲给升级到3,然后在安装依赖的过程中一直安不上,整了一天都没有找到解决方案。

第二天换了个思路,使用docker安装,因为docker的镜像里面就已经集成好了对应的依赖之类的插件,但是在整个搭建过程也是踩了很多坑,很容易设置的参数不对,或者漏掉参数,导致服务能启动,但是无法触发自动回复,最后经过多次测验,终于成功配置出正确的参数,下面来说说搭建过程。

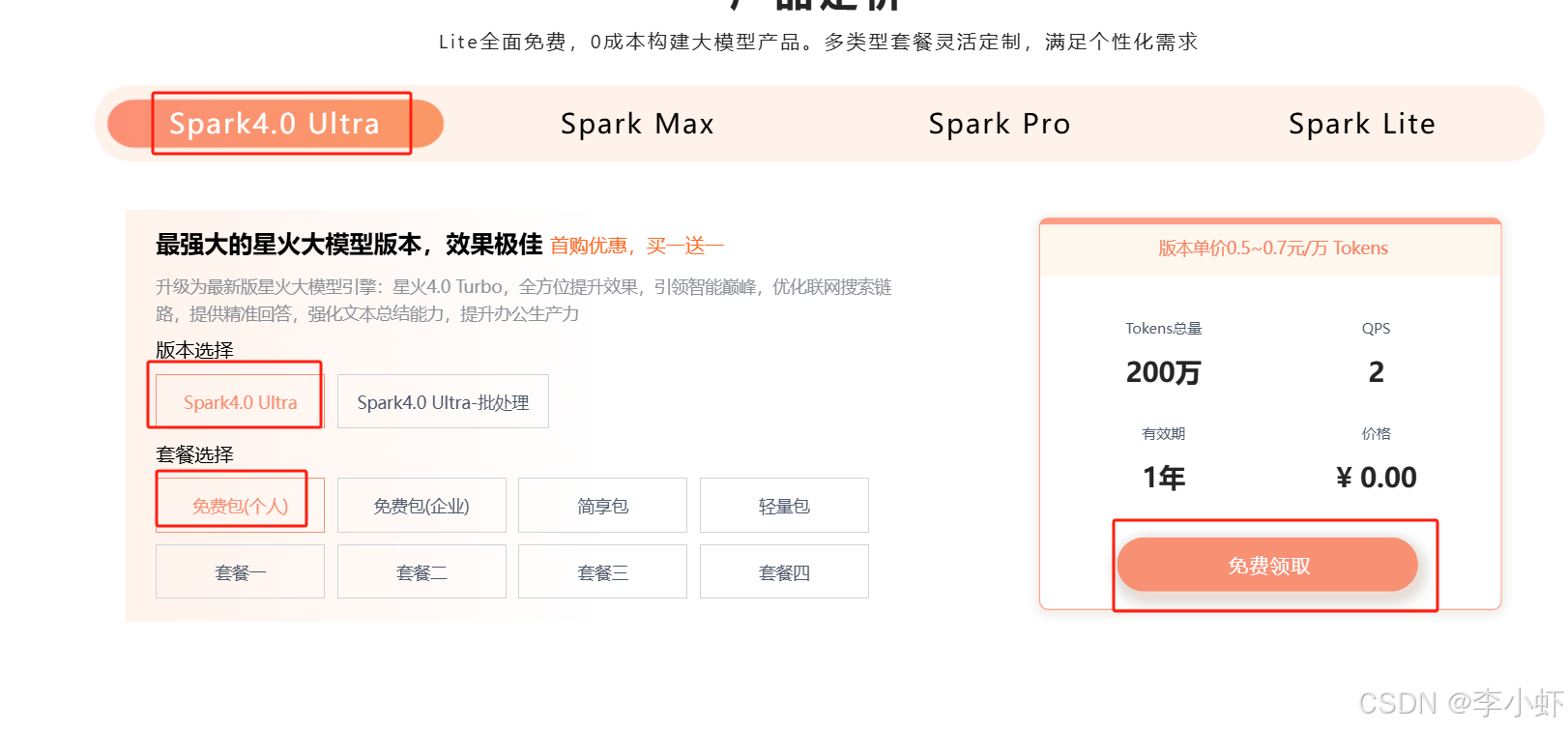

一、准备大模型账号。

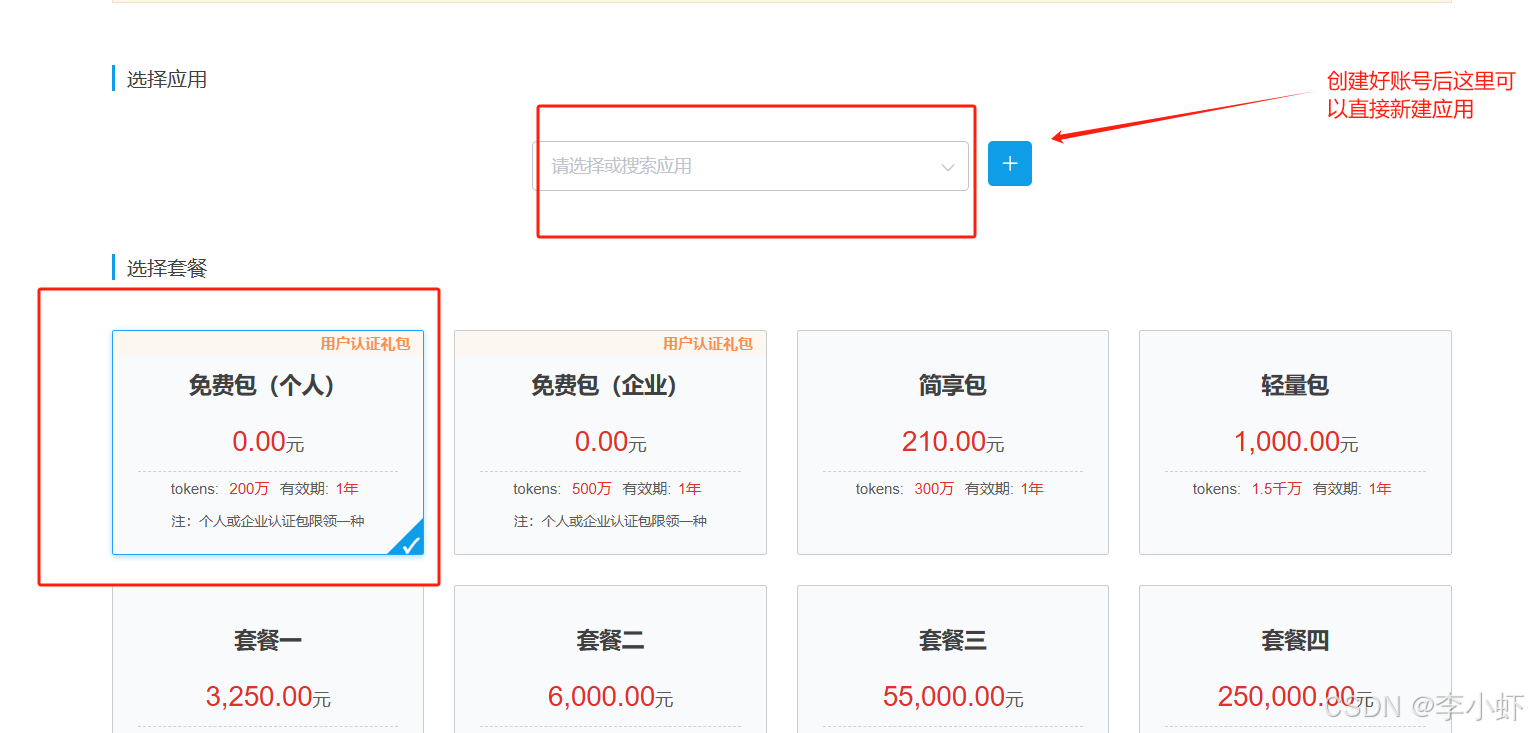

目前我使用的是讯飞的大模型,正巧是赶上他免得的时候,送200万TOKEN,可以好好的玩玩。首先去官方地址:打开链接 https://xinghuo.xfyun.cn/sparkapi?scr=price 点击免费试用即可

下单之后,在我的应用里面找到刚才的几个重要的参数

二、服务搭建

1、安装docker-compose,这里就不讲述了,需要的话网上随便找一个。

2、制作docker-compose.yml文件

如果镜像无法下载,可以下载网盘的再导入到服务器中。

通过百度网盘分享的文件:chatgpt-on-wechat-img.tar.gz

链接:https://pan.baidu.com/s/1NlkHxb7-ZUUi-FUF2qAxEA?pwd=dl6k

提取码:dl6k

使用命令导入

docker load -i chatgpt-on-wechat-img.tar.gz 即可导入镜像

使用命令启动服务

docker-compose up -d

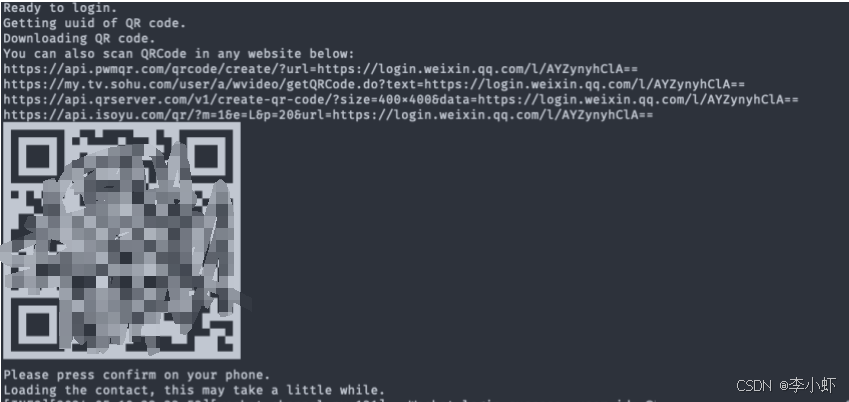

查看日志

docker-compose logs -f chatgpt-on-wechat

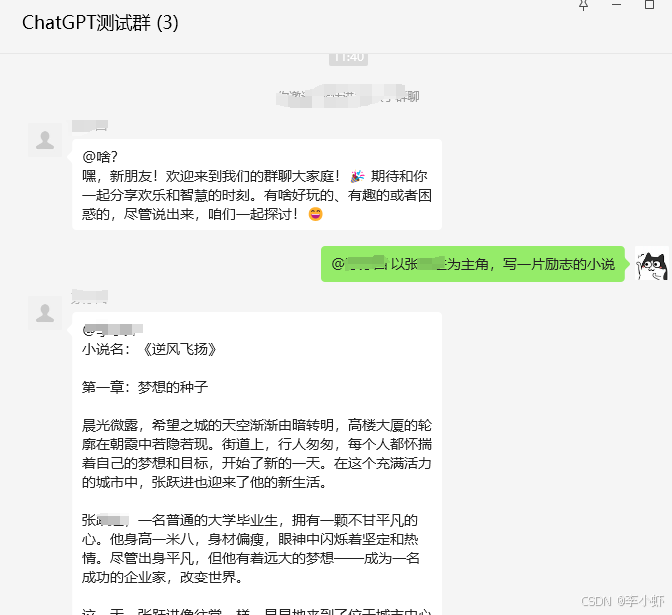

效果如下

然后把微信拉倒设置白名单的群里,就可以当AI机器人回复了。期间微信必须一直在线,不能后台清除登录状态。

至此就算搭建完了,整个过程耗时一天,到处查资料,感兴趣的可以看看相关配置

https://github.com/zhayujie/chatgpt-on-wechat/blob/master/config.py#L12

到此这篇微信机器人app(微信机器人api接口)的文章就介绍到这了,更多相关内容请继续浏览下面的相关推荐文章,希望大家都能在编程的领域有一番成就!版权声明:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权、违法违规、事实不符,请将相关资料发送至xkadmin@xkablog.com进行投诉反馈,一经查实,立即处理!

转载请注明出处,原文链接:https://www.xkablog.com/hd-api/15775.html