先列出主要观点,有时间再补充细节:

“学习Linux内核”对不同的人有不同的含义,学习方法、侧重点、投入的精力也大不相同。我大致分三类:reader、writer、hacker。reader 就是了解某个功能在内核的大致实现 how does it work,一般不关心某些极端情况下(内存不足、受到攻击)的处理方法,对于看不懂的地方也可以跳过。我自己最多算半个 reader,只看我感兴趣的一小部分代码(我只关心 TCP 收发数据,不管 IP routing/forwarding/fragment 等,更不会去关心 ethernet 层),而且读一个函数一般只看主干(happy path),不管 security/debugging/tracing,经常忽略错误处理分支。writer 是给内核加feature和改bug的人,需要更进一步的知识,写代码要考虑 how not to break it(哪些地方需要加锁,按照什么顺序加锁以避免死锁,如何正确释放分配的资源等等)。hacker 是通过分析代码找出安全漏洞并加以利用的人,研究 how to break it,读代码恐怕更注意找出error handling分支没有覆盖的case。

内核向用户态提供的接口很稳定,但是内核的具体实现变化很快,你深入钻研获得的知识很容易就过时。比方说 Linux 的 TCP 实现在2015年3月新加了 TCP_NEW_SYN_RECV 这个非标准的 TCP state,同年6月发布的 kernel 4.1 才开始用它。如果你学的是一年前的 kernel,那么建立TCP连接这方面的细节知识对于今年发布的 Ubuntu 16.04 可能已经过时了。

Linux内核的一些做法在 C 语言中是合理的(比方说用包含函数指针的各种 xxx_ops struct 来手工实现虚函数表,通过控制 struct 内存布局来模拟继承:tcp_sock 继承 inet_connection_sock 继承 inet_sock 继承 sock 继承 sock_common),在其他高级语言中往往有更简便的实现方式,不必生搬硬套。遇到 xxx_ops->some_func(arg) 这种代码,思路容易断线,这个 xxx_ops 到底指向哪个具体实现?最好能把代码跑起来,用调试器单步跟踪,一下子就定位到了 callee。当然,读 OO 代码也会遇到这个困难,传进来的这个 interface 在运行时到底是哪份实现?读 Python 代码就更难了,函数参数光有个名字,连 type 都没有。

Linux内核比较注重代码的通用性和复用性,要照顾那些虽然你用不到但少数人会用的需求。通用性方面,虽然现在大家都用以太网,但是网络协议栈的代码还在支持 FDDI、Token Ring(从 3.5 版起已删除)、ATM 等,偶尔会扰乱视线,更在原本简单直接的做法上增加间接层,加大了理解代码的负担。复用性方面,从 3.17 版开始,IPv4 和 IPv6 共享同一个 tcp_conn_request() 函数[tcp: add tcp_conn_request · torvalds/linux@1fb6f15 · GitHub]。原来的做法是各自有 tcp_v4_conn_request() 和 tcp_v6_conn_request(),新合并的 tcp_conn_request() 为了处理 v4/v6 的不同情况,用了一个 struct tcp_request_sock_ops* 参数,这代码读起来就比原来绕了。虽然我不关心 IPv6 的实现,但读代码的时候却不能排除其干扰。

Linux内核广泛采用的侵入式数据结构设计恐怕很难应用到一般程序开发中。基本上是个高维十字链表,一个节点(struct)可以同时位于多个hash/list/tree中。

如果你本身就要从事内核开发,那么以上这些都不是问题。对于这用户态写server的人,学内核的目的是什么,学到的知识能不能/要不要/如何用到日常开发中,这是值得思考的。

同样的情况也出现在 Java 开发者身上,一般的 Java 程序员要不要读 JVM 的实现?我记得 @RednaxelaFX 对此有过精彩的论述,我完全同意他的看法。特别是当你功力不够时,强行去读源码,结果读错了地方(一个函数有多个实现,你读的那个其实没有被调用,甚至没有被编译),造成了错误的认识,回头来还跟人争论说JVM/kernel里是如何如何实现的,那还不如不读。

逢人就推荐阅读 Linux 内核源码,就像向每个学数据结构的人推荐 TAOCP 一样,是中文网络上特有的现象,我对此是不赞成的。(前几年还有一问C++网络编程就推荐ACE库的现象,现在少多了。)

还是不同层次的问题……

一个网络包从应用程序A发到另一台电脑上的应用程序B,需要经历:

- 从A的业务代码到A的软件框架

- 从A的软件框架到计算机的操作系统内核

- 从A所在计算机的内核到网卡

- 从网卡经过网线发到交换机等设备,层层转发,到达B所在计算机的网卡

- 从B所在计算机的网卡到B所在计算机的内核

- 从B所在计算机的内核到B的程序的用户空间

- 从B的软件框架到B的业务代码

这个层级关系就像是过程调用一样,前一级调用后一级的功能,后一级返回一个结果给前一级(比如:成功,或者失败)。只有在单独一级的调用上,可以说同步还是异步的问题。所谓同步,是指调用协议中结果在调用完成时返回,这样调用的过程中参与双方都处于一个状态同步的过程。而异步,是指调用方发出请求就立即返回,请求甚至可能还没到达接收方,比如说放到了某个缓冲区中,等待对方取走或者第三方转交;而结果,则通过接收方主动推送,或调用方轮询来得到。

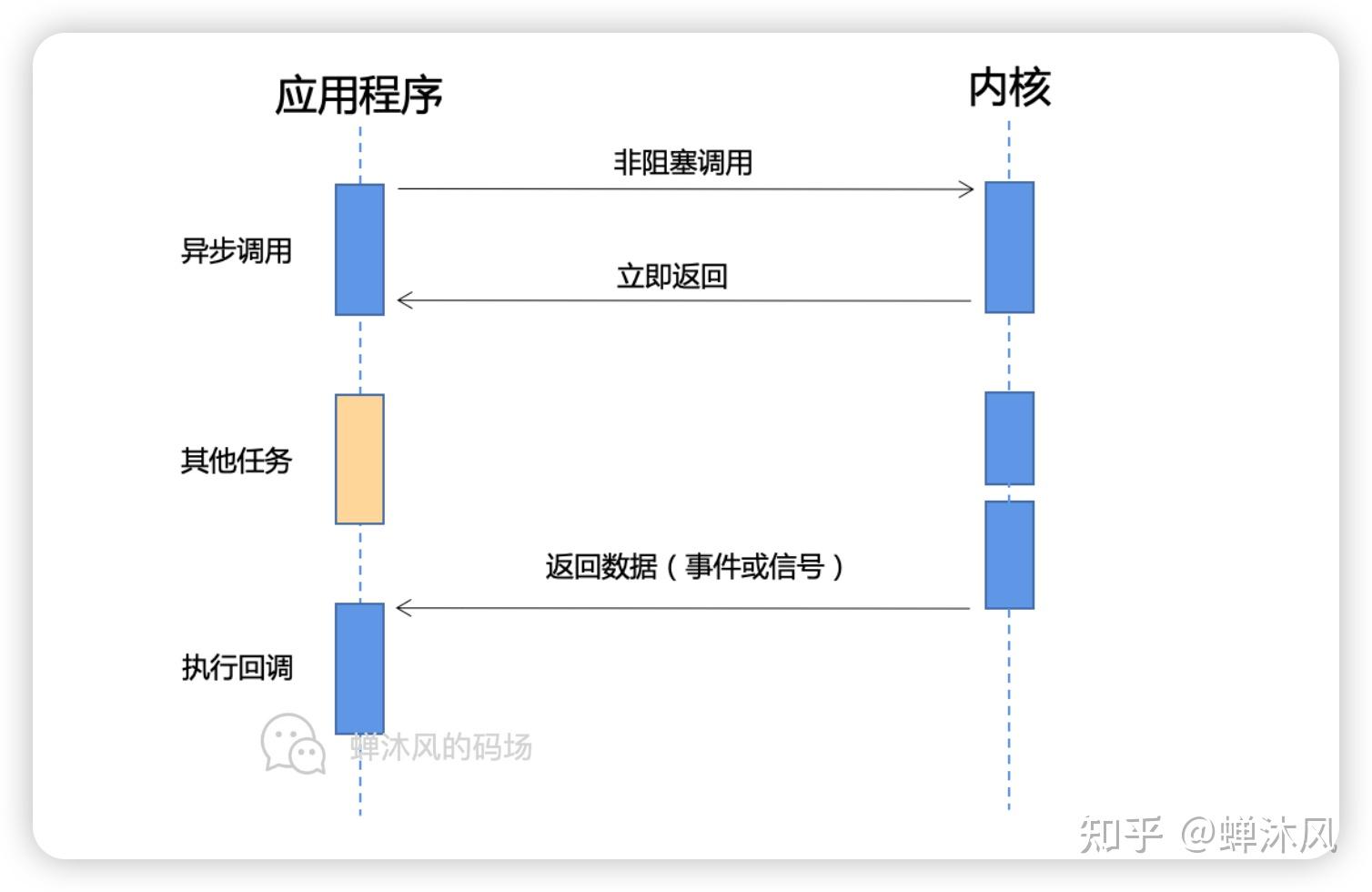

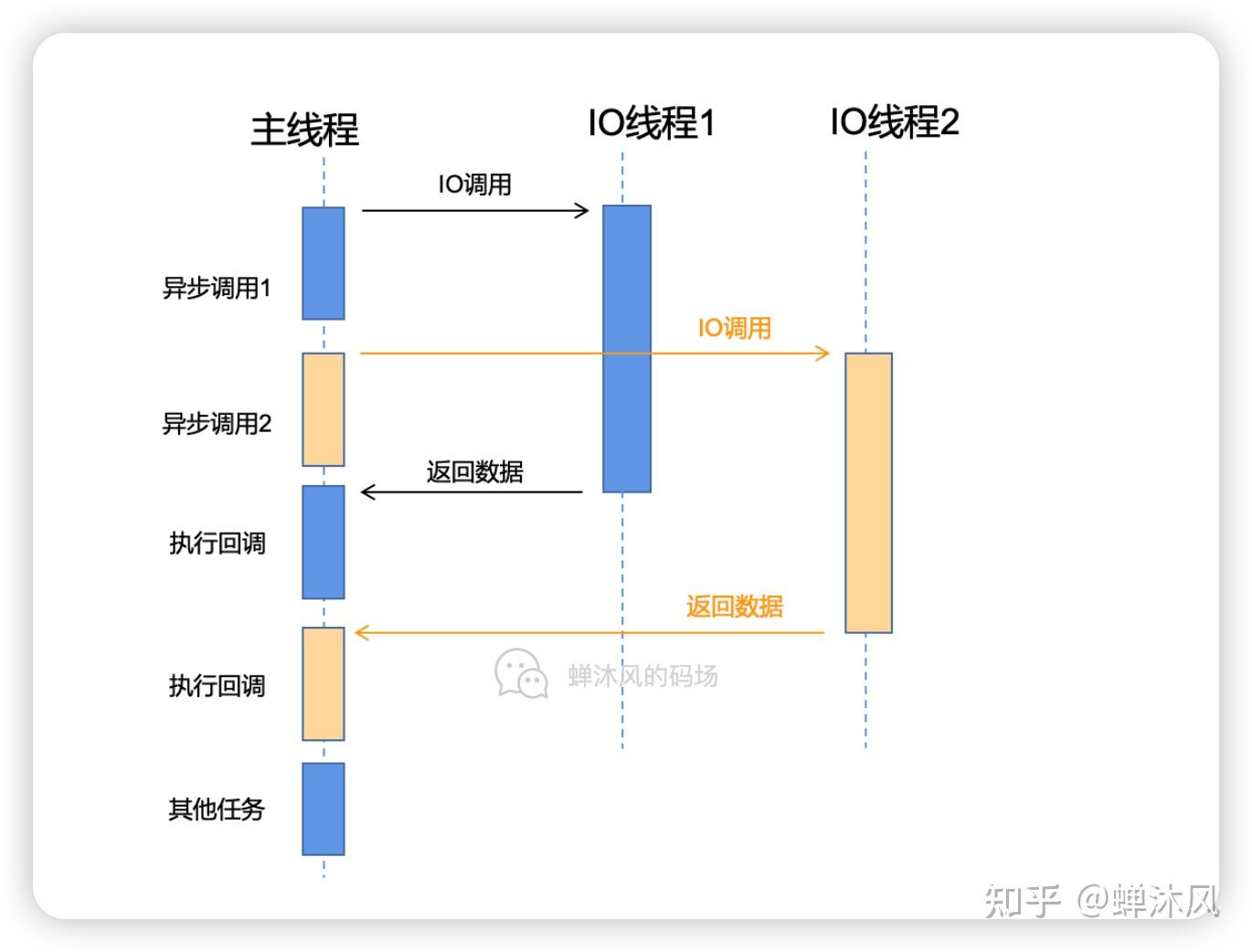

从这个定义中,我们看,首先1和7,这取决于软件框架的设计,如果软件框架可以beginXXX,然后立即返回,这就是一种异步调用,再比如javascript当中的异步HTTP调用,传入参数时提供一个回调函数,回调函数在完成时调用,再比如协程模型,调用接口后马上切换到其他协程继续执行,在完成时由框架切换回到协程中,这都是典型的异步接口设计。

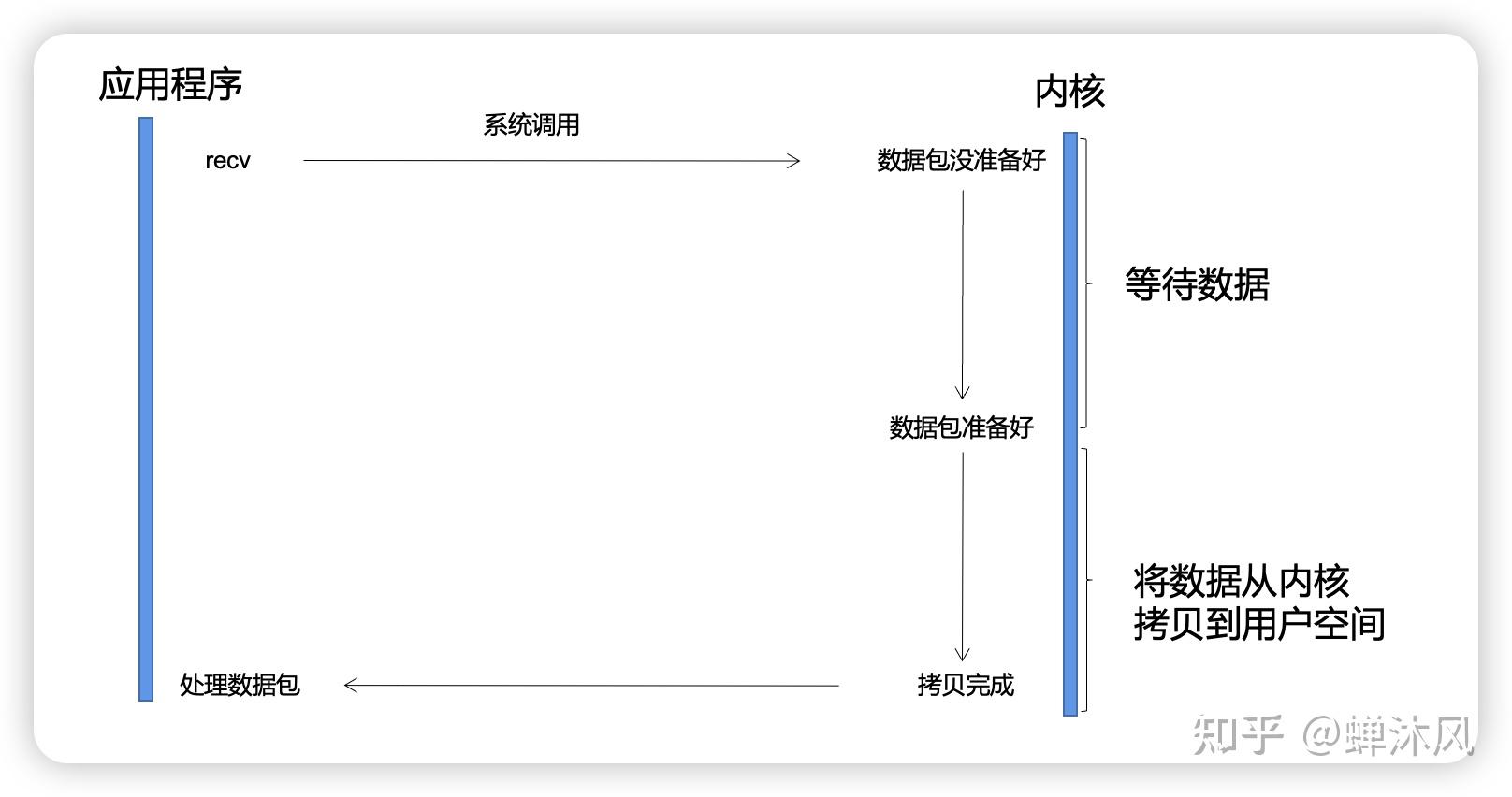

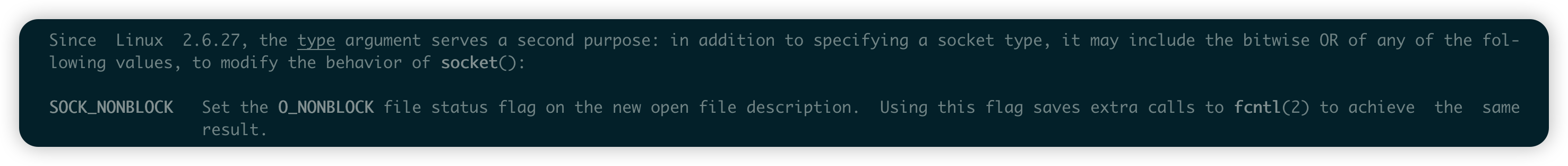

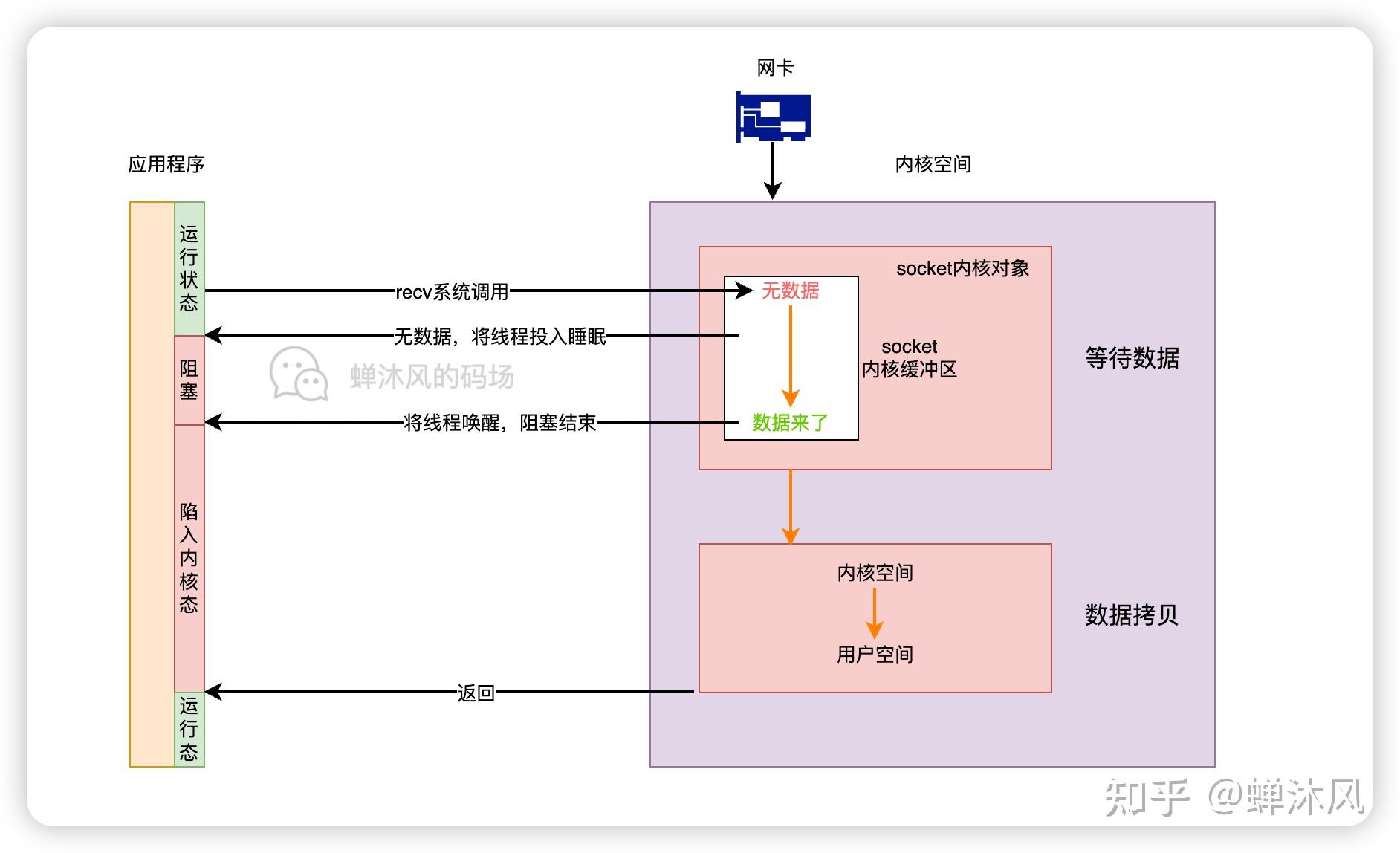

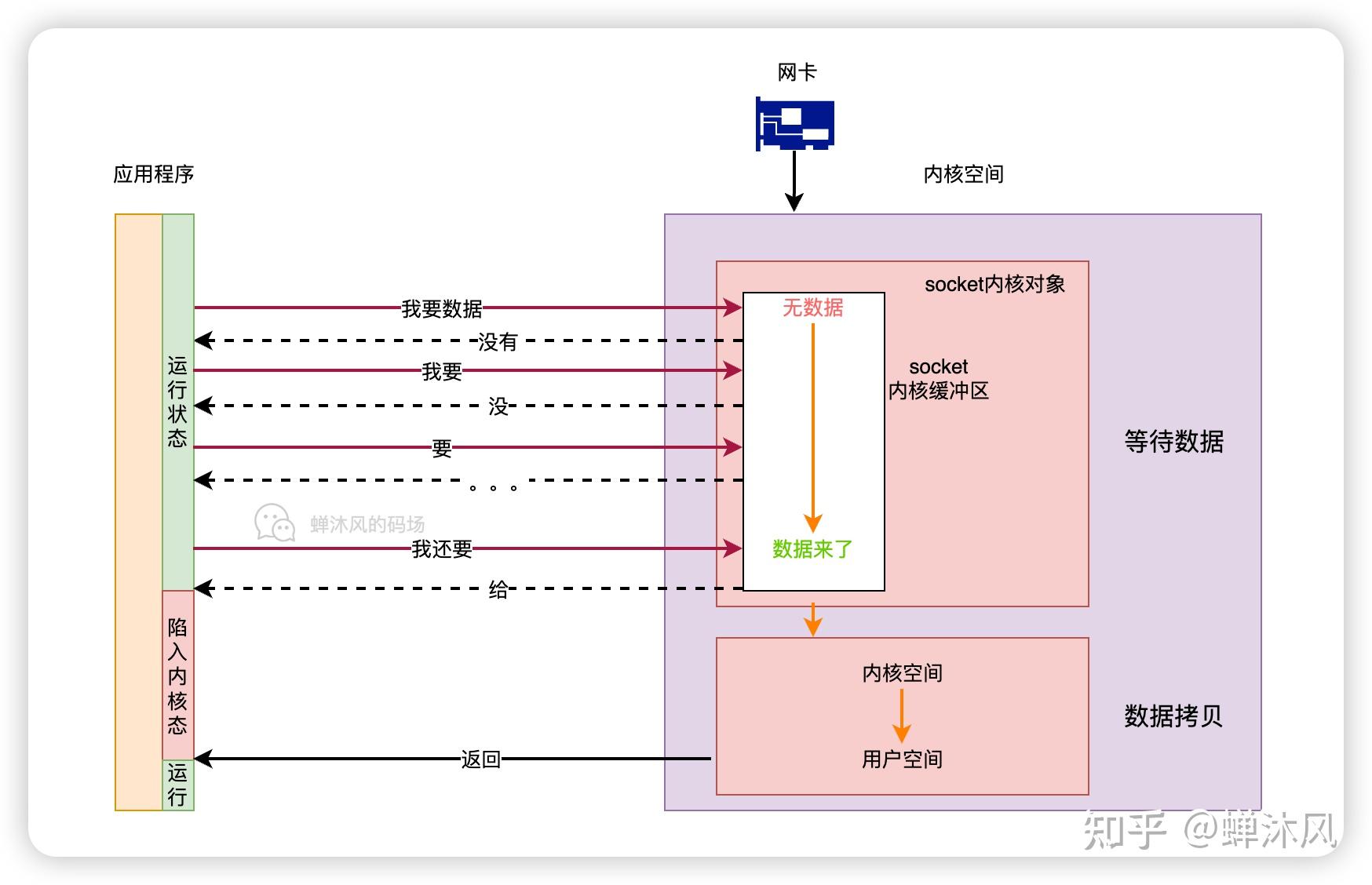

而2和6,其他答主已经说得很好了,其实都需要调用方自己把数据在内核和用户空间里搬来搬去,其实都是同步接口,除非是IOCP这样的专门的异步传输接口,所以这一级其实是同步的,阻塞与非阻塞的区别其实是影响调用接口的结果(在特定条件下是否提前返回结果),而不是调用方式。

3和5,内核一般通过缓冲区,使用DMI来传输数据,所以这一步又是异步的。

4,以太网是个同步时序逻辑,随信号传输时钟,必须两边设备同时就绪了才能开始传输数据,这又是同步的。

总结来说,讨论究竟是异步还是同步,一定要严格说明说的是哪一部分。其他答主说非阻塞是同步而不是异步,这毫无疑问是正确的,然而说某个框架是异步IO的框架,这也是正确的,因为说的其实是框架提供给业务代码的接口是异步的,不管是回调还是协程,比如说我们可以说某个库是异步的HTTPClient,并没有什么问题,因为说的是给业务代码的接口。由于通常异步的框架都需要在2中使用非阻塞的接口,的确会有很多人把非阻塞和异步混为一谈。

Python 压根就没有变量的概念。

用C或C++的变量概念去理解python就会一头雾水。

C、C++中的变量

C/C++中的变量的概念是面向内存的。

所以你要声明一个变量:表明空间大小,存储的格式(整数,浮点),以及一个永久不变的名字指向这个变量。

python只有name和object

a = 3

- 这个语句中 a 是一个名字, 3 是一个object

- 这个语句其实并不是什么赋值

- 而是干了以下三件事

- 创建name a

- 创建object 3

- 将name a 关联到 3这个object

- 以后就可以用a来调用3这个object

所有name在创建时必须关联到一个object。

name可以在创建以后指向任何一个object(包括不同类型)。

所以name本身没有类别,他关联的object是有类别的。

在python中可以使用type(name)来查看name关联的object的类型。

进阶回答

Python的数据模型(参见手册章3)

- python所有的数据都用object(对象)表示

- 对象在创建时有以下属性

- 标识,唯一识别,不可改变,通过id(obj)查看

- 类型,不可改变

- 值,根据类型形式分为mutable(可变),immutable(不可变)

Name(参见手册9.1 以及此文)

对象是用来使用的,比如参与表达式运算,或作为函数参数传递

python并不直接使用object,而是使用name的间接方式:

- 将name关联到object,然后name就可以用在表达式。

- 一个object可以被多个name关联。

- name总是存在于特定的namespace中

直观比喻:

- 对象,就像一个人,出生时就分配身份证ID,这个终身不变。

- 人可以有不同的name(小明,儿子,父亲,老公)但在特定情境下(namespace)都指的是同一个人。

- 不同情境下(namespace),name可能指代不同人,比如每个家庭都有一个老公。

python语法 “=”的含义

C语言中的等号是赋值,而python中的等号大不相同

等号有以下几种形式( 参见7.2 assignment operator10.3.1 )

对于等号左边是单一目标的定义

1,name = object

- 目标是indentifier(name)

- 将object关联到当前namespace,

- 如果当前namespace没有这个name就创建

2,mutable.attr=object

- 目标是一个可变对象的属性

- 对象属性被修改为(或者说指向)object

这个与C中的把等号右边的值放入左边的存储空间的概念完全不同。其它的类型赋值语句可以自己看手册。

对象的可变与不可变

python奇特的可变数据

- numbers(整数,浮点,布尔等)不可变,对!不可修改

- list,dict之类的容器类对象,是可变对象

- 注意,容器实际存储的是对象的reference

- 可变是指reference可变,也就是可以把reference指向新的object

- 语法上

- a=list[0]返回的是list的0位置reference关联的object的值

- list[0]=4,实际是将list的0位置reference改成关联到4这个对象

- 也就是说,python压根就不能直接修改基础对象的值,只能修改容器中的renference

几个小实验

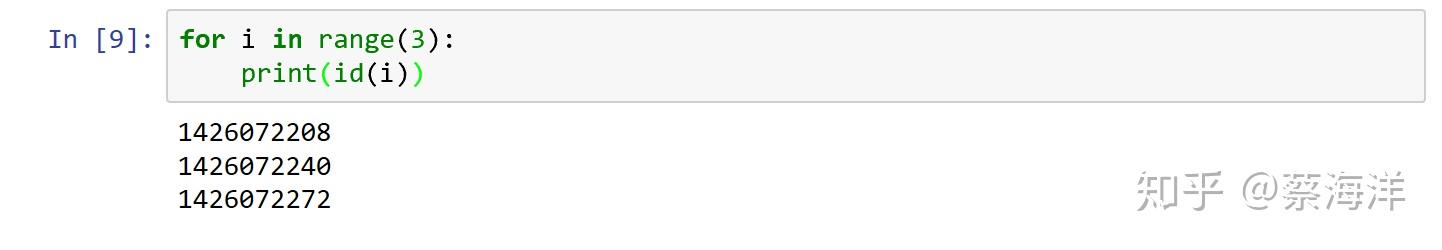

这个测试中

- 如果按C语言,对I存储空间赋值理解,id应该不变,但事实是变的

- 以python的name关联来理解,每个循环步骤,i关联到不同的数字object,所以ID不同

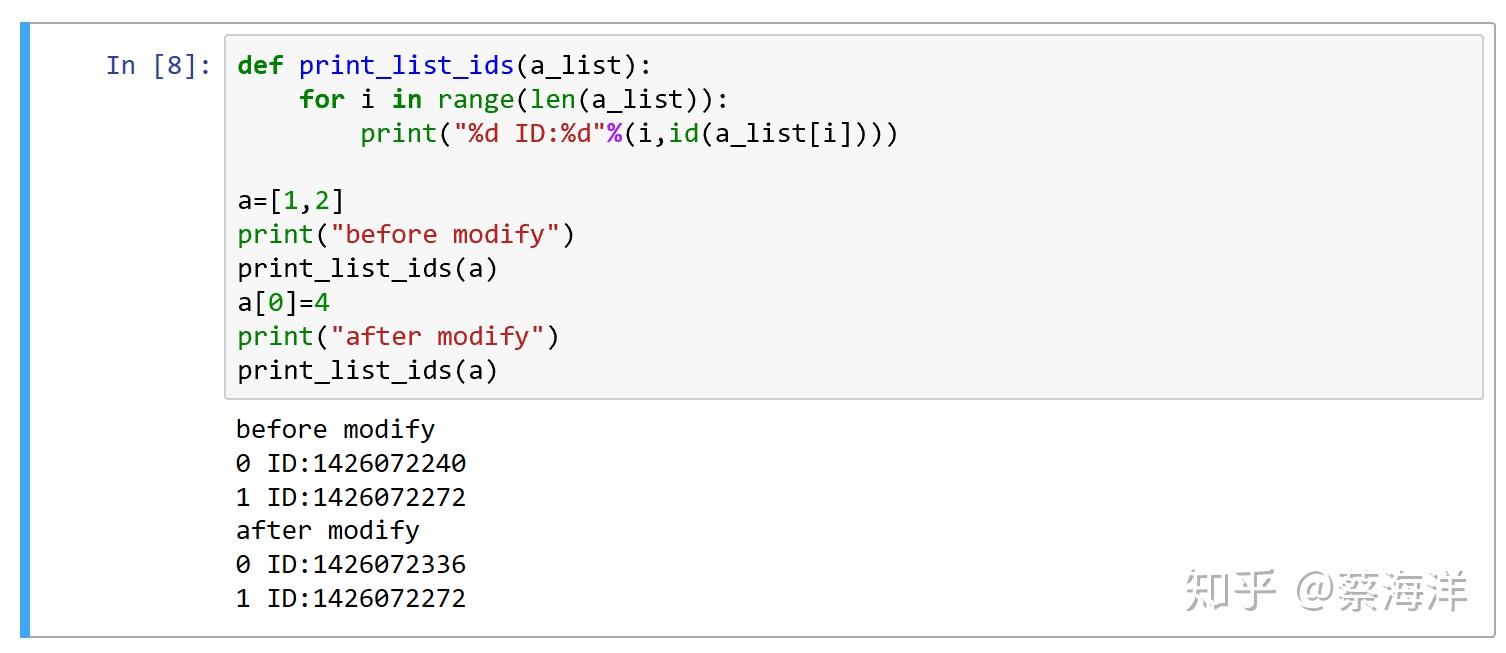

这个试验中

- 修改list,0位置的中的值,导致0位置ID的变化

- 说明list存储的是reference,

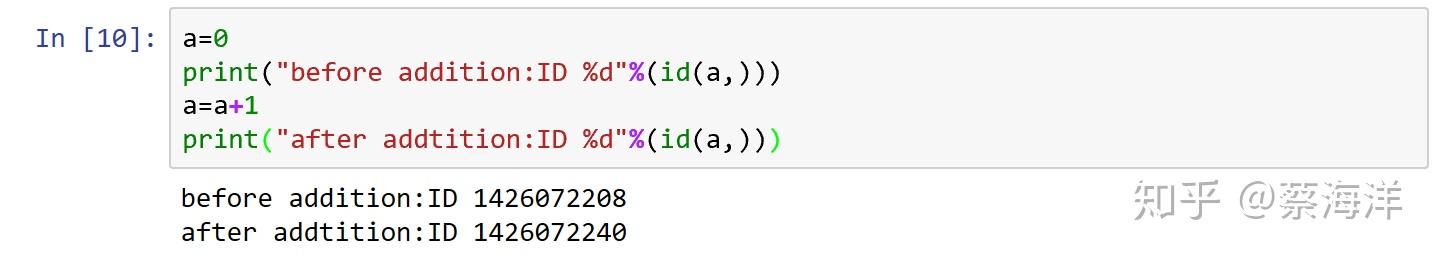

这个试验中

- a在做加法后id变了,也就是不是同一个object了

- 这与C语言的赋值大不相同

- python只有对象和name,基础的数据不可修改,所以在加法后创建了新的object用于存储结果,然后重新关联到name a

写在最后

相比C和C++语言,python的概念模型显得很特别。它让编程者,更关注与数据对象的操作,而不是数据存储。这使得编程者能快速的实现想法,而不过多专注于存储细节。

当然要使用好python,就要按它的思维方式去思考,这对于从C、C++这种以内存为基础的编程模式转换过来的人来说,可能是一个挑战。但你只要用python,name vs object的思维,很多疑惑都会消除。

这个问题非常不错,由于side car 模式的兴起,感觉本机网络 IO 用的越来越多了,所以我特地把该问题挖出来答一答。

不过我想把这个问题再丰富丰富,讨论起来更带劲!

- 127.0.0.1 本机网络 IO 需要经过网卡吗?

- 数据包在内核中是个什么走向,和外网发送相比流程上有啥差别?

- 用本机 ip(例如192.168.x.x) 和用 127.0.0.1 性能上有差别吗?

这里先直接把结论抛出来。

- 127.0.0.1 本机网络 IO 不经过网卡

- 本机网络 IO 过程除了不过网卡,其它流程如内核协议栈还都得走。

- 用本机 ip(例如192.168.x.x) 和用 127.0.0.1 性能没有大差别

内容来源于本人公-众-号: 开发内功修炼, 欢迎关注!

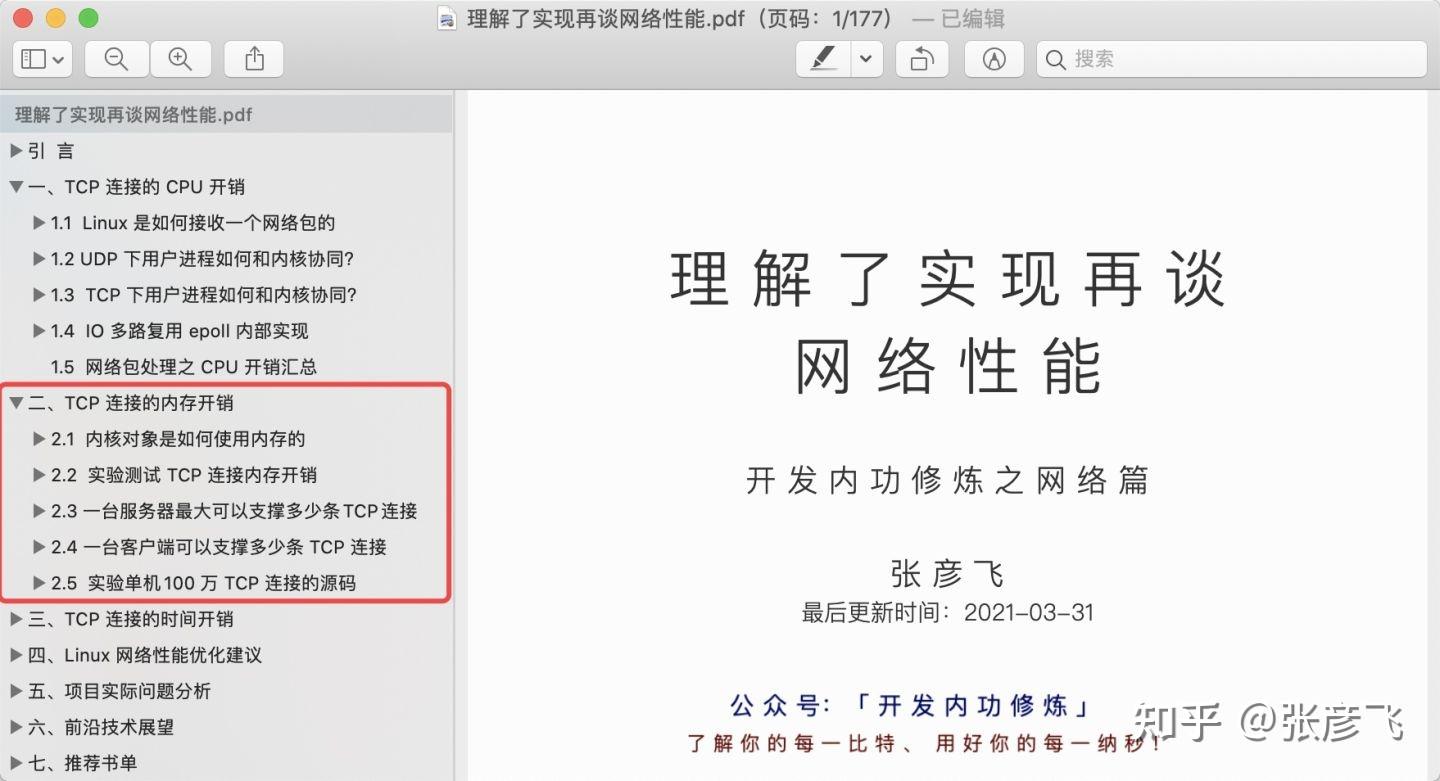

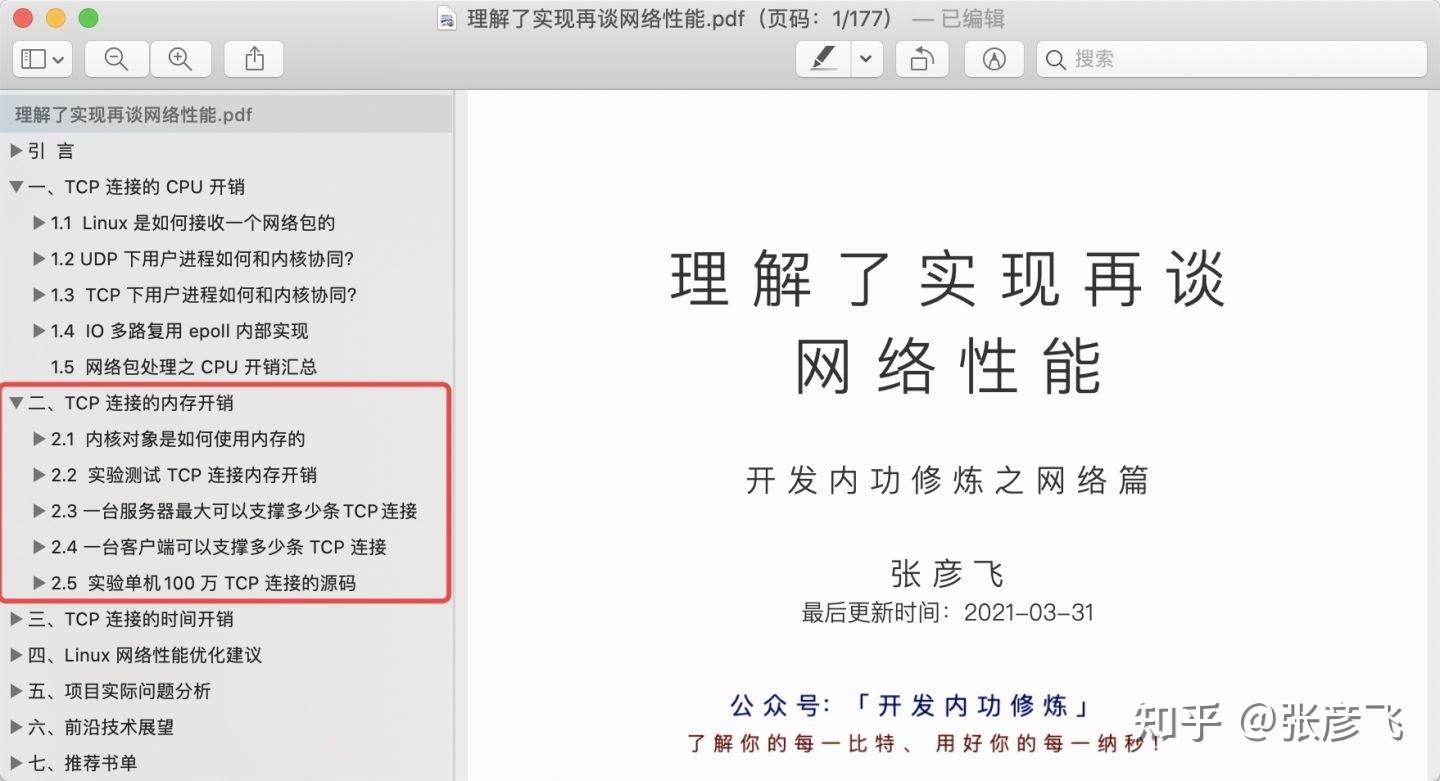

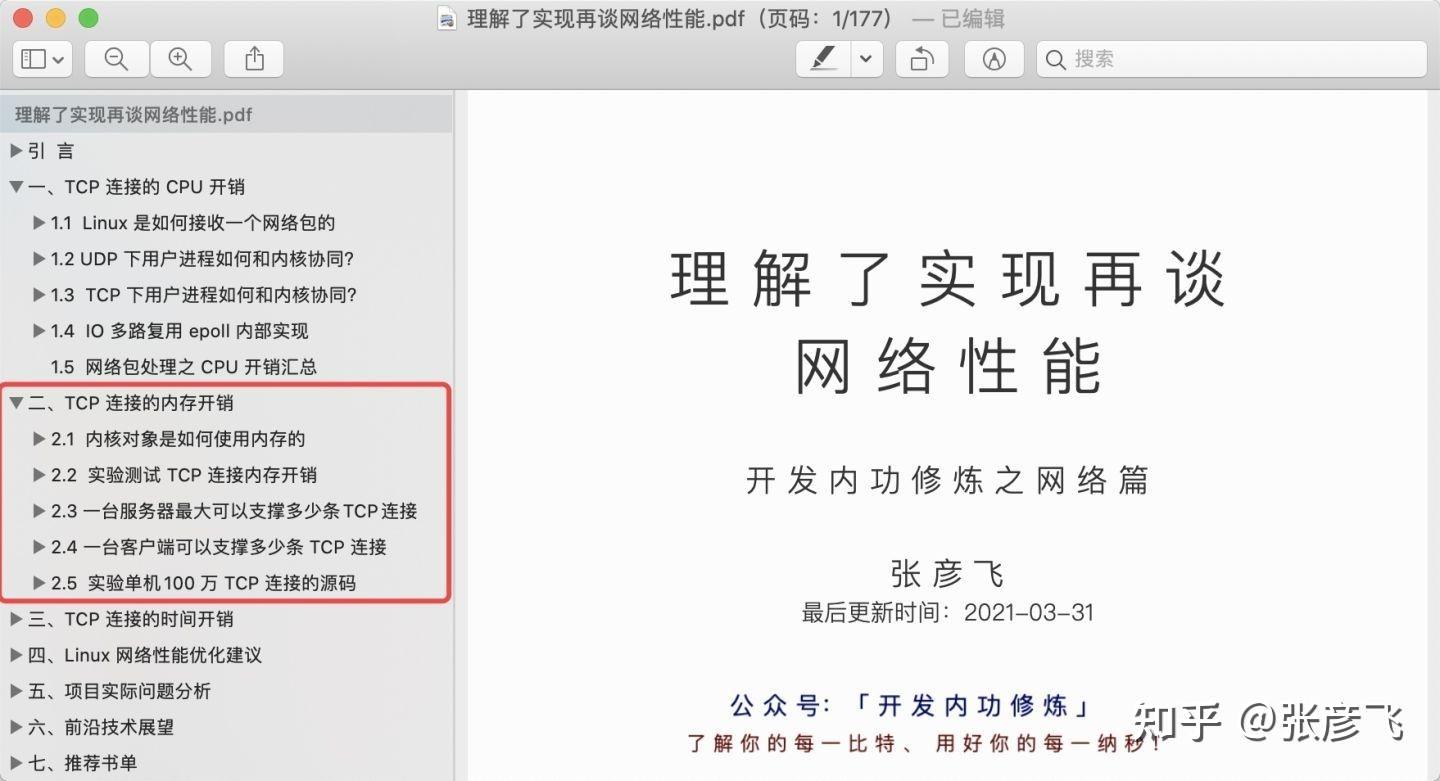

另外我把我对网络是如何收包的,如何使用 CPU,如何使用内存的对于内存的都深度分析了一下,还增加了一些性能优化建议和前沿技术展望等,最终汇聚出了这本《理解了实现再谈网络性能》。在此无私分享给大家。

下载链接传送门:《理解了实现再谈网络性能》

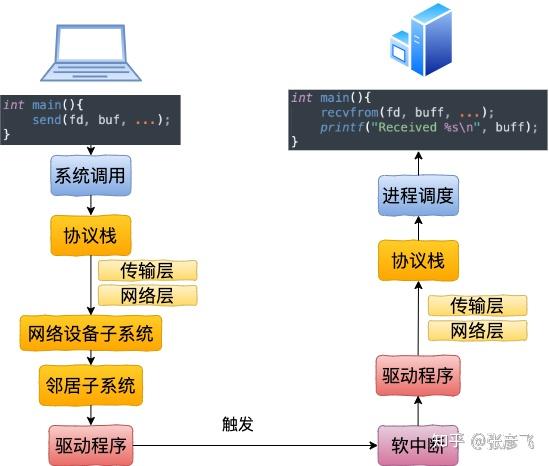

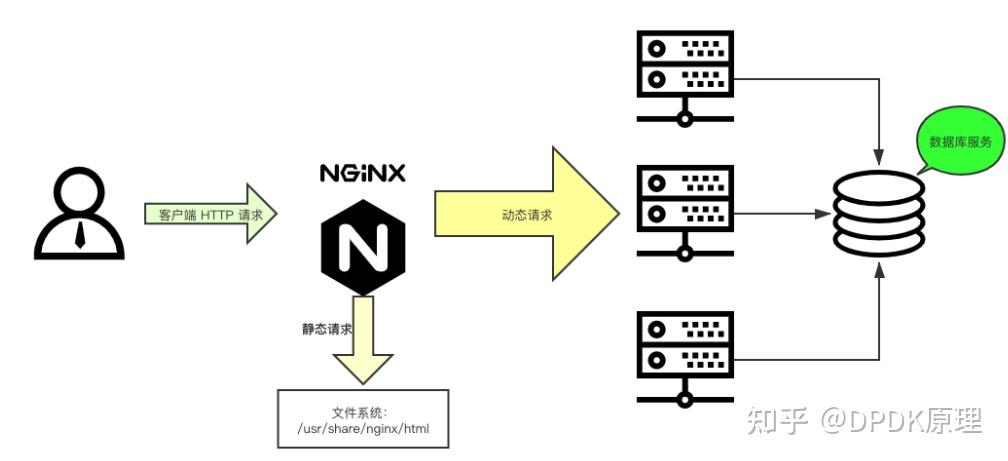

在开始讲述本机通信过程之前,我们还是先回顾一下跨机网络通信。

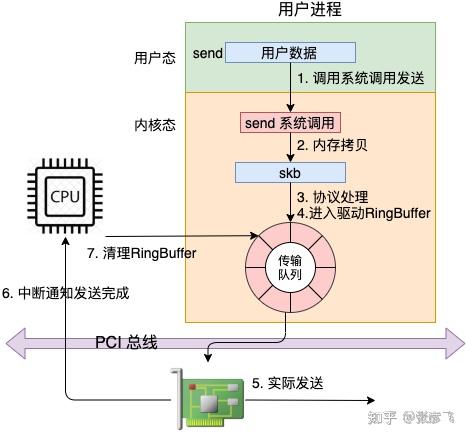

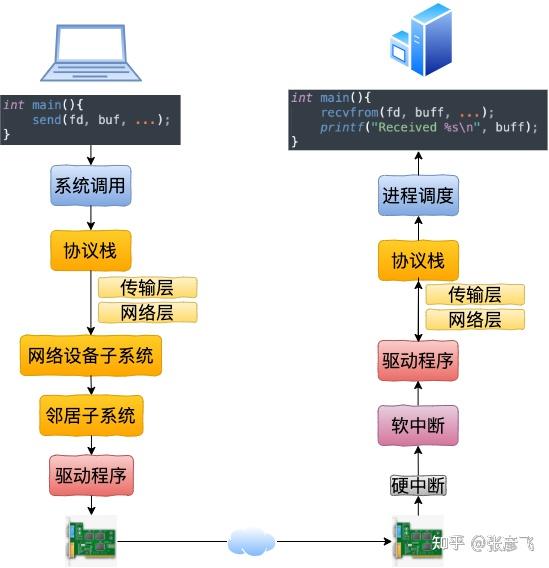

从 send 系统调用开始,直到网卡把数据发送出去,整体流程如下:

在这幅图中,我们看到用户数据被拷贝到内核态,然后经过协议栈处理后进入到了 RingBuffer 中。随后网卡驱动真正将数据发送了出去。当发送完成的时候,是通过硬中断来通知 CPU,然后清理 RingBuffer。

不过上面这幅图并没有很好地把内核组件和源码展示出来,我们再从代码的视角看一遍。

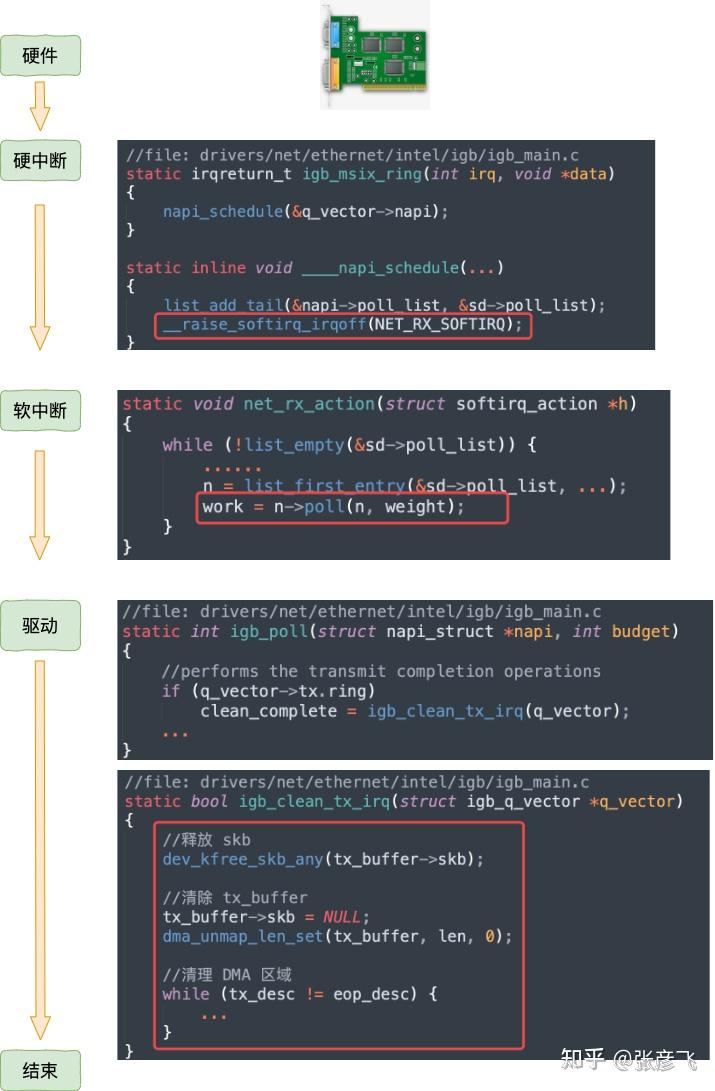

等网络发送完毕之后。网卡在发送完毕的时候,会给 CPU 发送一个硬中断来通知 CPU。收到这个硬中断后会释放 RingBuffer 中使用的内存。

更详细的分析过程参见:

25 张图,一万字,拆解 Linux 网络包发送过程

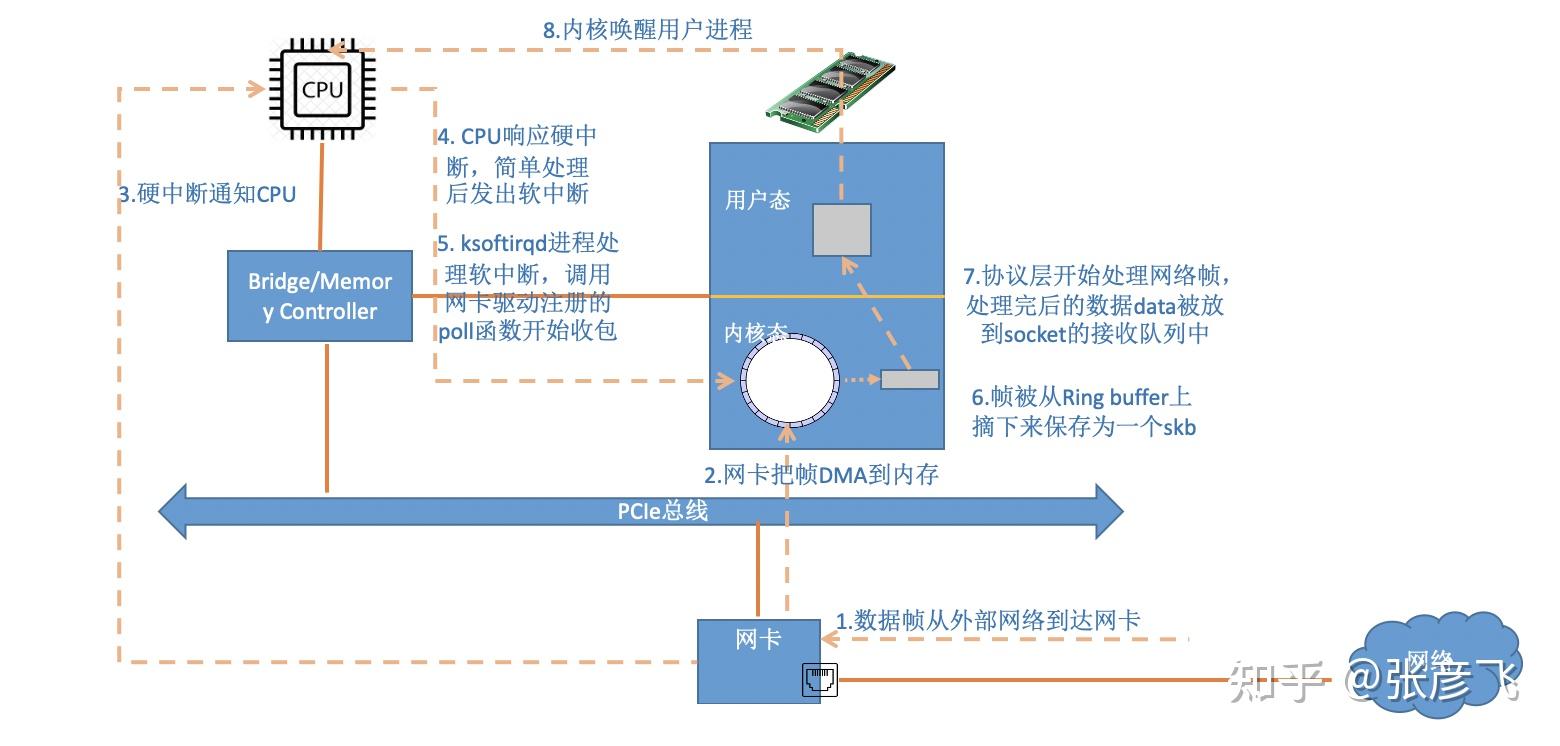

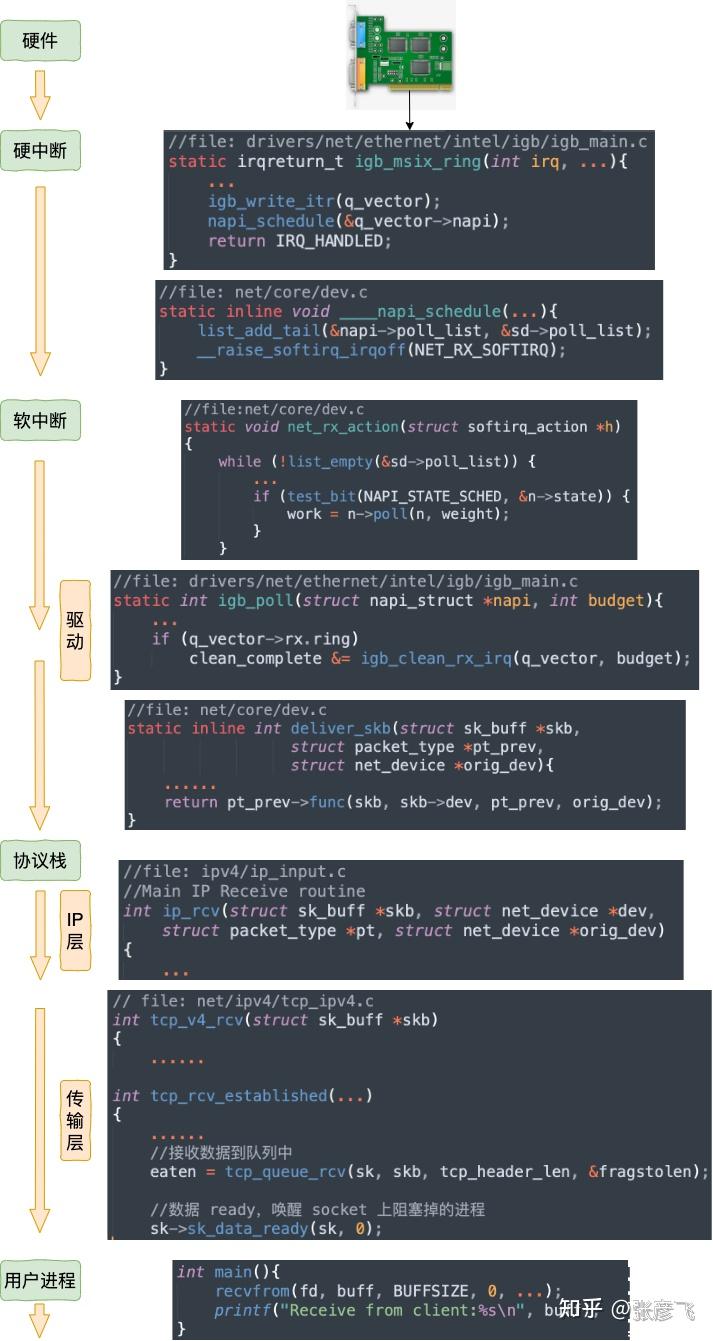

当数据包到达另外一台机器的时候,Linux 数据包的接收过程开始了。

当网卡收到数据以后,向 CPU 发起一个中断,以通知 CPU 有数据到达。当CPU收到中断请求后,会去调用网络驱动注册的中断处理函数,触发软中断。ksoftirqd 检测到有软中断请求到达,开始轮询收包,收到后交由各级协议栈处理。当协议栈处理完并把数据放到接收队列的之后,唤醒用户进程(假设是阻塞方式)。

我们再同样从内核组件和源码视角看一遍。

详细的接收过程参见这篇文章:图解Linux网络包接收过程

在第一节中,我们看到了跨机时整个网络发送过程(嫌第一节流程图不过瘾,想继续看源码了解细节的同学可以参考 拆解 Linux 网络包发送过程) 。

在本机网络 IO 的过程中,流程会有一些差别。为了突出重点,将不再介绍整体流程,而是只介绍和跨机逻辑不同的地方。有差异的地方总共有两个,分别是路由和驱动程序。

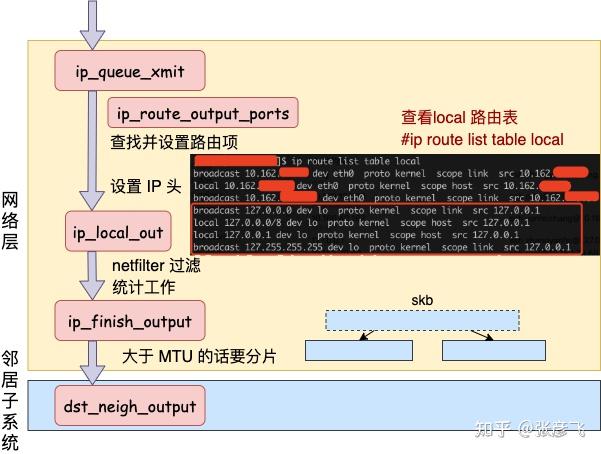

发送数据会进入协议栈到网络层的时候,网络层入口函数是 ip_queue_xmit。在网络层里会进行路由选择,路由选择完毕后,再设置一些 IP 头、进行一些 netfilter 的过滤后,将包交给邻居子系统。

对于本机网络 IO 来说,特殊之处在于在 local 路由表中就能找到路由项,对应的设备都将使用 loopback 网卡,也就是我们常见的 lo。

我们来详细看看路由网络层里这段路由相关工作过程。从网络层入口函数 ip_queue_xmit 看起。

//file: net/ipv4/ip_output.c int ip_queue_xmit(struct sk_buff *skb, struct flowi *fl) { //检查 socket 中是否有缓存的路由表 rt = (struct rtable *)__sk_dst_check(sk, 0); if (rt == NULL) { //没有缓存则展开查找 //则查找路由项, 并缓存到 socket 中 rt = ip_route_output_ports(...); sk_setup_caps(sk, &rt->dst); }查找路由项的函数是 ip_route_output_ports,它又依次调用到 ip_route_output_flow、__ip_route_output_key、fib_lookup。调用过程省略掉,直接看 fib_lookup 的关键代码。

//file:include/net/ip_fib.h static inline int fib_lookup(struct net *net, const struct flowi4 *flp, struct fib_result *res) { struct fib_table *table; table = fib_get_table(net, RT_TABLE_LOCAL); if (!fib_table_lookup(table, flp, res, FIB_LOOKUP_NOREF)) return 0; table = fib_get_table(net, RT_TABLE_MAIN); if (!fib_table_lookup(table, flp, res, FIB_LOOKUP_NOREF)) return 0; return -ENETUNREACH; }在 fib_lookup 将会对 local 和 main 两个路由表展开查询,并且是先查 local 后查询 main。我们在 Linux 上使用命令名可以查看到这两个路由表, 这里只看 local 路由表(因为本机网络 IO 查询到这个表就终止了)。

#ip route list table local local 10.143.x.y dev eth0 proto kernel scope host src 10.143.x.y local 127.0.0.1 dev lo proto kernel scope host src 127.0.0.1从上述结果可以看出,对于目的是 127.0.0.1 的路由在 local 路由表中就能够找到了。fib_lookup 工作完成,返回__ip_route_output_key 继续。

//file: net/ipv4/route.c struct rtable *__ip_route_output_key(struct net *net, struct flowi4 *fl4) { if (fib_lookup(net, fl4, &res)) { } if (res.type == RTN_LOCAL) { dev_out = net->loopback_dev; ... } rth = __mkroute_output(&res, fl4, orig_oif, dev_out, flags); return rth; }对于是本机的网络请求,设备将全部都使用 net->loopback_dev,也就是 lo 虚拟网卡。

接下来的网络层仍然和跨机网络 IO 一样,最终会经过 ip_finish_output,最终进入到 邻居子系统的入口函数 dst_neigh_output 中。

本机网络 IO 需要进行 IP 分片吗?因为和正常的网络层处理过程一样会经过 ip_finish_output 函数。在这个函数中,如果 skb 大于 MTU 的话,仍然会进行分片。只不过 lo 的 MTU 比 Ethernet 要大很多。通过 ifconfig 命令就可以查到,普通网卡一般为 1500,而 lo 虚拟接口能有 65535。

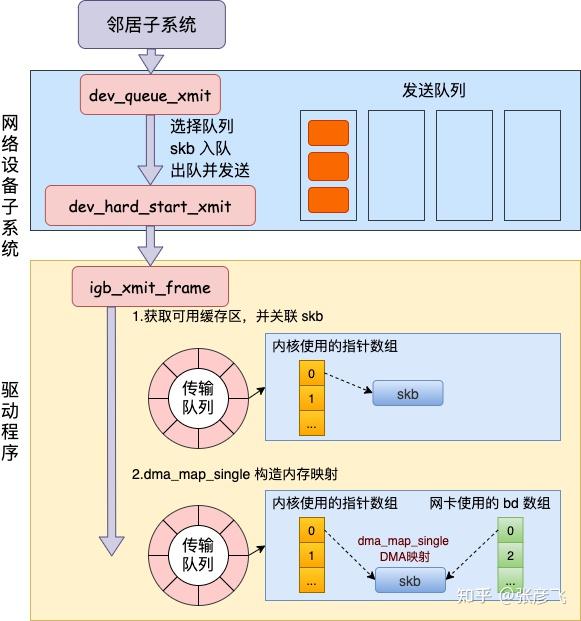

在邻居子系统函数中经过处理,进入到网络设备子系统(入口函数是 dev_queue_xmit)。

开篇我们提到的第三个问题的答案就在前面的网络层路由一小节中。但这个问题描述起来有点长,因此单独拉一小节出来。

问题:用本机 ip(例如192.168.x.x) 和用 127.0.0.1 性能上有差别吗?

前面看到选用哪个设备是路由相关函数 __ip_route_output_key 中确定的。

//file: net/ipv4/route.c struct rtable *__ip_route_output_key(struct net *net, struct flowi4 *fl4) { if (fib_lookup(net, fl4, &res)) { } if (res.type == RTN_LOCAL) { dev_out = net->loopback_dev; ... } rth = __mkroute_output(&res, fl4, orig_oif, dev_out, flags); return rth; }这里会查询到 local 路由表。

# ip route list table local local 10.162.*.* dev eth0 proto kernel scope host src 10.162.*.* local 127.0.0.1 dev lo proto kernel scope host src 127.0.0.1很多人在看到这个路由表的时候就被它给迷惑了,以为上面 10.162. 真的会被路由到 eth0(其中 10.162.. 是我的本机局域网 IP,我把后面两段用 * 号隐藏起来了)。

但其实内核在初始化 local 路由表的时候,把 local 路由表里所有的路由项都设置成了 RTN_LOCAL,不仅仅只是 127.0.0.1。这个过程是在设置本机 ip 的时候,调用 fib_inetaddr_event 函数完成设置的。

static int fib_inetaddr_event(struct notifier_block *this, unsigned long event, void *ptr) { switch (event) { case NETDEV_UP: fib_add_ifaddr(ifa); break; case NETDEV_DOWN: fib_del_ifaddr(ifa, NULL); //file:ipv4/fib_frontend.c void fib_add_ifaddr(struct in_ifaddr *ifa) { fib_magic(RTM_NEWROUTE, RTN_LOCAL, addr, 32, prim); }所以即使本机 IP,不用 127.0.0.1,内核在路由项查找的时候判断类型是 RTN_LOCAL,仍然会使用 net->loopback_dev。也就是 lo 虚拟网卡。

为了稳妥起见,飞哥再抓包确认一下。开启两个控制台窗口,一个对 eth0 设备进行抓包。因为局域网内会有大量的网络请求,为了方便过滤,这里使用一个特殊的端口号 8888。如果这个端口号在你的机器上占用了,那需要再换一个。

#tcpdump -i eth0 port 8888另外一个窗口使用 telnet 对本机 IP 端口发出几条网络请求。

#telnet 10.162.*.* 8888 Trying 10.162.129.56... telnet: connect to address 10.162.129.56: Connection refused这时候切回第一个控制台,发现啥反应都没有。说明包根本就没有过 eth0 这个设备。

再把设备换成 lo 再抓。当 telnet 发出网络请求以后,在 tcpdump 所在的窗口下看到了抓包结果。

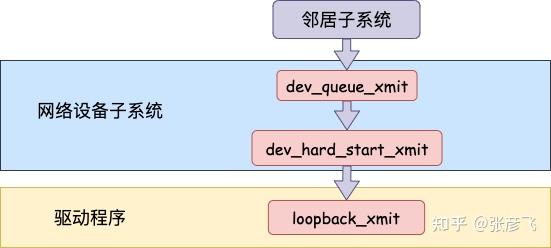

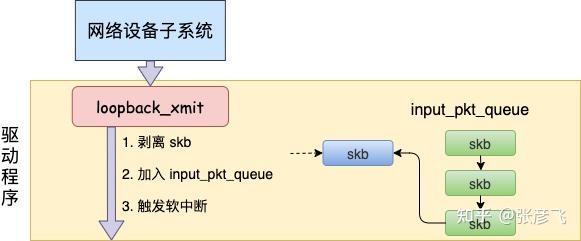

# tcpdump -i lo port 8888 tcpdump: verbose output suppressed, use -v or -vv for full protocol decode listening on lo, link-type EN10MB (Ethernet), capture size 65535 bytes 08:22:31. IP 10.162.*.*.62705 > 10.162.*.*.ddi-tcp-1: Flags [S], seq , win 43690, options [mss 65495,nop,wscale 8], length 0 08:22:31. IP 10.162.*.*.ddi-tcp-1 > 10.162.*.*.62705: Flags [R.], seq 0, ack , win 0, length 0网络设备子系统的入口函数是 dev_queue_xmit。简单回忆下之前讲述跨机发送过程的时候,对于真的有队列的物理设备,在该函数中进行了一系列复杂的排队等处理以后,才调用 dev_hard_start_xmit,从这个函数 再进入驱动程序来发送。在这个过程中,甚至还有可能会触发软中断来进行发送,流程如图:

但是对于启动状态的回环设备来说(q->enqueue 判断为 false),就简单多了。没有队列的问题,直接进入 dev_hard_start_xmit。接着中进入回环设备的“驱动”里的发送回调函数 loopback_xmit,将 skb “发送”出去。

我们来看下详细的过程,从 网络设备子系统的入口 dev_queue_xmit 看起。

//file: net/core/dev.c int dev_queue_xmit(struct sk_buff *skb) { q = rcu_dereference_bh(txq->qdisc); if (q->enqueue) {//回环设备这里为 false rc = __dev_xmit_skb(skb, q, dev, txq); goto out; } //开始回环设备处理 if (dev->flags & IFF_UP) { dev_hard_start_xmit(skb, dev, txq, ...); ... } }在 dev_hard_start_xmit 中还是将调用设备驱动的操作函数。

//file: net/core/dev.c int dev_hard_start_xmit(struct sk_buff *skb, struct net_device *dev, struct netdev_queue *txq) { //获取设备驱动的回调函数集合 ops const struct net_device_ops *ops = dev->netdev_ops; //调用驱动的 ndo_start_xmit 来进行发送 rc = ops->ndo_start_xmit(skb, dev); ... }

对于真实的 igb 网卡来说,它的驱动代码都在 drivers/net/ethernet/intel/igb/igb_main.c 文件里。顺着这个路子,我找到了 loopback 设备的“驱动”代码位置:drivers/net/loopback.c。 在 drivers/net/loopback.c

//file:drivers/net/loopback.c static const struct net_device_ops loopback_ops = { .ndo_init = loopback_dev_init, .ndo_start_xmit= loopback_xmit, .ndo_get_stats64 = loopback_get_stats64, };所以对 dev_hard_start_xmit 调用实际上执行的是 loopback “驱动” 里的 loopback_xmit。为什么我把“驱动”加个引号呢,因为 loopback 是一个纯软件性质的虚拟接口,并没有真正意义上的驱动。

//file:drivers/net/loopback.c static netdev_tx_t loopback_xmit(struct sk_buff *skb, struct net_device *dev) { //剥离掉和原 socket 的联系 skb_orphan(skb); //调用netif_rx if (likely(netif_rx(skb) == NET_RX_SUCCESS)) { } }在 skb_orphan 中先是把 skb 上的 socket 指针去掉了(剥离了出来)。

注意,在本机网络 IO 发送的过程中,传输层下面的 skb 就不需要释放了,直接给接收方传过去就行了。总算是省了一点点开销。不过可惜传输层的 skb 同样节约不了,还是得频繁地申请和释放。

接着调用 netif_rx,在该方法中 中最终会执行到 enqueue_to_backlog 中(netif_rx -> netif_rx_internal -> enqueue_to_backlog)。

//file: net/core/dev.c static int enqueue_to_backlog(struct sk_buff *skb, int cpu, unsigned int *qtail) { sd = &per_cpu(softnet_data, cpu); ... __skb_queue_tail(&sd->input_pkt_queue, skb); ... ____napi_schedule(sd, &sd->backlog); 在 enqueue_to_backlog 把要发送的 skb 插入 softnet_data->input_pkt_queue 队列中并调用 ____napi_schedule 来触发软中断。

//file:net/core/dev.c static inline void ____napi_schedule(struct softnet_data *sd, struct napi_struct *napi) { list_add_tail(&napi->poll_list, &sd->poll_list); __raise_softirq_irqoff(NET_RX_SOFTIRQ); }只有触发完软中断,发送过程就算是完成了。

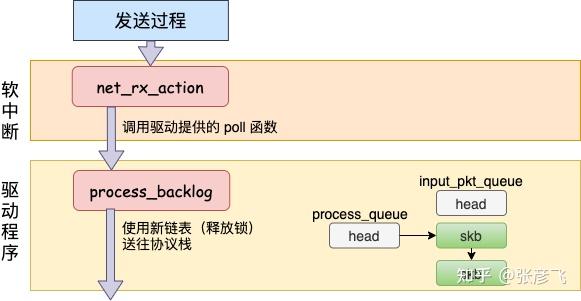

在跨机的网络包的接收过程中,需要经过硬中断,然后才能触发软中断。而在本机的网络 IO 过程中,由于并不真的过网卡,所以网卡实际传输,硬中断就都省去了。直接从软中断开始,经过 process_backlog 后送进协议栈,大体过程如图。

//file: net/core/dev.c static void net_rx_action(struct softirq_action *h){ while (!list_empty(&sd->poll_list)) { work = n->poll(n, weight); } }我们还记得对于 igb 网卡来说,poll 实际调用的是 igb_poll 函数。那么 loopback 网卡的 poll 函数是谁呢?由于poll_list 里面是 struct softnet_data 对象,我们在 net_dev_init 中找到了蛛丝马迹。

//file:net/core/dev.c static int __init net_dev_init(void) { for_each_possible_cpu(i) { sd->backlog.poll = process_backlog; } }原来struct softnet_data 默认的 poll 在初始化的时候设置成了 process_backlog 函数,来看看它都干了啥。

static int process_backlog(struct napi_struct *napi, int quota) { while(){ while ((skb = __skb_dequeue(&sd->process_queue))) { __netif_receive_skb(skb); } //skb_queue_splice_tail_init()函数用于将链表a连接到链表b上, //形成一个新的链表b,并将原来a的头变成空链表。 qlen = skb_queue_len(&sd->input_pkt_queue); if (qlen) skb_queue_splice_tail_init(&sd->input_pkt_queue, &sd->process_queue); } }这次先看对 skb_queue_splice_tail_init 的调用。源码就不看了,直接说它的作用是把 sd->input_pkt_queue 里的 skb 链到 sd->process_queue 链表上去。

然后再看 __skb_dequeue, __skb_dequeue 是从 sd->process_queue 上取下来包来处理。这样和前面发送过程的结尾处就对上了,发送过程是把包放到了 input_pkt_queue 队列里。

最后调用 __netif_receive_skb 将数据送往协议栈。在此之后的调用过程就和跨机网络 IO 又一致了。

送往协议栈的调用链是 __netif_receive_skb => __netif_receive_skb_core => deliver_skb 后 将数据包送入到 ip_rcv 中(详情参见图解Linux网络包接收过程 一文中的 3.3 小节)。

网络再往后依次是传输层,最后唤醒用户进程。

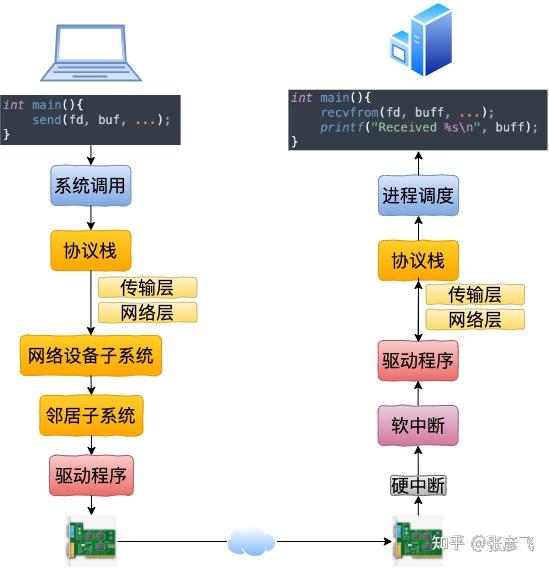

我们来总结一下本机网络 IO 的内核执行流程。

回想下跨机网络 IO 的流程是

我们现在可以回顾下开篇的三个问题啦。

1)127.0.0.1 本机网络 IO 需要经过网卡吗? 通过本文的叙述,我们确定地得出结论,不需要经过网卡。即使了把网卡拔了本机网络是否还可以正常使用的。

2)数据包在内核中是个什么走向,和外网发送相比流程上有啥差别? 总的来说,本机网络 IO 和跨机 IO 比较起来,确实是节约了驱动上的一些开销。发送数据不需要进 RingBuffer 的驱动队列,直接把 skb 传给接收协议栈(经过软中断)。但是在内核其它组件上,可是一点都没少,系统调用、协议栈(传输层、网络层等)、设备子系统整个走了一个遍。连“驱动”程序都走了(虽然对于回环设备来说只是一个纯软件的虚拟出来的东东)。所以即使是本机网络 IO,切忌误以为没啥开销就滥用。

3)用本机 ip(例如192.168.x.x) 和用 127.0.0.1 性能上有差别吗? 很多人的直觉是走网卡,但正确结论是和 127.0.0.1 没有差别,都是走虚拟的环回设备 lo。

这是因为内核在设置 ip 的时候,把所有的本机 ip 都初始化 local 路由表里了,而且类型写死 RTN_LOCAL。在后面的路由项选择的时候发现类型是 RTN_LOCAL 就会选择 lo 了。还不信的话你也动手抓包试试!

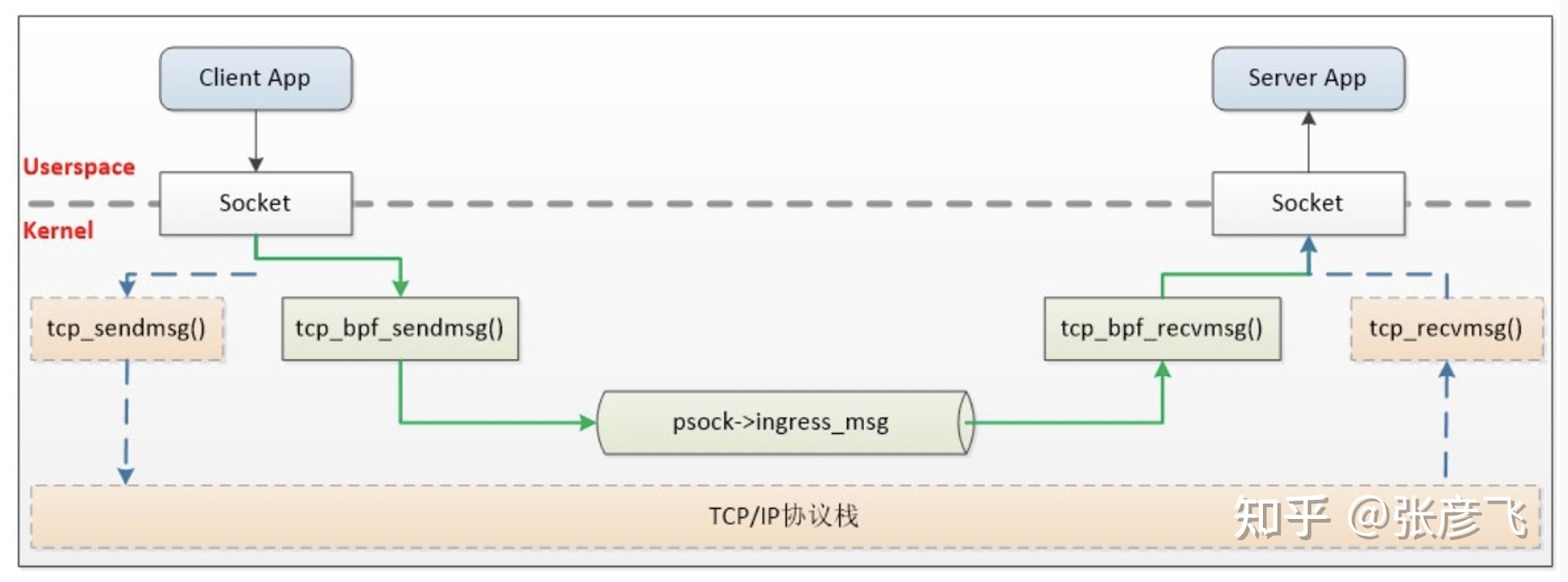

最后再提一下,业界有公司基于 ebpf 的 sockmap 和 sk redirect 功能研发了自己的 sockops 组件,用来加速 istio 架构中 sidecar 代理和本地进程之间的通信。通过引入 BPF,才算是绕开了内核协议栈的开销,原理如下。

飞哥写了一本电子书。这本电子书是对网络性能进行拆解,把性能拆分为三个角度:CPU 开销、内存开销等。

具体到某个角度比如 CPU,那我需要给自己解释清楚网络包是怎么从网卡到内核中的,内核又是通过哪些方式通知进程的。只有理解清楚了这些才能真正把握网络对 CPU 的消耗。

对于内存角度也是一样,只有理解了内核是如何使用内存,甚至需要哪些内核对象都搞清楚,也才能真正理解一条 TCP 连接的内存开销。

除此之外我还增加了一些性能优化建议和前沿技术展望等,最终汇聚出了这本《理解了实现再谈网络性能》。在此无私分享给大家。

下载链接传送门:《理解了实现再谈网络性能》

另外飞哥经常会收到读者的私信,询问可否推荐一些书继续深入学习内功。所以我干脆就写了篇文章。把能搜集到的电子版也帮大家汇总了一下,取需!

答读者问,能否推荐几本有价值的参考书(含下载地址)

Github: https://github.com/yanfeizhang/

------------------------------ 华丽的分割线 ----------------------------------------

2021-12-22 日追更

在上次回答完后,有读者在评论区里希望飞哥能再分析一下 Unix Domain Socket。最近终于抽空把这个也深入研究了一下。

今天我们将分析 Unix Domain Socket 的连接建立过程、数据发送过程等内部工作原理。你将理解为什么这种方式的性能比 127.0.0.1 要好很多。最后我们还给出了实际的性能测试对比数据。

相信你已经迫不及待了,别着急,让我们一一展开细说!

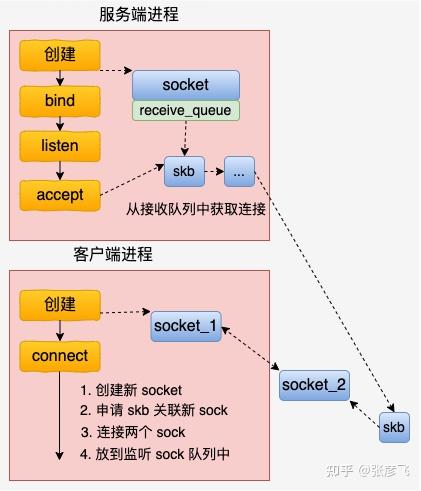

总的来说,基于 UDS 的连接过程比 inet 的 socket 连接过程要简单多了。客户端先创建一个自己用的 socket,然后调用 connect 来和服务器建立连接。

在 connect 的时候,会申请一个新 socket 给 server 端将来使用,和自己的 socket 建立好连接关系以后,就放到服务器正在监听的 socket 的接收队列中。 这个时候,服务器端通过 accept 就能获取到和客户端配好对的新 socket 了。

总的 UDS 的连接建立流程如下图。

内核源码中最重要的逻辑在 connect 函数中,我们来简单展开看一下。 unix 协议族中定义了这类 socket 的所有方法,它位于 net/unix/af_unix.c 中。

//file: net/unix/af_unix.c static const struct proto_ops unix_stream_ops = { .family = PF_UNIX, .owner = THIS_MODULE, .bind = unix_bind, .connect = unix_stream_connect, .socketpair = unix_socketpair, .listen = unix_listen, ... };我们找到 connect 函数的具体实现,unix_stream_connect。

//file: net/unix/af_unix.c static int unix_stream_connect(struct socket *sock, struct sockaddr *uaddr, int addr_len, int flags) { struct sockaddr_un *sunaddr = (struct sockaddr_un *)uaddr; ... // 1. 为服务器侧申请一个新的 socket 对象 newsk = unix_create1(sock_net(sk), NULL); // 2. 申请一个 skb,并关联上 newsk skb = sock_wmalloc(newsk, 1, 0, GFP_KERNEL); ... // 3. 建立两个 sock 对象之间的连接 unix_peer(newsk) = sk; newsk->sk_state = TCP_ESTABLISHED; newsk->sk_type = sk->sk_type; ... sk->sk_state = TCP_ESTABLISHED; unix_peer(sk) = newsk; // 4. 把连接中的一头(新 socket)放到服务器接收队列中 __skb_queue_tail(&other->sk_receive_queue, skb); }主要的连接操作都是在这个函数中完成的。和我们平常所见的 TCP 连接建立过程,这个连接过程简直是太简单了。没有三次握手,也没有全连接队列、半连接队列,更没有啥超时重传。

直接就是将两个 socket 结构体中的指针互相指向对方就行了。就是 unix_peer(newsk) = sk 和 unix_peer(sk) = newsk 这两句。

//file: net/unix/af_unix.c #define unix_peer(sk) (unix_sk(sk)->peer)当关联关系建立好之后,通过 __skb_queue_tail 将 skb 放到服务器的接收队列中。注意这里的 skb 里保存着新 socket 的指针,因为服务进程通过 accept 取出这个 skb 的时候,就能获取到和客户进程中 socket 建立好连接关系的另一个 socket。

怎么样,UDS 的连接建立过程是不是很简单!?

看完了连接建立过程,我们再来看看基于 UDS 的数据的收发。这个收发过程一样也是非常的简单。发送方是直接将数据写到接收方的接收队列里的。

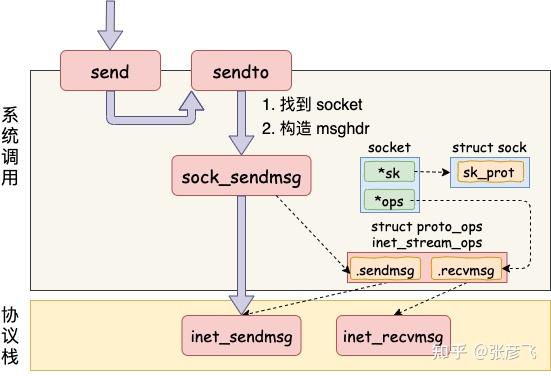

我们从 send 函数来看起。send 系统调用的源码位于文件 net/socket.c 中。在这个系统调用里,内部其实真正使用的是 sendto 系统调用。它只干了两件简单的事情,

第一是在内核中把真正的 socket 找出来,在这个对象里记录着各种协议栈的函数地址。 第二是构造一个 struct msghdr 对象,把用户传入的数据,比如 buffer地址、数据长度啥的,统统都装进去. 剩下的事情就交给下一层,协议栈里的函数 inet_sendmsg 了,其中 inet_sendmsg 函数的地址是通过 socket 内核对象里的 ops 成员找到的。大致流程如图。

在进入到协议栈 inet_sendmsg 以后,内核接着会找到 socket 上的具体协议发送函数。对于 Unix Domain Socket 来说,那就是 unix_stream_sendmsg。 我们来看一下这个函数

//file: static int unix_stream_sendmsg(struct kiocb *kiocb, struct socket *sock, struct msghdr *msg, size_t len) { // 1.申请一块缓存区 skb = sock_alloc_send_skb(sk, size, msg->msg_flags&MSG_DONTWAIT, &err); // 2.拷贝用户数据到内核缓存区 err = memcpy_fromiovec(skb_put(skb, size), msg->msg_iov, size); // 3. 查找socket peer struct sock *other = NULL; other = unix_peer(sk); // 4.直接把 skb放到对端的接收队列中 skb_queue_tail(&other->sk_receive_queue, skb); // 5.发送完毕回调 other->sk_data_ready(other, size); }和复杂的 TCP 发送接收过程相比,这里的发送逻辑简单简单到令人发指。申请一块内存(skb),把数据拷贝进去。根据 socket 对象找到另一端,直接把 skb 给放到对端的接收队列里了

接收函数主题是 unix_stream_recvmsg,这个函数中只需要访问它自己的接收队列就行了,源码就不展示了。所以在本机网络 IO 场景里,基于 Unix Domain Socket 的服务性能上肯定要好一些的。

为了验证 Unix Domain Socket 到底比基于 127.0.0.1 的性能好多少,我做了一个性能测试。 在网络性能对比测试,最重要的两个指标是延迟和吞吐。我从 Github 上找了个好用的测试源码:https://github.com/rigtorp/ipc-bench。 我的测试环境是一台 4 核 CPU,8G 内存的 KVM 虚机。

在延迟指标上,对比结果如下图。

可见在小包(100 字节)的情况下,UDS 方法的“网络” IO 平均延迟只有 2707 纳秒,而基于 TCP(访问 127.0.0.1)的方式下延迟高达 5690 纳秒。耗时整整是前者的两倍。

在包体达到 100 KB 以后,UDS 方法延迟 24 微秒左右(1 微秒等于 1000 纳秒),TCP 是 32 微秒,仍然高一截。这里低于 2 倍的关系了,是因为当包足够大的时候,网络协议栈上的开销就显得没那么明显了。

再来看看吞吐效果对比。

在小包的情况下,带宽指标可以达到 854 M,而基于 TCP 的 IO 方式下只有 386。

本文分析了基于 Unix Domain Socket 的连接创建、以及数据收发过程。其中数据收发的工作过程如下图。

相对比本机网络 IO 通信过程上,它的工作过程要清爽许多。其中 127.0.0.1 工作过程如下图。

我们也对比了 UDP 和 TCP 两种方式下的延迟和性能指标。在包体不大于 1KB 的时候,UDS 的性能大约是 TCP 的两倍多。所以,在本机网络 IO 的场景下,如果对性能敏感,可考虑使用 Unix Domain Socket。

看到这里留个赞再走呗!

也欢迎关注飞哥的公众号:开发内功修炼

没有人比我更有资格回答这一题,说多了都是泪.....

先说结论,很多高赞回答都不全面,本机相互通讯的流量是有可能通过物理网卡,这取决于目的地址使用哪类本机IP,具体来说很多高赞回答都提到了使用挂载到本地网卡上的IP进行通讯,比如下面的192.168.0.192和127.0.0.1都不会过物理网卡,这个结论是没问题的。

[root@ecs-a4d3 ~]# ifconfig -a

eth0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.0.192 netmask 255.255.255.0 broadcast 192.168.0.255

inet6 fe80::f816:3eff:fe1c:ef05 prefixlen 64 scopeid 0x20<link>

ether fa:16:3e:1c:ef:05 txqueuelen 1000 (Ethernet)

RX packets bytes (5.1 GiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets bytes (528.7 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536

inet 127.0.0.1 netmask 255.0.0.0

inet6 ::1 prefixlen 128 scopeid 0x10<host>

loop txqueuelen 1000 (Local Loopback)

RX packets 15 bytes 1416 (1.3 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 15 bytes 1416 (1.3 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

但是如果你用的是云服务器ECS,并使用弹性IP与本机通讯,那流量就是要过物理网卡了。

可能有细心的小伙伴会问ECS大多是虚拟机,过虚拟机的网卡又不一定过宿主机的物理网卡.....算了我直说了吧,我的个人博客没什么人访问,一直按流量计费,之前我一直用每小时curl弹性IP一次的方式进行健康监测,上个月一时手抽把sleep注掉了,结果半天不到就欠费了。

我猜你是想了解 epoll 为啥高性能吧!?

其实在理解 epoll 之前,得先理解一个事情,那就是进程阻塞切换的 CPU 开销。在高并发的网络 IO 下,性能的最大绊脚石就是 socket 在阻塞后导致的进程上下文切换。关于这个,我进行过实际的测试。大约一次进程上下文切换的开销是 3-5 微秒左右。

张彦飞:进程/线程上下文切换会用掉你多少CPU?

至于说同步阻塞网络 IO 下的进程上下文切换是如何发生的,我也写过这么一篇

图解 | 深入理解高性能网络开发路上的绊脚石 - 同步阻塞网络 IO

可能有的同学会说,3 - 5 微秒的开销看起来还好啊。但是你要知道的是,从我们开发工程师的角度来看,这段时间里 CPU 吭哧吭哧的执行的切换工作对我们来说其实是无用功。

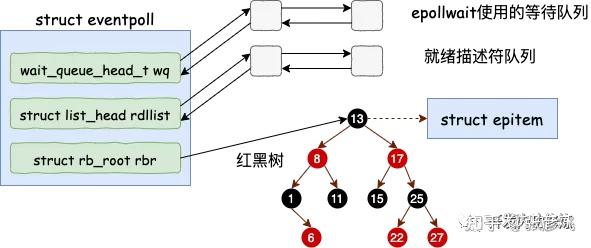

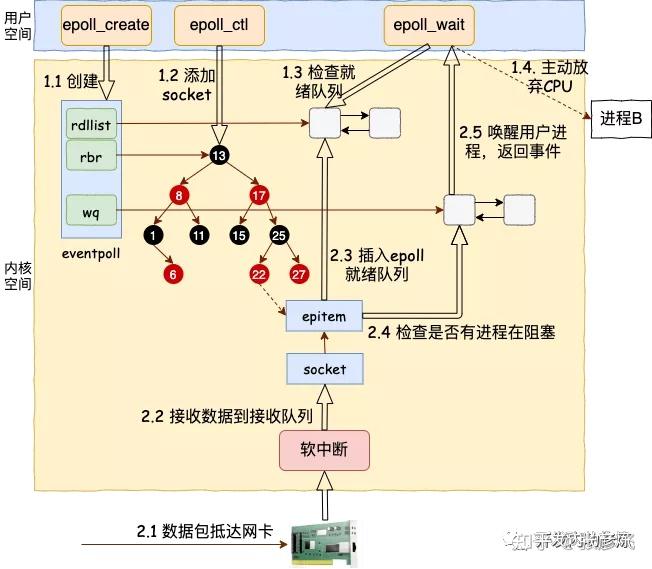

所以 epoll 作为多路复用技术中的代表,和传统的阻塞网络 IO 相比,最大的性能提升就是节约掉了大量的进程上下文切换。 epoll 内部又涉及出了一套复杂的数据结构,包括一棵红黑树和一个就绪链表(以及一个epollwait等待队列)。全部都工作在内核态。通过红黑树,高效地管理海量的连接。在数据到来的时候,不断地将数据 Ready 的socket 放到就绪链表中。

这样应用层和内核态协作的时候就非常的容易了,最少只需要一个进程就可以维护成千上万甚至是百万级别的连接。这个进程的简单地去就绪队列中查看有没有 Ready,需要被处理的 socket。有就拿走处理。只要活儿足够的多,epoll_wait 根本都不会让进程阻塞。用户进程会一直干活,一直干活,直到 epoll_wait 里实在没活儿可干的时候才主动让出 CPU。大量地减少了进程切换次数,这就是 epoll 高效的地方所在!

当然,上面我只是描述的简单的过程,epoll 的完整实现来看下面这篇文章吧。虽然源码很复杂,但是我在文章中都替你整理好了,看起来不会很费力。

图解 | 深入揭秘 epoll 是如何实现 IO 多路复用的!

这是 epoll 工作原理的一张汇总图,供你参考。

最后再说说 epoll 中的红黑树,有的人误以为 epoll 高效的全部因为这棵红黑树,这就有点夸大红黑树的作用了。其实红黑树的作用是仅仅是在管理大量连接的情况下,添加和删除 socket 非常的高效。如果 epoll 管理的 socket 固定的话,在数据收发的事件管理过程中其实红黑树是没有起作用的。内核在socket上收到数据包以后,可以直接找到 epitem(epoll item),并把它插入到就绪队列里,然后等用户进程把事件取走。这个过程中,红黑树的作用并不会得到体现。

关于网络实现,我还写了好多文章,都整理到我的Github上了。

https://github.com/yanfeizhang/coder-kung-fu

不要把 socket 想得太复杂,它其实和一般的文件读写没有太大区别。

只不过一个是用 fopen 打开,读写模式作为参数传进去;一个是用 socket 打开,服务器还是客户通过 connect / listen 设置。

一个是 fread/fwrite 读写,一个是 recv 和 send 读写(在 Linux 下你用 read 和 write 的话,文件和 socket 两者都能读写,只是无法直接设置一些特殊的 flag)。

一般的文件以及 socket 客户端读写的都是数据,而 socket 服务端 accept 读出来的是可以读写的客户端文件。

我觉得新手知道这些就可以大胆地去做 socket 编程了。

题主题目中提到的网络编程模型(socket建立套接字->bind绑定ip->listen监听->accept接受连接)是服务器端的编程模型。

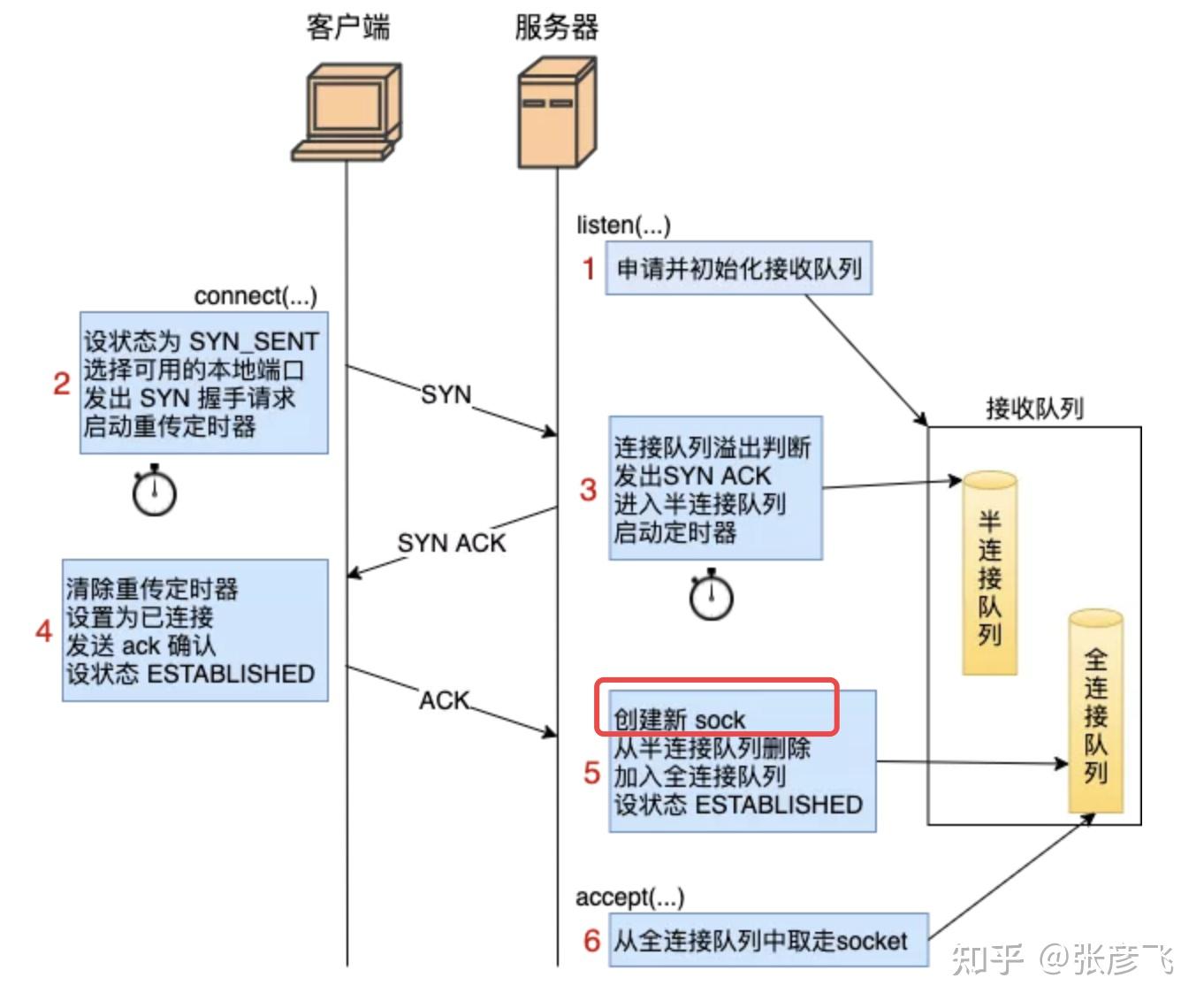

//服务端核心代码 int main(int argc, char const *argv[]) { int fd = socket(AF_INET, SOCK_STREAM, 0); bind(fd, ...); listen(fd, 128); accept(fd, ...); ... }每一个来自客户端的TCP请求在服务器端都会对应一个 socket。事实上,这个新 socket 的创建实机既不是在 listen 的时候,也不是在 accept 的时候,而是在三次握手成功之后创建的,然后放在对应的全连接队列中。

这个结论是我挖掘过 Linux 3.10 内核里三次握手的源码后的出来的结论。我把内核源码整个三次握手工作过程汇总整理成了一张图了。

从这张图中的右侧(服务器部分)来看,服务器在 listen 状态的时候可以接收来自客户端的握手请求。当客户端发出的第三次 ack 到达时,服务器创建了新的 sock 对象(socket 的核心),然后加入到了全连接队列中。然后accept的时候,仅仅只是从全连接队列里把 sock 取出来而已。

为了严谨起见,我还是给你简单展示一下 3.10 内核的源码。这些我处理过,放心很容易理解的。服务器响应第三次握手的 ack 时会进入到 tcp_v4_do_rcv。

//file: net/ipv4/tcp_ipv4.c int tcp_v4_do_rcv(struct sock *sk, struct sk_buff *skb) { ... if (sk->sk_state == TCP_LISTEN) { struct sock *nsk = tcp_v4_hnd_req(sk, skb); } ...... }在这里判断当前socket(正在 listen 的socket)的状态为监听,那么进入握手处理 tcp_v4_hnd_req。

//file:net/ipv4/tcp_ipv4.c static struct sock *tcp_v4_hnd_req(struct sock *sk, struct sk_buff *skb) { ... struct request_sock *req = inet_csk_search_req(sk, &prev, th->source, iph->saddr, iph->daddr); if (req) return tcp_check_req(sk, skb, req, prev, false); ... }在握手处理中,inet_csk_search_req 这一行是在查找半连接队列。如果查找到了,那就说明是第三次握手,返回一个半连接 request_sock 对象。

然后进入到 tcp_check_req 中。你所要问的问题的关键就是在 tcp_check_req 这里。

//file:net/ipv4/tcp_minisocks.c struct sock *tcp_check_req(struct sock *sk, struct sk_buff *skb, struct request_sock *req, struct request_sock prev, bool fastopen) { ... //创建子 socket child = inet_csk(sk)->icsk_af_ops->syn_recv_sock(sk, skb, req, NULL); ... //添加全连接队列 inet_csk_reqsk_queue_add(sk, req, child); return child; }在 inet_csk(sk)->icsk_af_ops->syn_recv_sock 这一行中就是题主问题的答案。 Socket 的核心部分就是在这里创建的。该函数又调用了 tcp_create_openreq_child => inet_csk_clone_lock => sk_clone_lock => sk_prot_alloc

static struct sock *sk_prot_alloc(struct proto *prot, gfp_t priority, int family) { struct sock *sk; struct kmem_cache *slab; slab = prot->slab; if (slab != NULL) { sk = kmem_cache_alloc(slab, priority & ~__GFP_ZERO); ... } else { sk = kmalloc(prot->obj_size, priority); } }在 sk_prot_alloc 这里给 socket 申请了内存。kmalloc 和 kmem_cache_alloc 和大家平时用的 malloc 类似,是用来分配内存的。

其中 slab 内存我在这篇讲过: 内核在内存上给自己开了个小灶

大部分的开发同学都和题主一样(包括我自己),虽然网络协议学了很多,网络编程也用不了少。但就是二者之间没有打通。比如题主的这个问题,究竟新 socket 是啥时候创建的,好像讲到的资料并不多。

我类似的困惑还有,服务器listen的时候到底干了啥,客户端connect时的端口号是如何确定的,全连接队列半连接队列到底长度多长。 对于这些我都深入挖掘内核源码后整理了出来,献给大家。

- 为什么服务端程序都需要先 listen 一下?

- TCP连接中客户端的端口号是如何确定的?

- 能将三次握手理解到这个深度,面试官拍案叫绝!

- 深入解析常见三次握手异常

- 如何正确查看线上半/全连接队列溢出情况?

类似的问题还有,比如同步阻塞到底是咋回事,epoll到底是怎么工作的。

- 图解 | 深入理解高性能网络开发路上的绊脚石 - 同步阻塞网络 IO

- 图解 | 深入揭秘 epoll 是如何实现 IO 多路复用的!

一个网络包是如何从网卡接收到进程里的,网络包的发送过程又是怎么样的。这些问题都困惑了我一段时间。不过后来我都把它们趟平了。

- 图解Linux网络包接收过程

- 25 张图,一万字,拆解 Linux 网络包发送过程

127.0.0.1 之本机网络通信过程知多少 ?!

最后分享下我整理出来的网络电子书,《理解了实现再谈网络性能》。

该书目前正在出版流程中。需要的该电子版的同学戳这里下载,传送门:

《理解了实现再谈网络性能》电子书发布啦!

最后祝大家都能打通理论与实践的任督二脉!

举个通俗易懂的例子吧

你去餐馆吃饭,你作为顾客相当于应用程序,餐馆厨房相当于系统内核,服务员相当于内核和应用层之间的接口。

你点好菜写下来,交给服务员,相当于调用内核接口,这时你就阻塞了,一直等待上菜。

服务员把你点的菜交给厨房,相当于给了内核一个请求,这个订单进入了内核的任务队列。服务员没有一直等待这个订单,他就去招待其他客人了。

如果有空闲的厨师,他就会接受一个订单开始做菜,相当于响应请求。

厨师做好了一个菜,就召唤服务员上菜,如果某个服务员有空就会去上菜,相当于请求完成通知。

顾客得到一个菜,一次系统调用完成。

你看,这个过程里,只有顾客是一只在等待的,服务员和厨师一直都在工作,没有死循环。当然聪明的顾客其实也没有死等,他会去刷手机,等服务员上菜,他才放下手机开始吃。

现实世界里都不会有真的死循环。

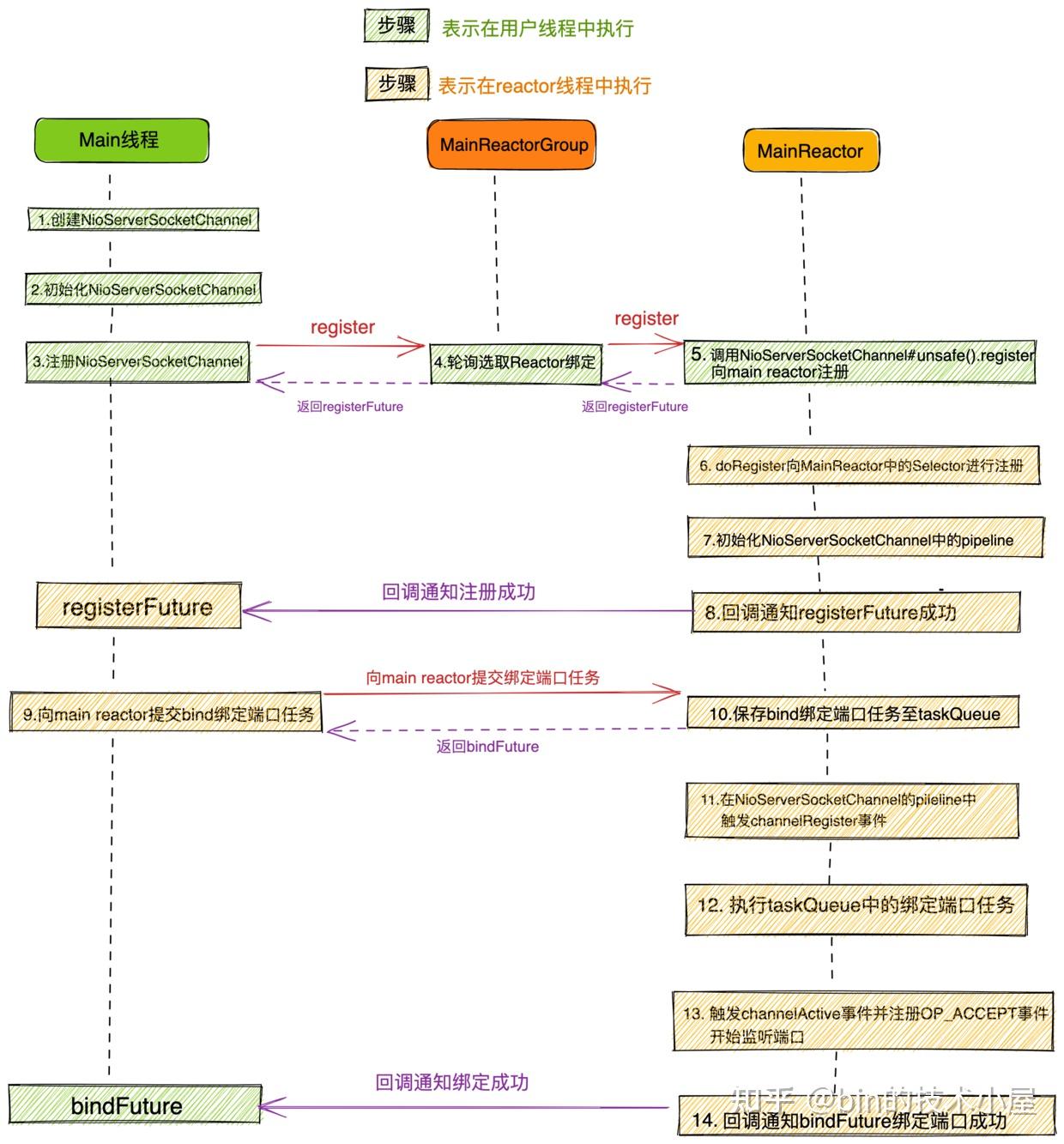

本系列Netty源码解析文章基于 4.1.56.Final版本

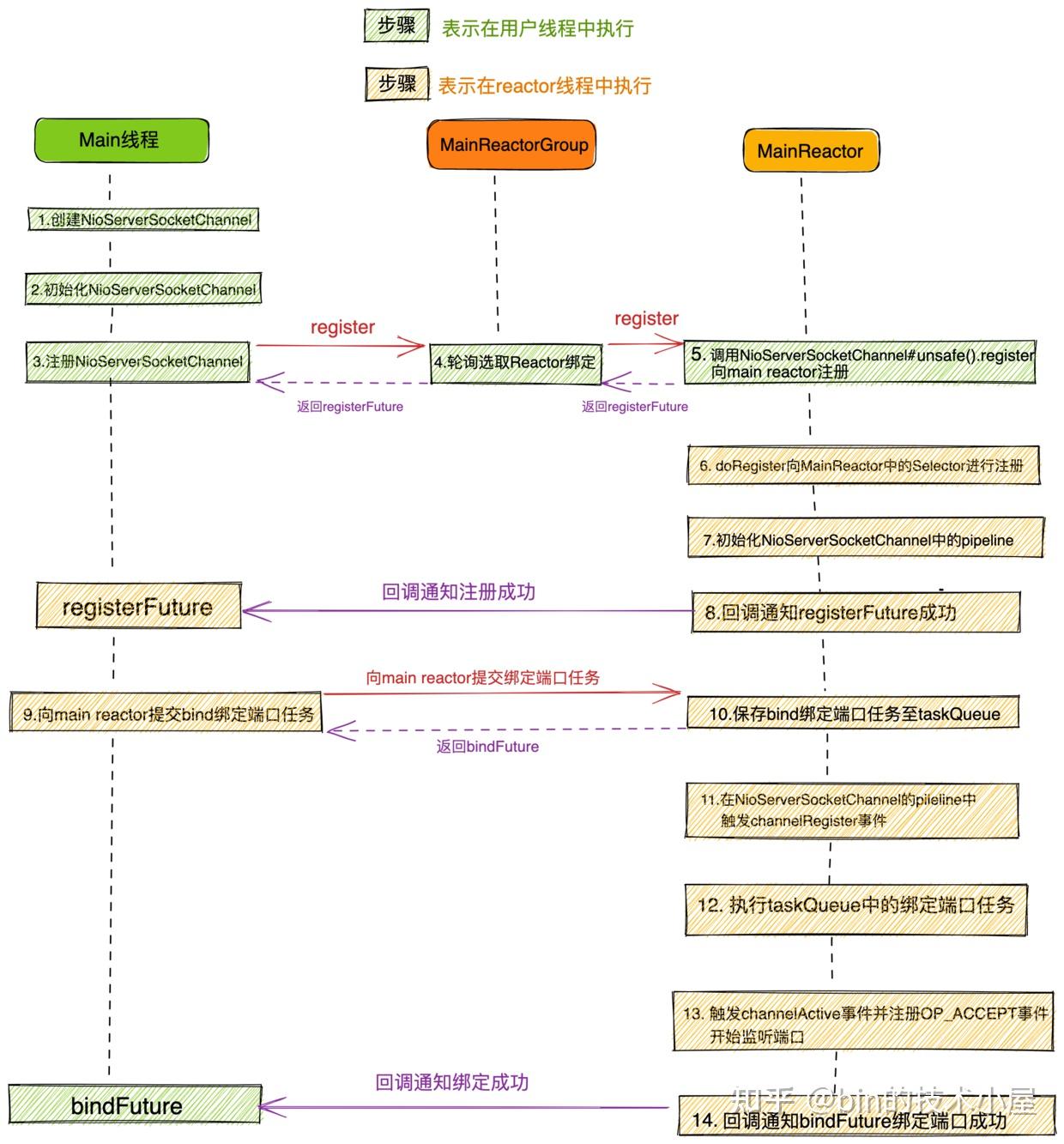

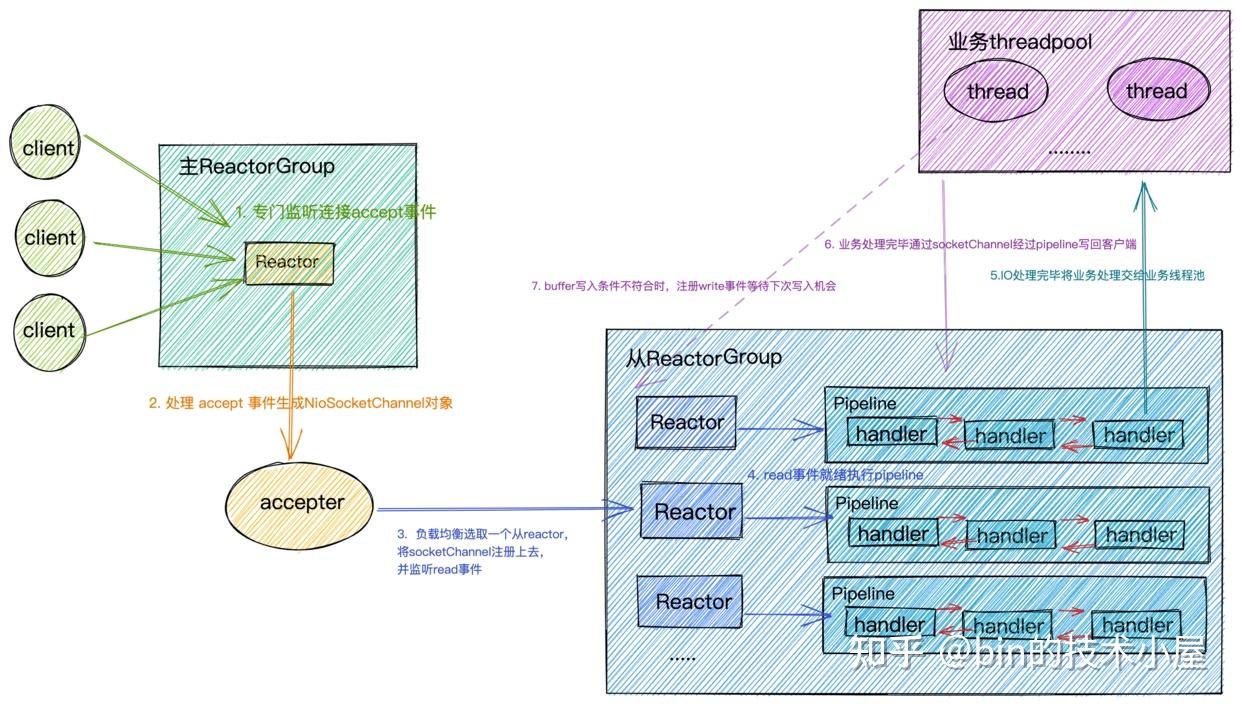

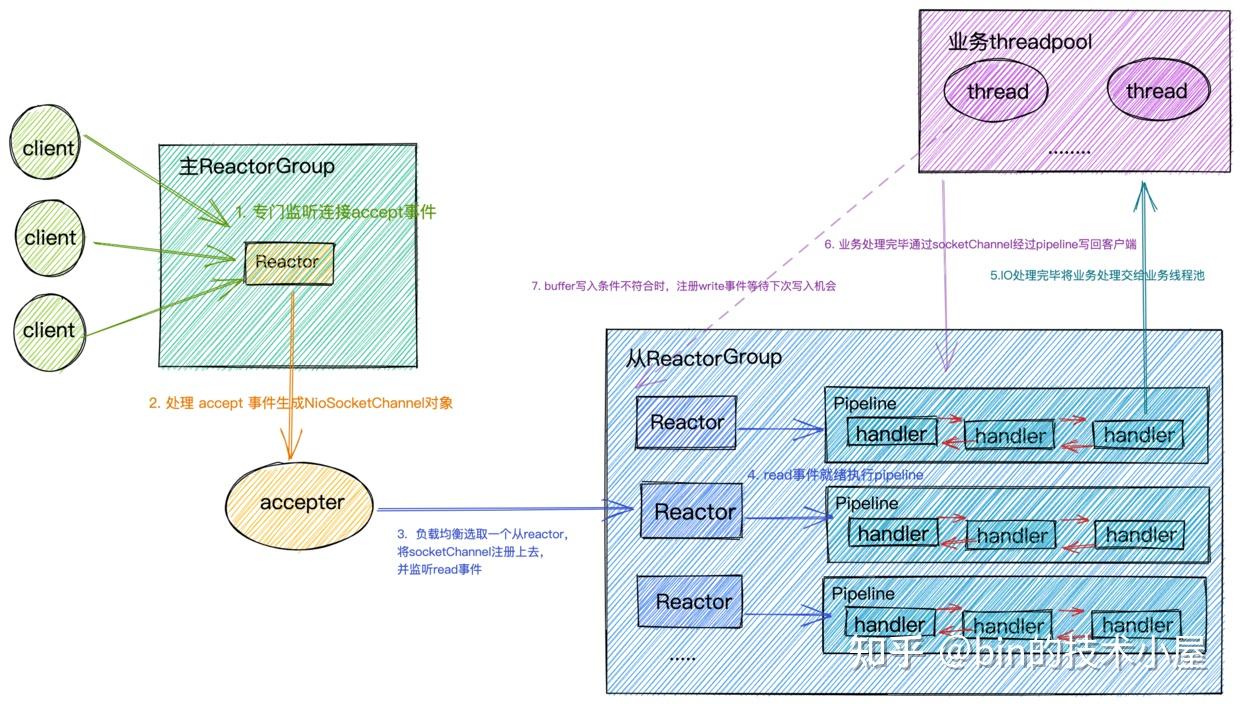

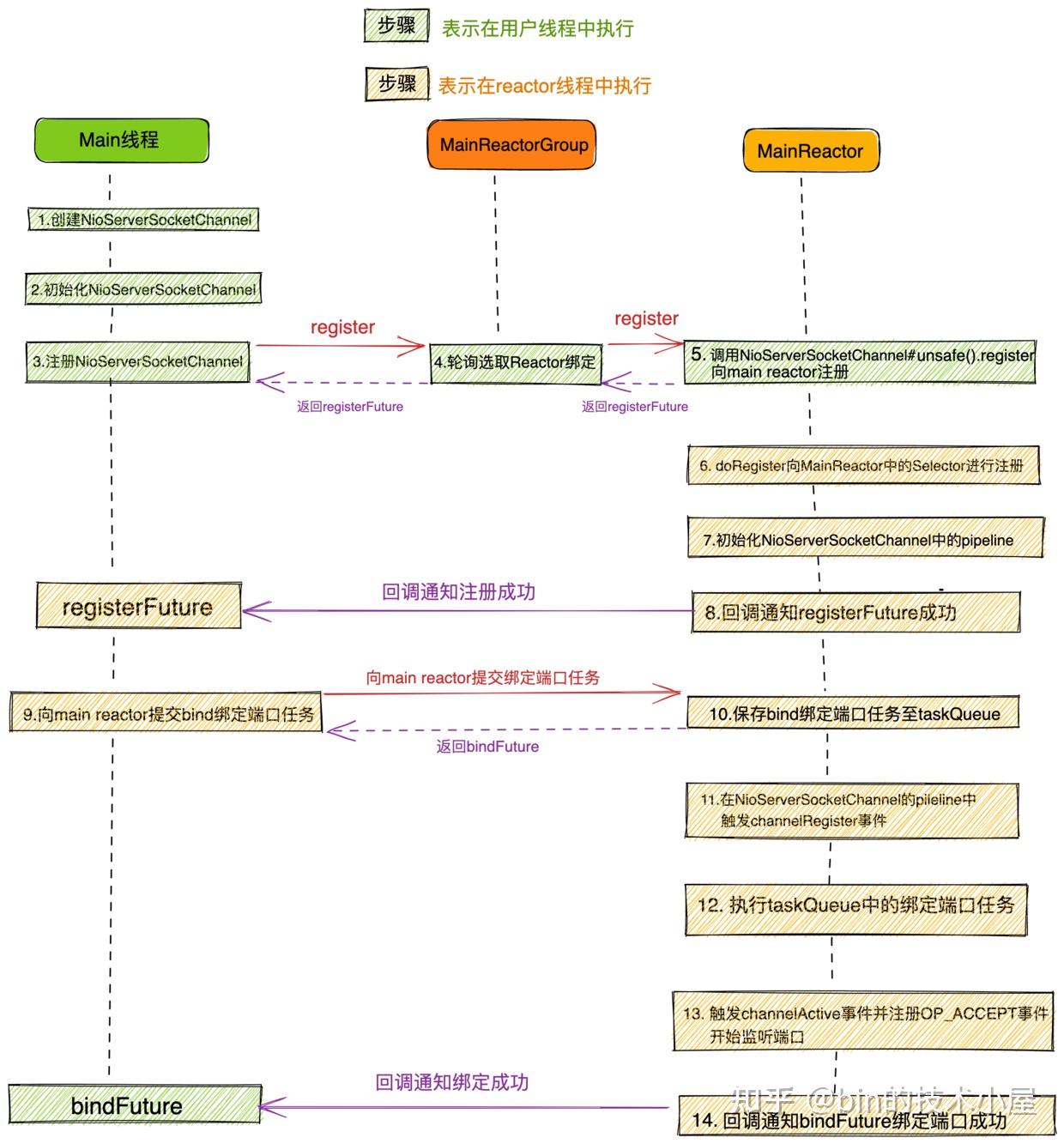

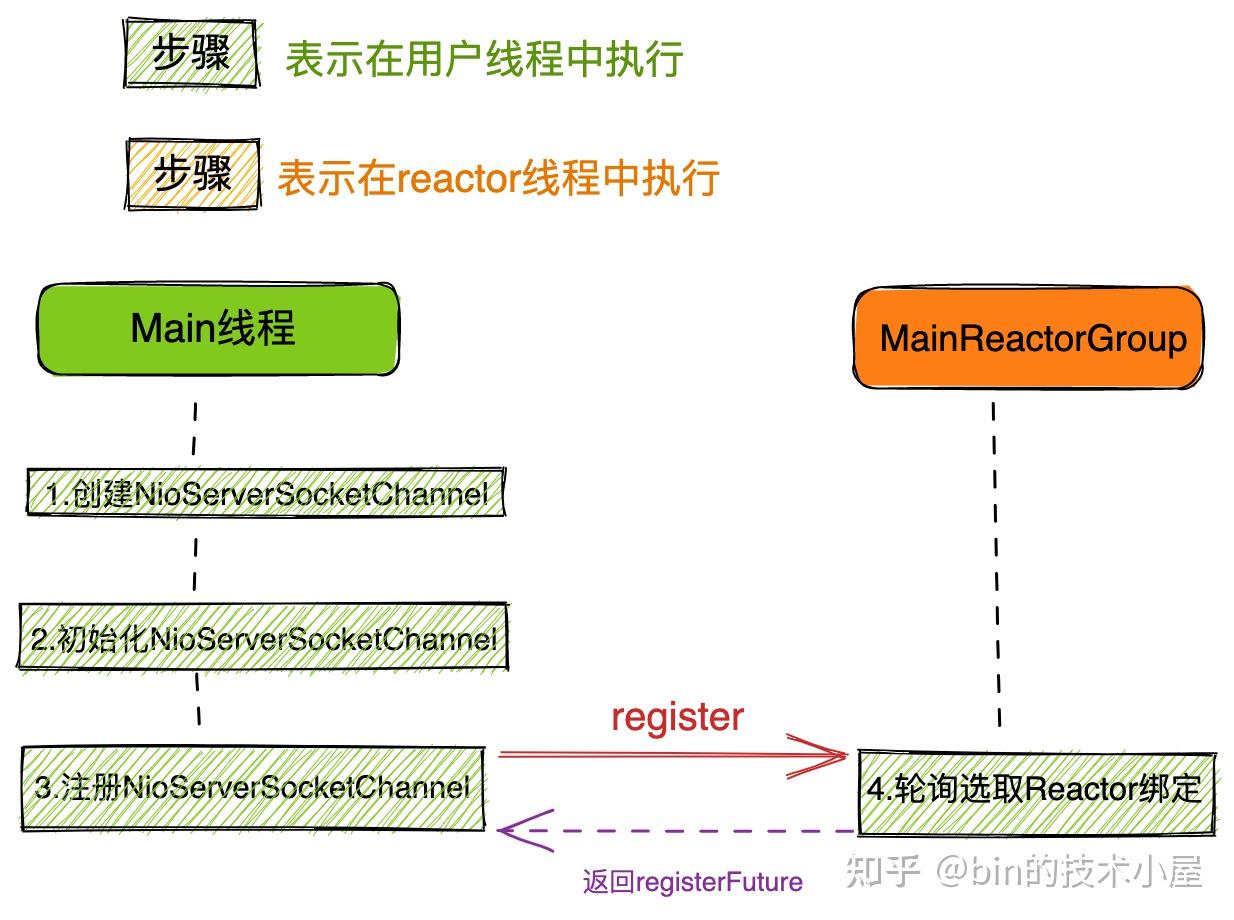

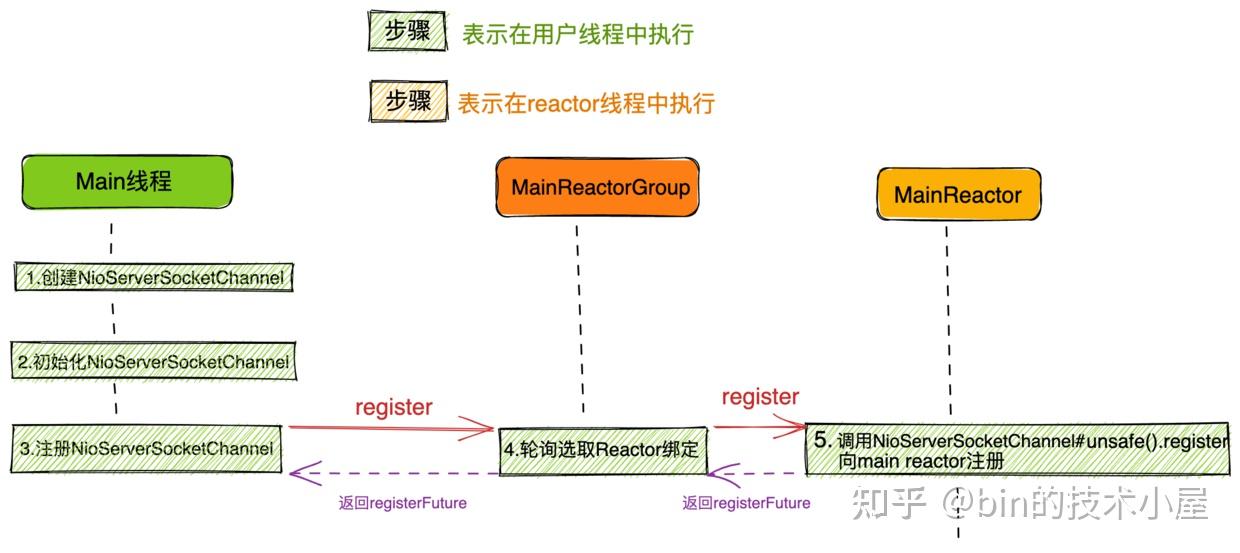

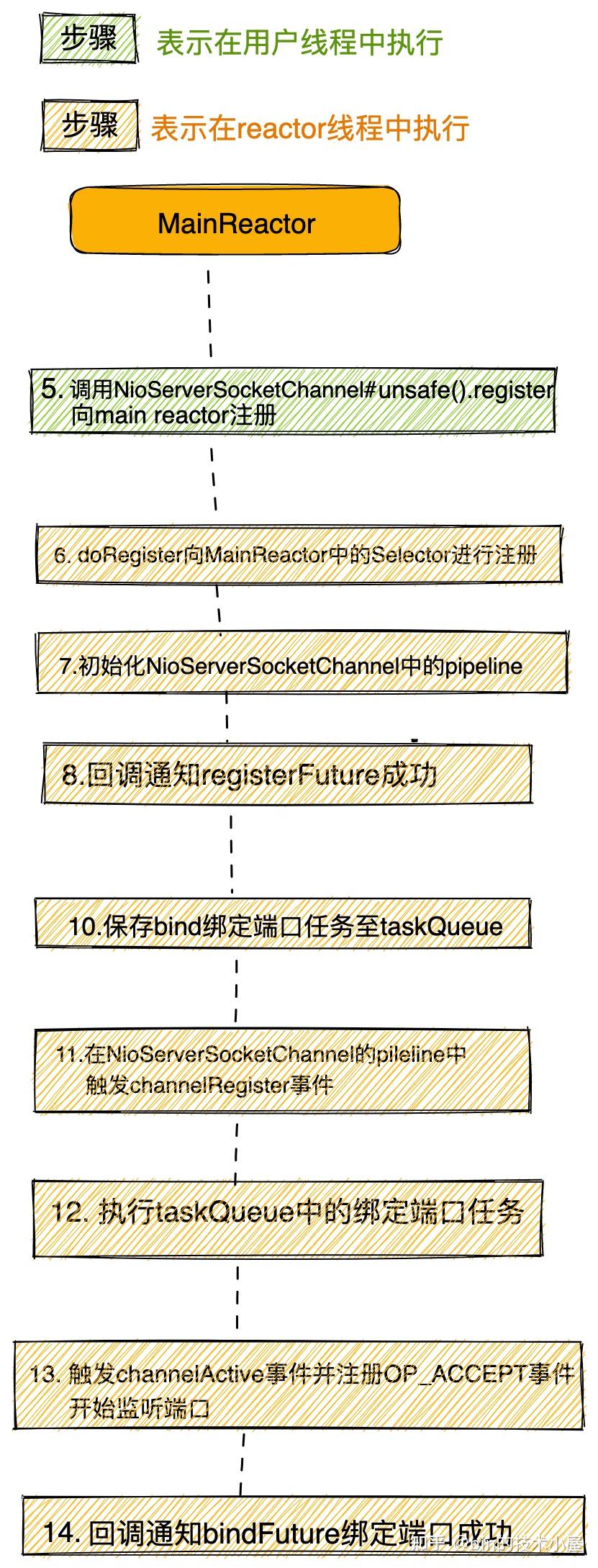

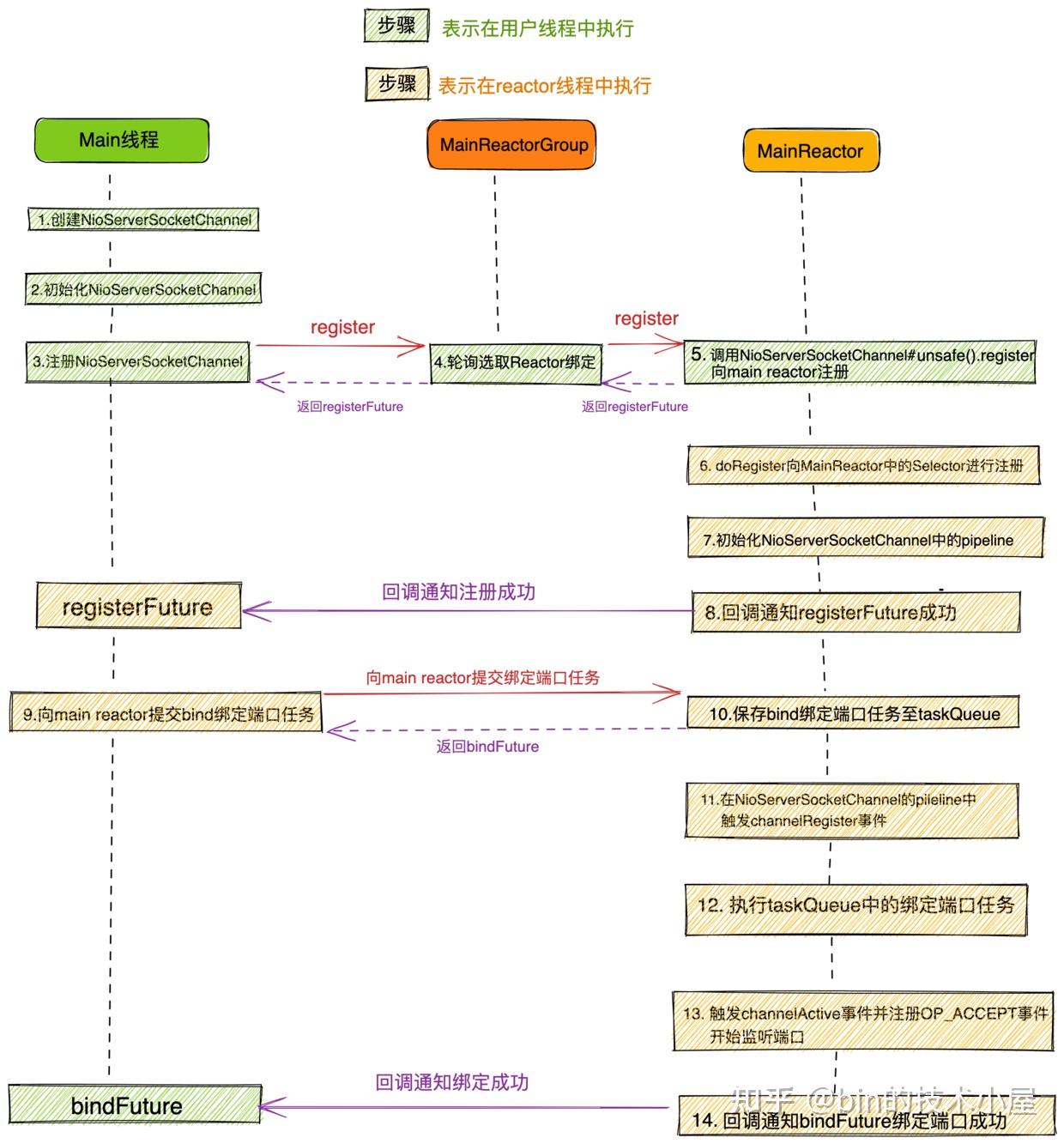

大家第一眼看到这幅流程图,是不是脑瓜子嗡嗡的呢?

大家先不要惊慌,问题不大,本文笔者的目的就是要让大家清晰的理解这幅流程图,从而深刻的理解Netty Reactor的启动全流程,包括其中涉及到的各种代码设计实现细节。

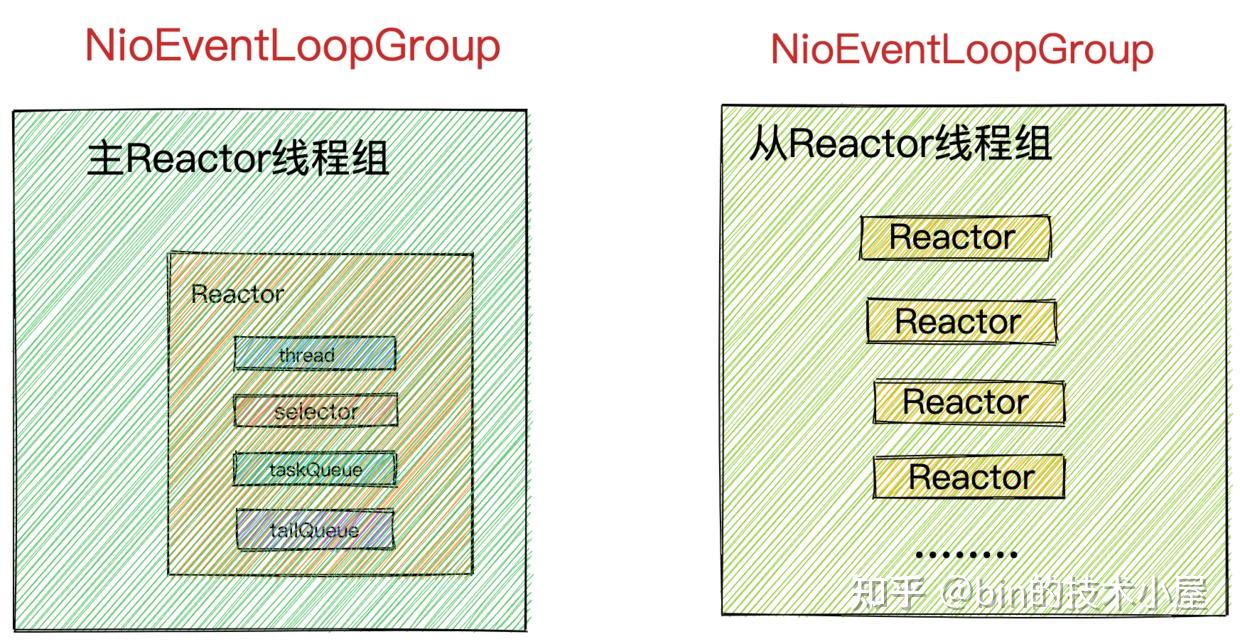

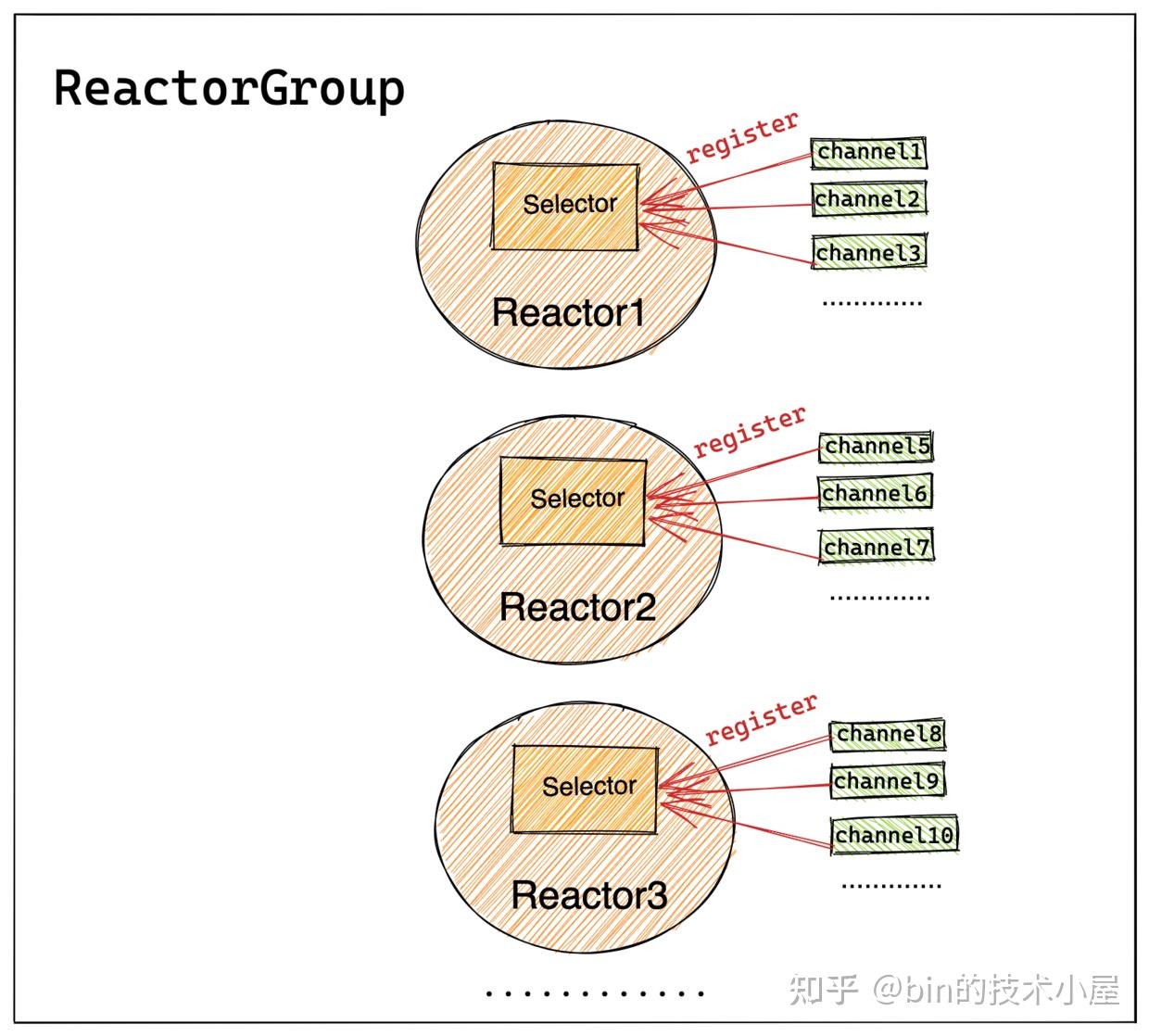

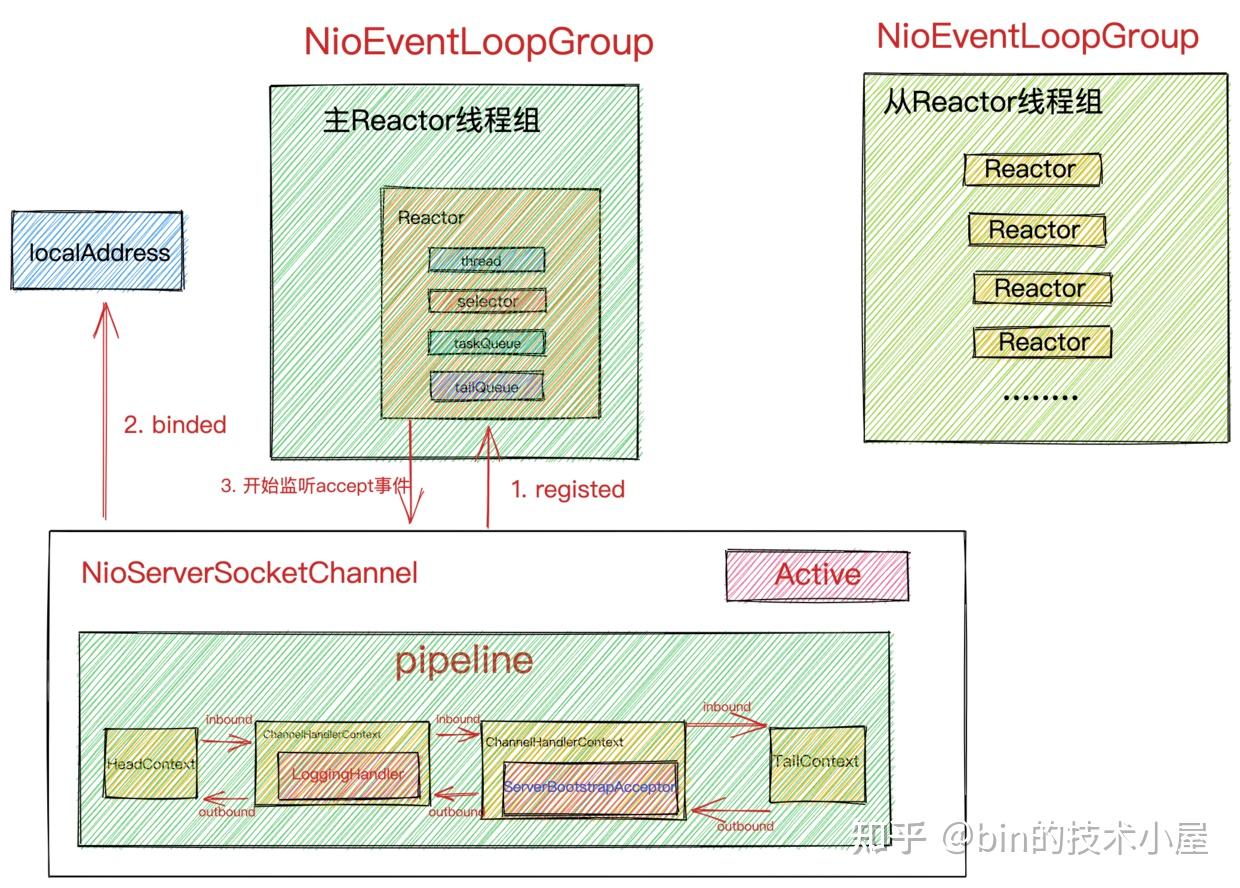

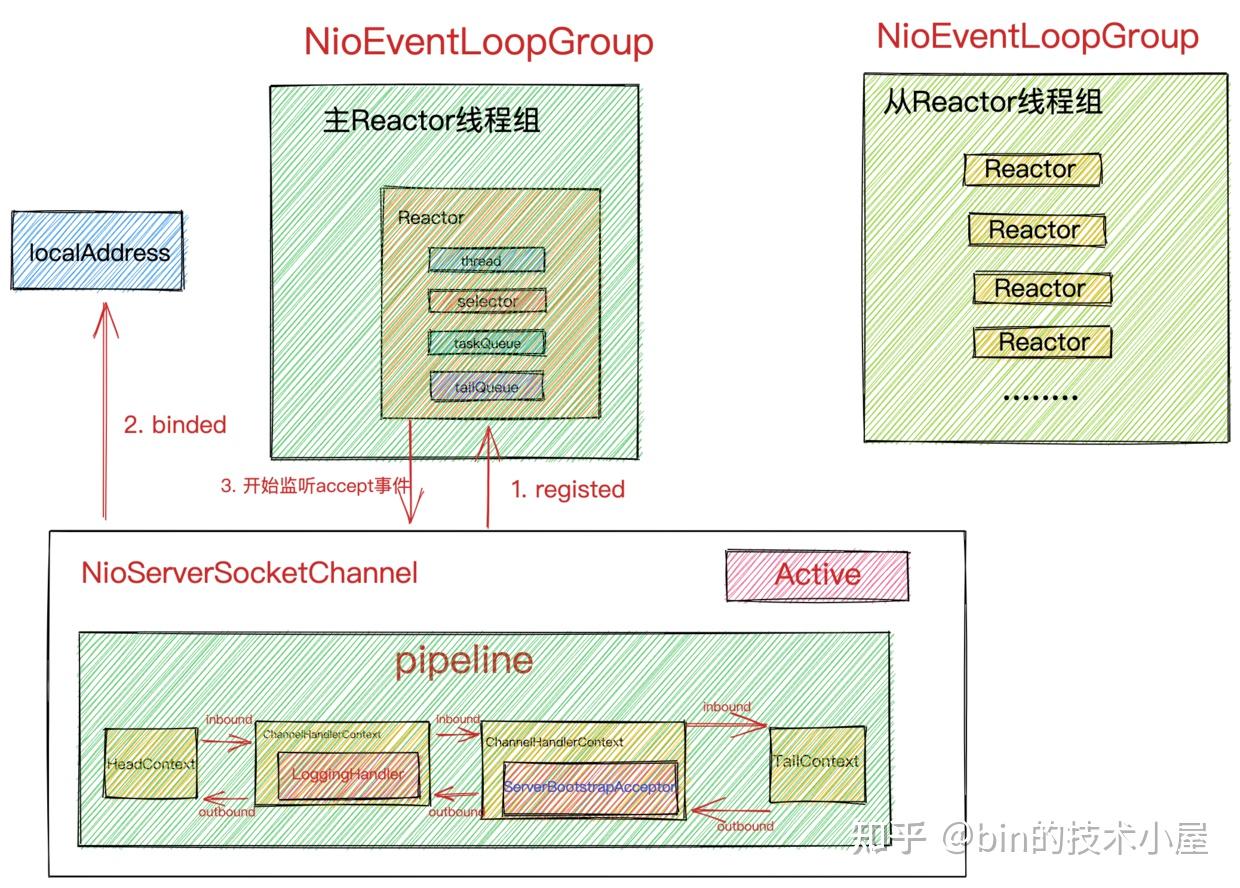

在上篇文章《聊聊Netty那些事儿之Reactor在Netty中的实现(创建篇)》中我们详细介绍了Netty服务端核心引擎组件主从Reactor组模型 NioEventLoopGroup以及Reactor模型 NioEventLoop的创建过程。最终我们得到了netty Reactor模型的运行骨架如下:

现在Netty服务端程序的骨架是搭建好了,本文我们就基于这个骨架来深入剖析下Netty服务端的启动过程。

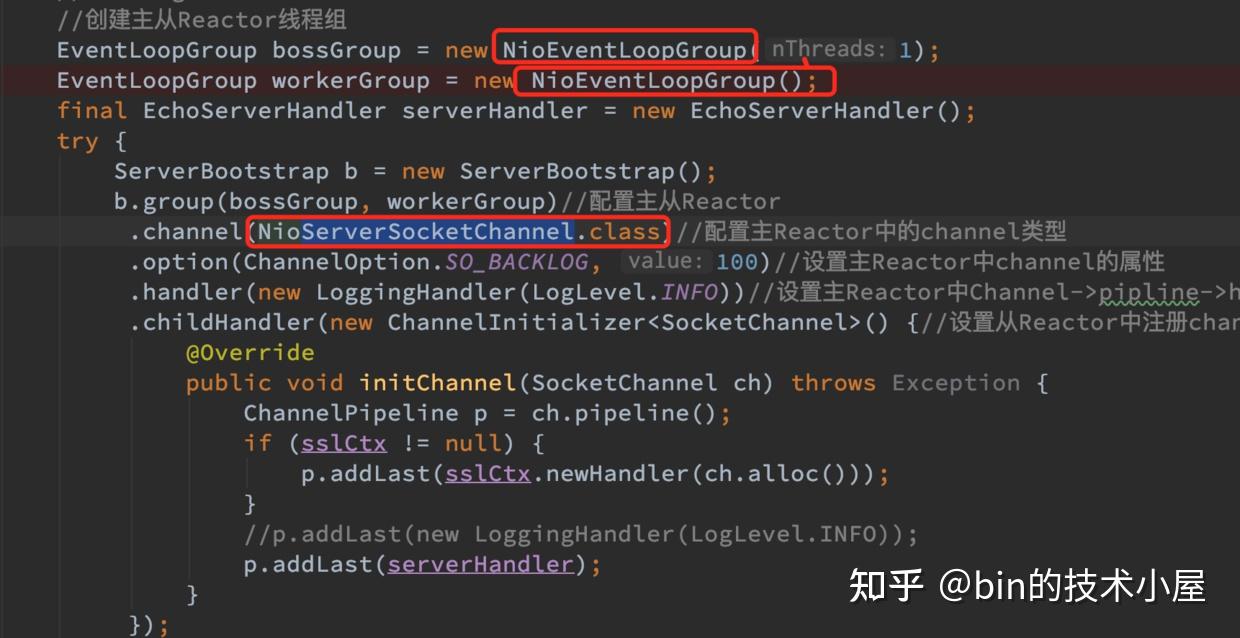

我们继续回到上篇文章提到的Netty服务端代码模板中,在创建完主从Reactor线程组:bossGroup,workerGroup后,接下来就开始配置Netty服务端的启动辅助类ServerBootstrap了。

public final class EchoServer { static final int PORT = Integer.parseInt(System.getProperty("port", "8007")); public static void main(String[] args) throws Exception { // Configure the server. //创建主从Reactor线程组 EventLoopGroup bossGroup = new NioEventLoopGroup(1); EventLoopGroup workerGroup = new NioEventLoopGroup(); final EchoServerHandler serverHandler = new EchoServerHandler(); try { ServerBootstrap b = new ServerBootstrap(); b.group(bossGroup, workerGroup)//配置主从Reactor .channel(NioServerSocketChannel.class)//配置主Reactor中的channel类型 .option(ChannelOption.SO_BACKLOG, 100)//设置主Reactor中channel的option选项 .handler(new LoggingHandler(LogLevel.INFO))//设置主Reactor中Channel->pipline->handler .childHandler(new ChannelInitializer<SocketChannel>() {//设置从Reactor中注册channel的pipeline @Override public void initChannel(SocketChannel ch) throws Exception { ChannelPipeline p = ch.pipeline(); //p.addLast(new LoggingHandler(LogLevel.INFO)); p.addLast(serverHandler); } }); // Start the server. 绑定端口启动服务,开始监听accept事件 ChannelFuture f = b.bind(PORT).sync(); // Wait until the server socket is closed. f.channel().closeFuture().sync(); } finally { // Shut down all event loops to terminate all threads. bossGroup.shutdownGracefully(); workerGroup.shutdownGracefully(); } } }在上篇文章中我们对代码模板中涉及到ServerBootstrap的一些配置方法做了简单的介绍,大家如果忘记的话,可以在返回去回顾一下。

ServerBootstrap类其实没有什么特别的逻辑,主要是对Netty启动过程中需要用到的一些核心信息进行配置管理,比如:

- Netty的核心引擎组件

主从Reactor线程组: bossGroup,workerGroup。通过ServerBootstrap#group方法配置。

- Netty服务端使用到的Channel类型:

NioServerSocketChannel,通过ServerBootstrap#channel方法配置。 以及配置NioServerSocketChannel时用到的SocketOption。SocketOption用于设置底层JDK NIO Socket的一些选项。通过ServerBootstrap#option方法进行配置。

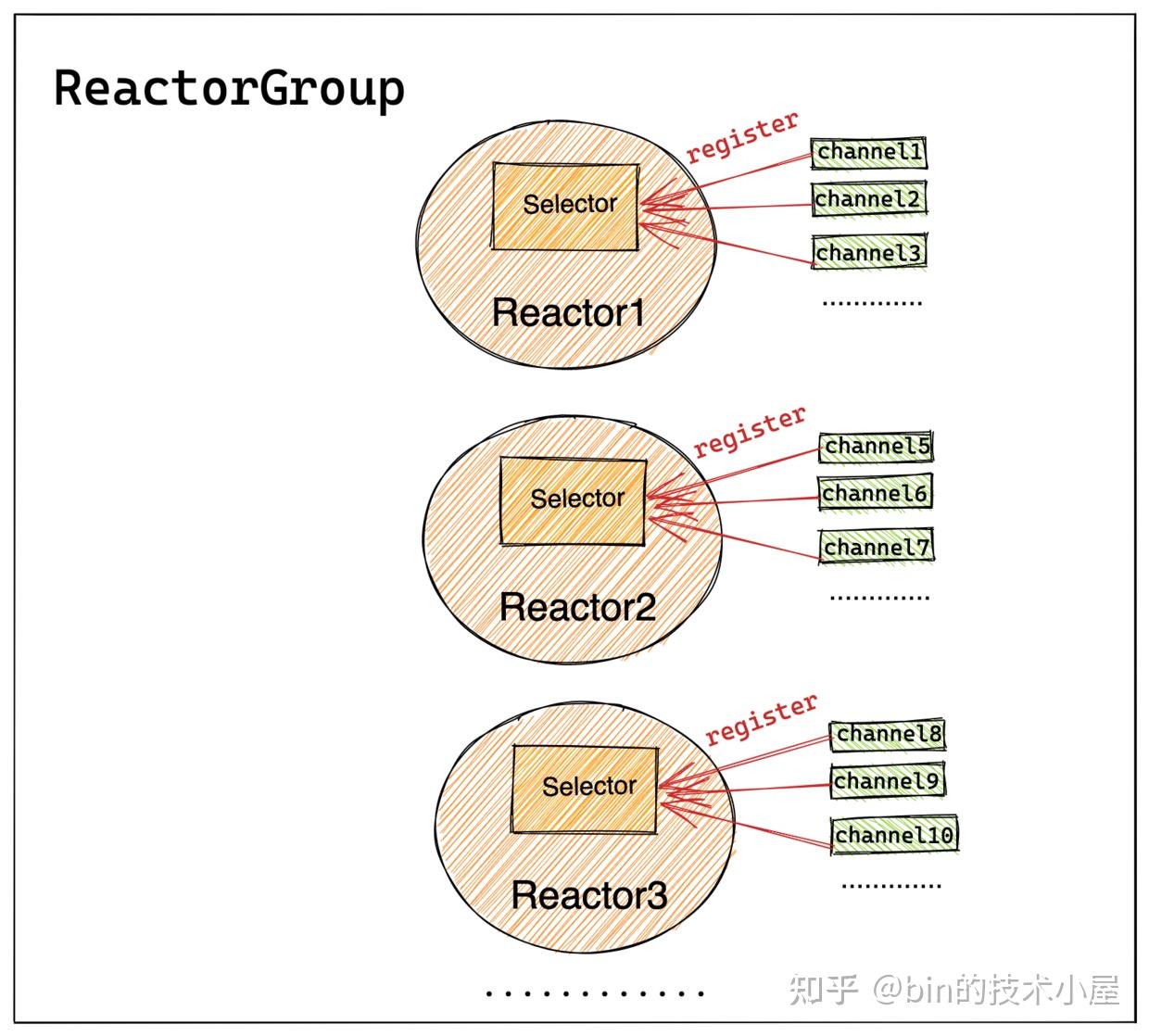

主ReactorGroup中的MainReactor管理的Channel类型为NioServerSocketChannel,如图所示主要用来监听端口,接收客户端连接,为客户端创建初始化NioSocketChannel,然后采用round-robin轮询的方式从图中从ReactorGroup中选择一个SubReactor与该客户端NioSocketChannel进行绑定。

从ReactorGroup中的SubReactor管理的Channel类型为NioSocketChannel,它是netty中定义客户端连接的一个模型,每个连接对应一个。如图所示SubReactor负责监听处理绑定在其上的所有NioSocketChannel上的IO事件。

- 保存服务端

NioServerSocketChannel和客户端NioSocketChannel对应pipeline中指定的ChannelHandler。用于后续Channel向Reactor注册成功之后,初始化Channel里的pipeline。

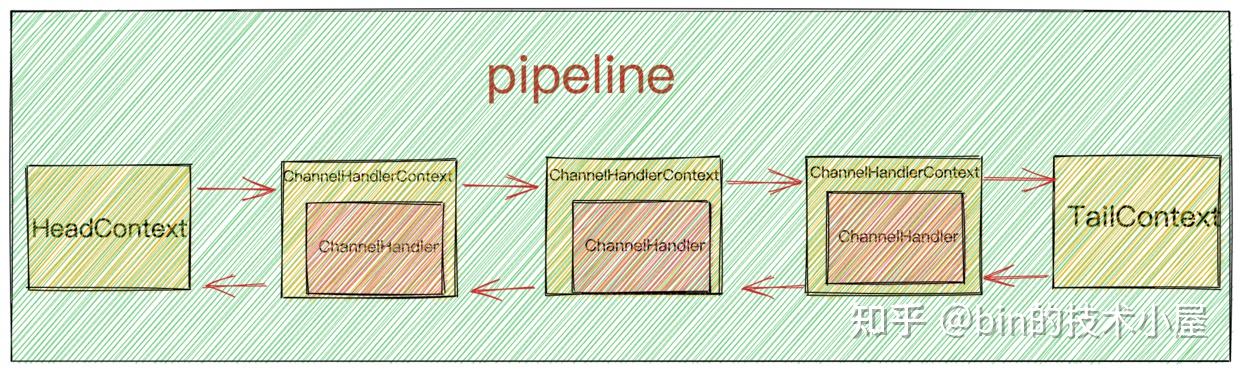

不管是服务端用到的NioServerSocketChannel还是客户端用到的NioSocketChannel,每个Channel实例都会有一个Pipeline,Pipeline中有多个ChannelHandler用于编排处理对应Channel上感兴趣的IO事件。

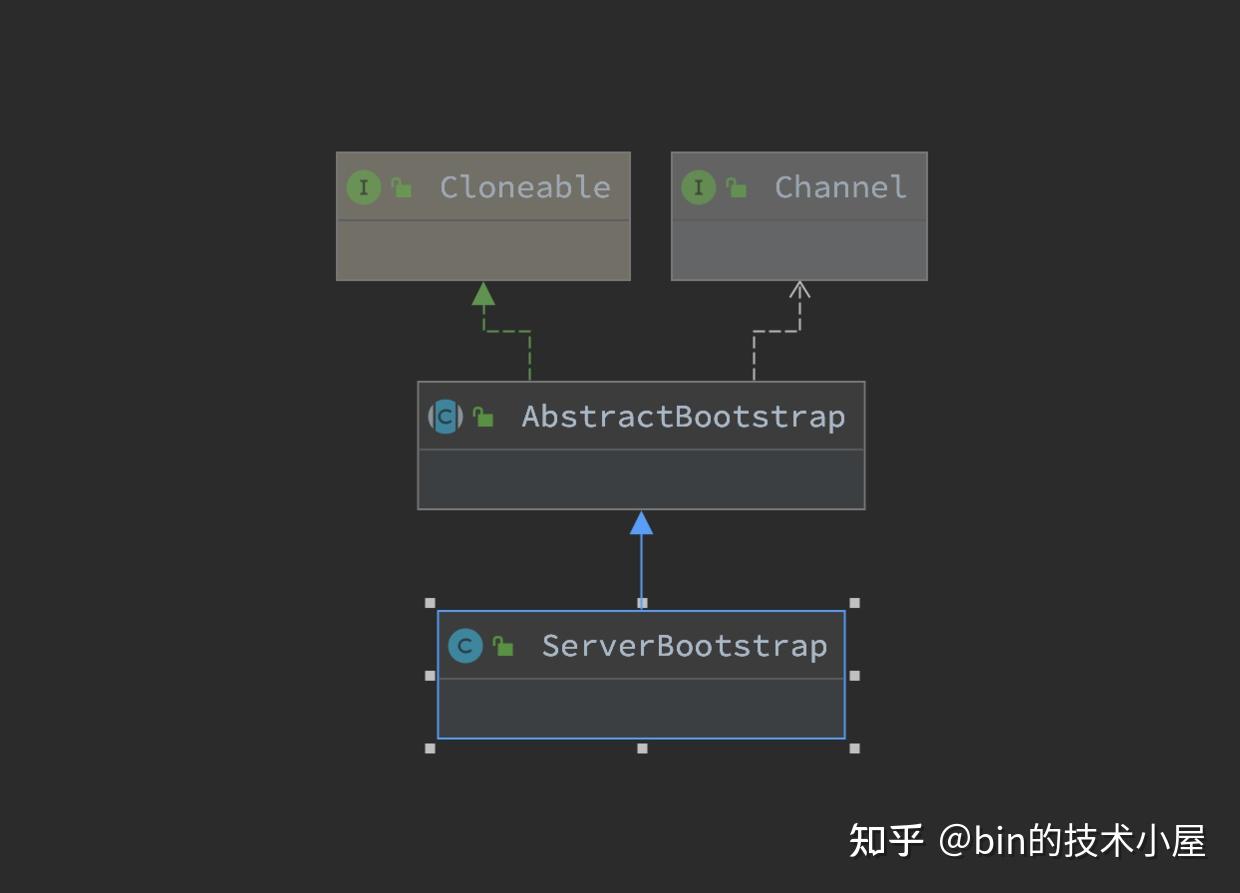

ServerBootstrap结构中包含了netty服务端程序启动的所有配置信息,在我们介绍启动流程之前,先来看下ServerBootstrap的源码结构:

ServerBootstrap的继承结构比较简单,继承层次的职责分工也比较明确。

ServerBootstrap主要负责对主从Reactor线程组相关的配置进行管理,其中带child前缀的配置方法是对从Reactor线程组的相关配置管理。从Reactor线程组中的Sub Reactor负责管理的客户端NioSocketChannel相关配置存储在ServerBootstrap结构中。

父类AbstractBootstrap则是主要负责对主Reactor线程组相关的配置进行管理,以及主Reactor线程组中的Main Reactor负责处理的服务端ServerSocketChannel相关的配置管理。

ServerBootstrap b = new ServerBootstrap(); b.group(bossGroup, workerGroup)//配置主从Reactor public class ServerBootstrap extends AbstractBootstrap<ServerBootstrap, ServerChannel> { //Main Reactor线程组 volatile EventLoopGroup group; //Sub Reactor线程组 private volatile EventLoopGroup childGroup; public ServerBootstrap group(EventLoopGroup parentGroup, EventLoopGroup childGroup) { //父类管理主Reactor线程组 super.group(parentGroup); if (this.childGroup != null) { throw new IllegalStateException("childGroup set already"); } this.childGroup = ObjectUtil.checkNotNull(childGroup, "childGroup"); return this; } }ServerBootstrap b = new ServerBootstrap(); b.channel(NioServerSocketChannel.class); public class ServerBootstrap extends AbstractBootstrap<ServerBootstrap, ServerChannel> { //用于创建ServerSocketChannel ReflectiveChannelFactory private volatile ChannelFactory<? extends C> channelFactory; public B channel(Class<? extends C> channelClass) { return channelFactory(new ReflectiveChannelFactory<C>( ObjectUtil.checkNotNull(channelClass, "channelClass") )); } @Deprecated public B channelFactory(ChannelFactory<? extends C> channelFactory) { ObjectUtil.checkNotNull(channelFactory, "channelFactory"); if (this.channelFactory != null) { throw new IllegalStateException("channelFactory set already"); } this.channelFactory = channelFactory; return self(); } }在向ServerBootstrap配置服务端ServerSocketChannel的channel方法中,其实是创建了一个ChannelFactory工厂实例ReflectiveChannelFactory,在Netty服务端启动的过程中,会通过这个ChannelFactory去创建相应的Channel实例。

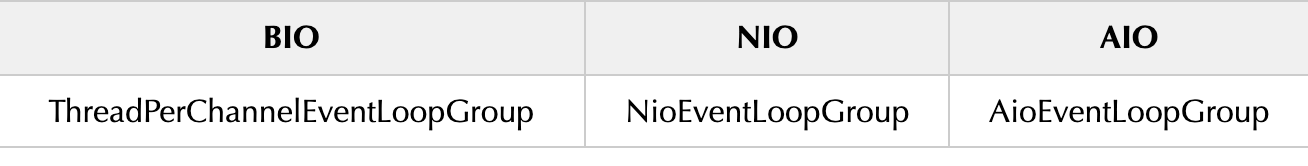

我们可以通过这个方法来配置netty的IO模型,下面为ServerSocketChannel在不同IO模型下的实现:

EventLoopGroupReactor线程组在不同IO模型下的实现:

我们只需要将IO模型的这些核心接口对应的实现类前缀改为对应IO模型的前缀,就可以轻松在Netty中完成对IO模型的切换。

public class ReflectiveChannelFactory<T extends Channel> implements ChannelFactory<T> { //NioServerSocketChannelde 构造器 private final Constructor<? extends T> constructor; public ReflectiveChannelFactory(Class<? extends T> clazz) { ObjectUtil.checkNotNull(clazz, "clazz"); try { //反射获取NioServerSocketChannel的构造器 this.constructor = clazz.getConstructor(); } catch (NoSuchMethodException e) { throw new IllegalArgumentException("Class " + StringUtil.simpleClassName(clazz) + " does not have a public non-arg constructor", e); } } @Override public T newChannel() { try { //创建NioServerSocketChannel实例 return constructor.newInstance(); } catch (Throwable t) { throw new ChannelException("Unable to create Channel from class " + constructor.getDeclaringClass(), t); } } }从类的签名我们可以看出,这个工厂类是通过泛型加反射的方式来创建对应的Channel实例。

- 泛型参数

T extends Channel表示的是要通过工厂类创建的Channel类型,这里我们初始化的是NioServerSocketChannel。 - 在

ReflectiveChannelFactory的构造器中通过反射的方式获取NioServerSocketChannel的构造器。 - 在

newChannel方法中通过构造器反射创建NioServerSocketChannel实例。

注意这时只是配置阶段,NioServerSocketChannel此时并未被创建。它是在启动的时候才会被创建出来。

ServerBootstrap b = new ServerBootstrap(); //设置被MainReactor管理的NioServerSocketChannel的Socket选项 b.option(ChannelOption.SO_BACKLOG, 100) public abstract class AbstractBootstrap<B extends AbstractBootstrap<B, C>, C extends Channel> implements Cloneable { //serverSocketChannel中的ChannelOption配置 private final Map<ChannelOption<?>, Object> options = new LinkedHashMap<ChannelOption<?>, Object>(); public <T> B option(ChannelOption<T> option, T value) { ObjectUtil.checkNotNull(option, "option"); synchronized (options) { if (value == null) { options.remove(option); } else { options.put(option, value); } } return self(); } }无论是服务端的NioServerSocketChannel还是客户端的NioSocketChannel它们的相关底层Socket选项ChannelOption配置全部存放于一个Map类型的数据结构中。

由于客户端NioSocketChannel是由从Reactor线程组中的Sub Reactor来负责处理,所以涉及到客户端NioSocketChannel所有的方法和配置全部是以child前缀开头。

ServerBootstrap b = new ServerBootstrap(); .childOption(ChannelOption.TCP_NODELAY, Boolean.TRUE) public class ServerBootstrap extends AbstractBootstrap<ServerBootstrap, ServerChannel> { //客户端SocketChannel对应的ChannelOption配置 private final Map<ChannelOption<?>, Object> childOptions = new LinkedHashMap<ChannelOption<?>, Object>(); public <T> ServerBootstrap childOption(ChannelOption<T> childOption, T value) { ObjectUtil.checkNotNull(childOption, "childOption"); synchronized (childOptions) { if (value == null) { childOptions.remove(childOption); } else { childOptions.put(childOption, value); } } return this; } }相关的底层Socket选项,netty全部枚举在ChannelOption类中,笔者这里就不一一列举了,在本系列后续相关的文章中,笔者还会为大家详细的介绍这些参数的作用。

public class ChannelOption<T> extends AbstractConstant<ChannelOption<T>> { ..................省略.............. public static final ChannelOption<Boolean> SO_BROADCAST = valueOf("SO_BROADCAST"); public static final ChannelOption<Boolean> SO_KEEPALIVE = valueOf("SO_KEEPALIVE"); public static final ChannelOption<Integer> SO_SNDBUF = valueOf("SO_SNDBUF"); public static final ChannelOption<Integer> SO_RCVBUF = valueOf("SO_RCVBUF"); public static final ChannelOption<Boolean> SO_REUSEADDR = valueOf("SO_REUSEADDR"); public static final ChannelOption<Integer> SO_LINGER = valueOf("SO_LINGER"); public static final ChannelOption<Integer> SO_BACKLOG = valueOf("SO_BACKLOG"); public static final ChannelOption<Integer> SO_TIMEOUT = valueOf("SO_TIMEOUT"); ..................省略.............. }//serverSocketChannel中pipeline里的handler(主要是acceptor) private volatile ChannelHandler handler; public B handler(ChannelHandler handler) { this.handler = ObjectUtil.checkNotNull(handler, "handler"); return self(); }向NioServerSocketChannel中的Pipeline添加ChannelHandler分为两种方式:

显式添加:显式添加的方式是由用户在main线程中通过ServerBootstrap#handler的方式添加。如果需要添加多个ChannelHandler,则可以通过ChannelInitializer向pipeline中进行添加。

关于ChannelInitializer后面笔者会有详细介绍,这里大家只需要知道ChannelInitializer是一种特殊的ChannelHandler,用于初始化pipeline。适用于向pipeline中添加多个ChannelHandler的场景。

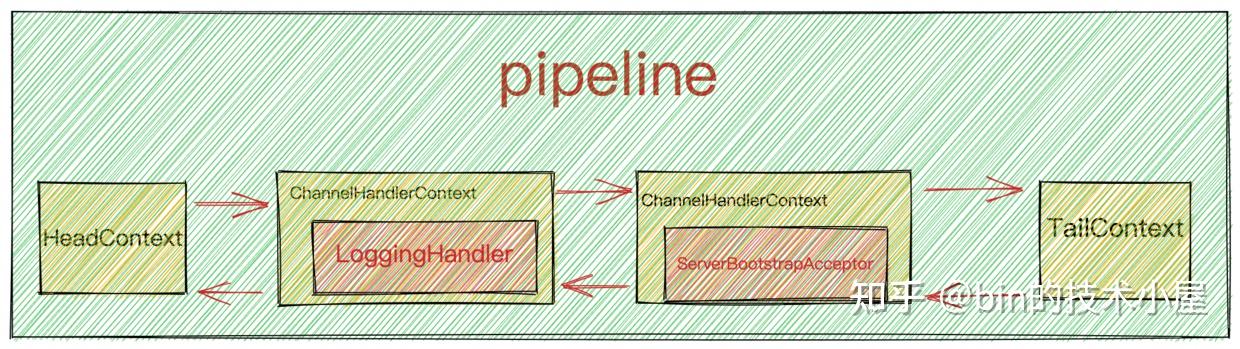

ServerBootstrap b = new ServerBootstrap(); b.group(bossGroup, workerGroup)//配置主从Reactor .channel(NioServerSocketChannel.class)//配置主Reactor中的channel类型 .handler(new ChannelInitializer<NioServerSocketChannel>() { @Override protected void initChannel(NioServerSocketChannel ch) throws Exception { ChannelPipeline p = ch.pipeline(); p.addLast(channelhandler1) .addLast(channelHandler2) ...... .addLast(channelHandler3); } })隐式添加:隐式添加主要添加的就是主ReactorGroup的核心组件也就是下图中的acceptor,Netty中的实现为ServerBootstrapAcceptor,本质上也是一种ChannelHandler,主要负责在客户端连接建立好后,初始化客户端NioSocketChannel,在从Reactor线程组中选取一个Sub Reactor,将客户端NioSocketChannel注册到Sub Reactor中的selector上。

隐式添加ServerBootstrapAcceptor是由Netty框架在启动的时候负责添加,用户无需关心。

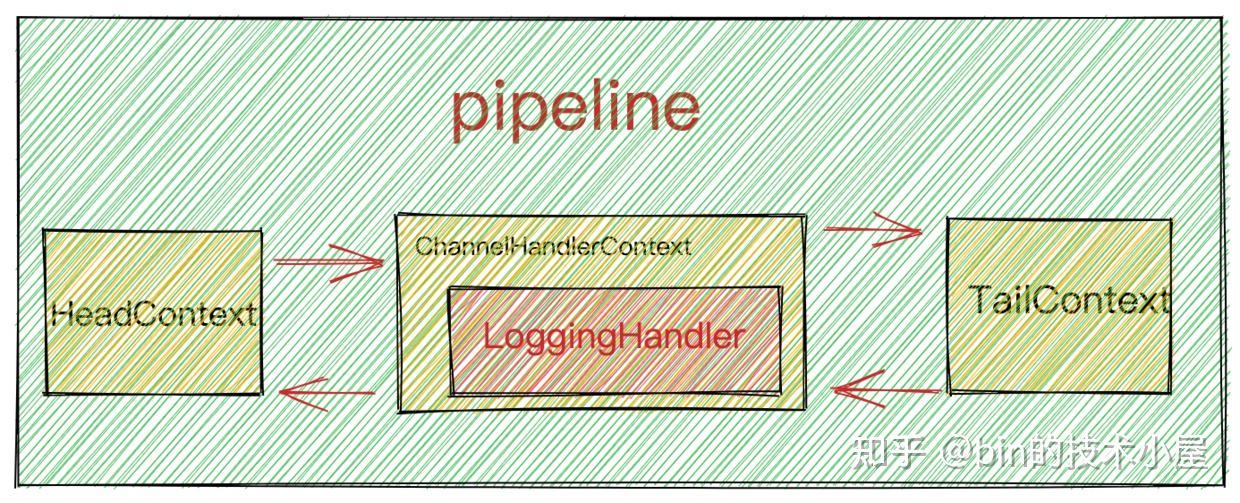

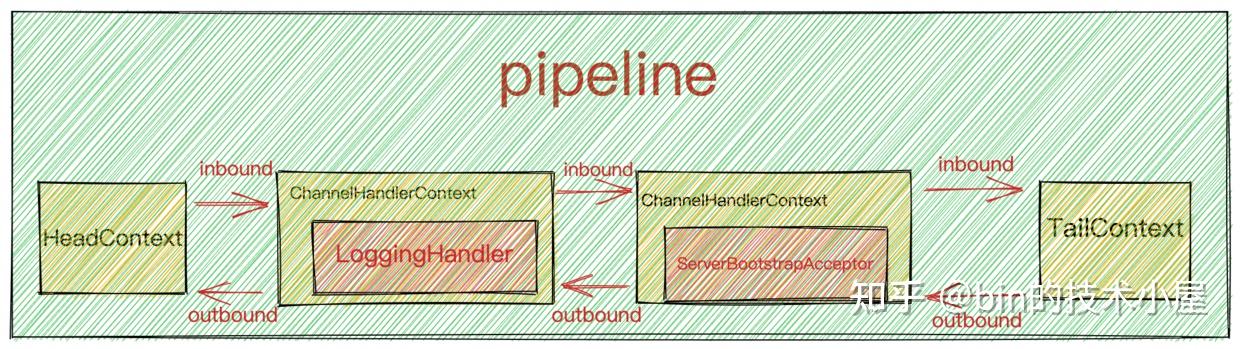

在本例中,NioServerSocketChannel的PipeLine中只有两个ChannelHandler,一个由用户在外部显式添加的LoggingHandler,另一个是由Netty框架隐式添加的ServerBootstrapAcceptor。

其实我们在实际项目使用的过程中,不会向netty服务端NioServerSocketChannel添加额外的ChannelHandler,NioServerSocketChannel只需要专心做好自己最重要的本职工作接收客户端连接就好了。这里额外添加一个LoggingHandler只是为了向大家展示ServerBootstrap的配置方法。

final EchoServerHandler serverHandler = new EchoServerHandler(); serverBootstrap.childHandler(new ChannelInitializer<SocketChannel>() {//设置从Reactor中注册channel的pipeline @Override public void initChannel(SocketChannel ch) throws Exception { ChannelPipeline p = ch.pipeline(); p.addLast(new LoggingHandler(LogLevel.INFO)); p.addLast(serverHandler); } }); //socketChannel中pipeline中的处理handler private volatile ChannelHandler childHandler; public ServerBootstrap childHandler(ChannelHandler childHandler) { this.childHandler = ObjectUtil.checkNotNull(childHandler, "childHandler"); return this; }向客户端NioSocketChannel中的Pipeline里添加ChannelHandler完全是由用户自己控制显式添加,添加的数量不受限制。

由于在Netty的IO线程模型中,是由单个Sub Reactor线程负责执行客户端NioSocketChannel中的Pipeline,一个Sub Reactor线程负责处理多个NioSocketChannel上的IO事件,如果Pipeline中的ChannelHandler添加的太多,就会影响Sub Reactor线程执行其他NioSocketChannel上的Pipeline,从而降低IO处理效率,降低吞吐量。

所以Pipeline中的ChannelHandler不易添加过多,并且不能再ChannelHandler中执行耗时的业务处理任务。

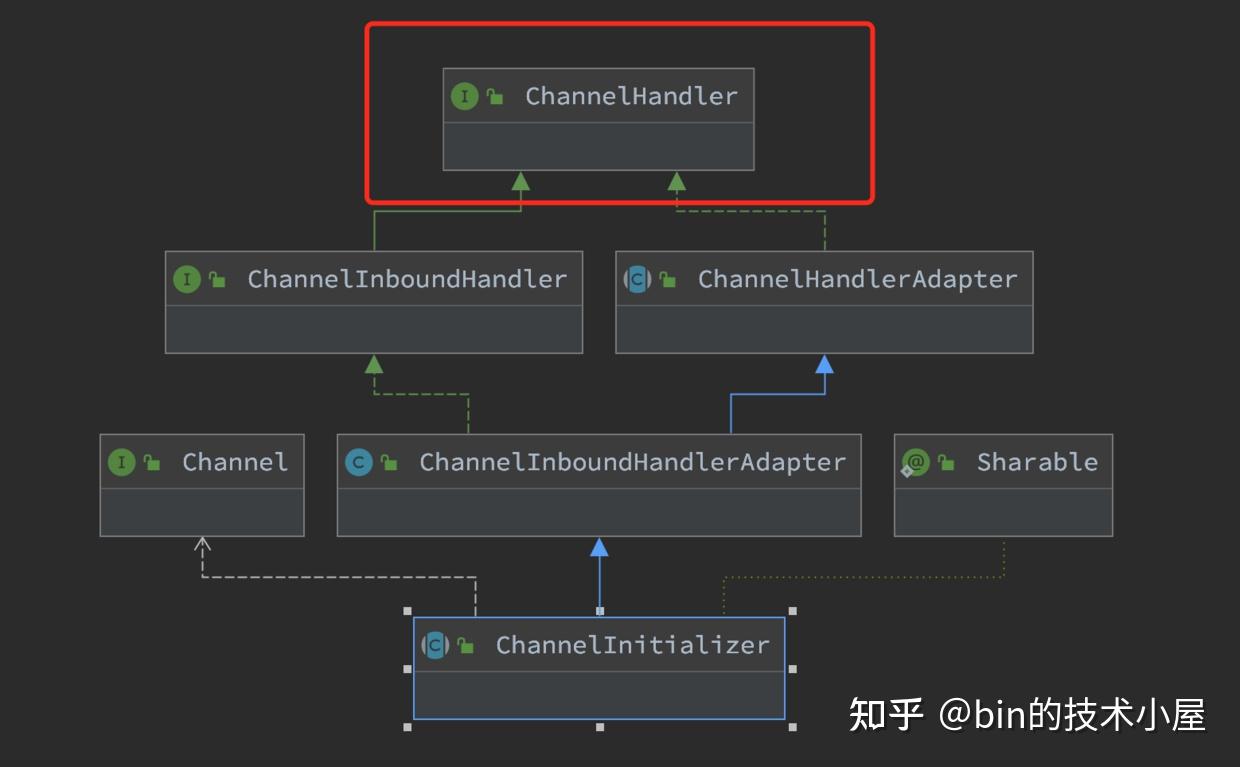

在我们通过ServerBootstrap配置netty服务端启动信息的时候,无论是向服务端NioServerSocketChannel的pipeline中添加ChannelHandler,还是向客户端NioSocketChannel的pipeline中添加ChannelHandler,当涉及到多个ChannelHandler添加的时候,我们都会用到ChannelInitializer,那么这个ChannelInitializer究竟是何方圣神,为什么要这样做呢?我们接着往下看~~

首先ChannelInitializer它继承于ChannelHandler,它自己本身就是一个ChannelHandler,所以它可以添加到childHandler中。

其他的父类大家这里可以不用管,后面文章中笔者会一一为大家详细介绍。

那为什么不直接添加ChannelHandler而是选择用ChannelInitializer呢?

这里主要有两点原因:

- 前边我们提到,客户端

NioSocketChannel是在服务端accept连接后,在服务端NioServerSocketChannel中被创建出来的。但是此时我们正处于配置ServerBootStrap阶段,服务端还没有启动,更没有客户端连接上来,此时客户端NioSocketChannel还没有被创建出来,所以也就没办法向客户端NioSocketChannel的pipeline中添加ChannelHandler。

- 客户端

NioSocketChannel中Pipeline里可以添加任意多个ChannelHandler,但是Netty框架无法预知用户到底需要添加多少个ChannelHandler,所以Netty框架提供了回调函数ChannelInitializer#initChannel,使用户可以自定义ChannelHandler的添加行为。

当客户端NioSocketChannel注册到对应的Sub Reactor上后,紧接着就会初始化NioSocketChannel中的Pipeline,此时Netty框架会回调ChannelInitializer#initChannel执行用户自定义的添加逻辑。

public abstract class ChannelInitializer<C extends Channel> extends ChannelInboundHandlerAdapter { @Override @SuppressWarnings("unchecked") public final void channelRegistered(ChannelHandlerContext ctx) throws Exception { //当channelRegister事件发生时,调用initChannel初始化pipeline if (initChannel(ctx)) { .................省略............... } else { .................省略............... } } private boolean initChannel(ChannelHandlerContext ctx) throws Exception { if (initMap.add(ctx)) { // Guard against re-entrance. try { //此时客户单NioSocketChannel已经创建并初始化好了 initChannel((C) ctx.channel()); } catch (Throwable cause) { .................省略............... } finally { .................省略............... } return true; } return false; } protected abstract void initChannel(C ch) throws Exception; .................省略............... }这里由netty框架回调的ChannelInitializer#initChannel方法正是我们自定义的添加逻辑。

final EchoServerHandler serverHandler = new EchoServerHandler(); serverBootstrap.childHandler(new ChannelInitializer<SocketChannel>() {//设置从Reactor中注册channel的pipeline @Override public void initChannel(SocketChannel ch) throws Exception { ChannelPipeline p = ch.pipeline(); p.addLast(new LoggingHandler(LogLevel.INFO)); p.addLast(serverHandler); } });到此为止,Netty服务端启动所需要的必要配置信息,已经全部存入ServerBootStrap启动辅助类中。

接下来要做的事情就是服务端的启动了。

// Start the server. 绑定端口启动服务,开始监听accept事件 ChannelFuture f = serverBootStrap.bind(PORT).sync();经过前面的铺垫终于来到了本文的核心内容----Netty服务端的启动过程。

如代码模板中的示例所示,Netty服务端的启动过程封装在io.netty.bootstrap.AbstractBootstrap#bind(int)函数中。

接下来我们看一下Netty服务端在启动过程中究竟干了哪些事情?

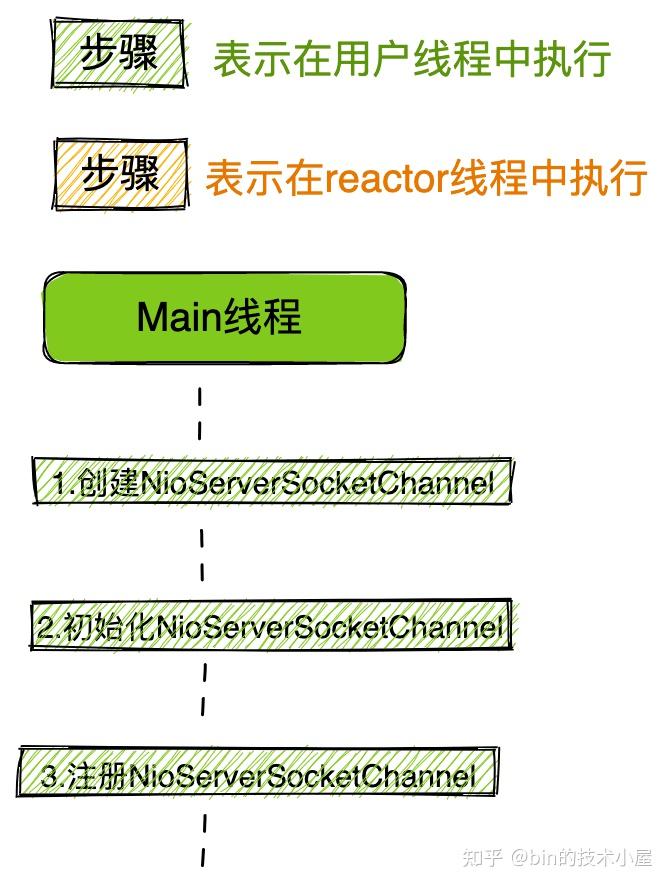

大家看到这副启动流程图先不要慌,接下来的内容笔者会带大家各个击破它,在文章的最后保证让大家看懂这副流程图。

我们先来从netty服务端启动的入口函数开始我们今天的源码解析旅程:

public ChannelFuture bind(int inetPort) { return bind(new InetSocketAddress(inetPort)); } public ChannelFuture bind(SocketAddress localAddress) { //校验Netty核心组件是否配置齐全 validate(); //服务端开始启动,绑定端口地址,接收客户端连接 return doBind(ObjectUtil.checkNotNull(localAddress, "localAddress")); } private ChannelFuture doBind(final SocketAddress localAddress) { //异步创建,初始化,注册ServerSocketChannel到main reactor上 final ChannelFuture regFuture = initAndRegister(); final Channel channel = regFuture.channel(); if (regFuture.cause() != null) { return regFuture; } if (regFuture.isDone()) { ........serverSocketChannel向Main Reactor注册成功后开始绑定端口...., } else { //如果此时注册操作没有完成,则向regFuture添加operationComplete回调函数,注册成功后回调。 regFuture.addListener(new ChannelFutureListener() { @Override public void operationComplete(ChannelFuture future) throws Exception { ........serverSocketChannel向Main Reactor注册成功后开始绑定端口...., }); return promise; } }Netty服务端的启动流程总体如下:

- 创建服务端

NioServerSocketChannel并初始化。

- 将服务端

NioServerSocketChannel注册到主Reactor线程组中。

- 注册成功后,开始初始化

NioServerSocketChannel中的pipeline,然后在pipeline中触发channelRegister事件。

- 随后由

NioServerSocketChannel绑定端口地址。

- 绑定端口地址成功后,向

NioServerSocketChannel对应的Pipeline中触发传播ChannelActive事件,在ChannelActive事件回调中向Main Reactor注册OP_ACCEPT事件,开始等待客户端连接。服务端启动完成。

当netty服务端启动成功之后,最终我们会得到如下结构的阵型,开始枕戈待旦,准备接收客户端的连接,Reactor开始运转。

接下来,我们就来看下Netty源码是如何实现以上步骤的~~

final ChannelFuture initAndRegister() { Channel channel = null; try { //创建NioServerSocketChannel //ReflectiveChannelFactory通过泛型,反射,工厂的方式灵活创建不同类型的channel channel = channelFactory.newChannel(); //初始化NioServerSocketChannel init(channel); } catch (Throwable t) { ..............省略................. } //向MainReactor注册ServerSocketChannel ChannelFuture regFuture = config().group().register(channel); ..............省略................. return regFuture; }从函数命名中我们可以看出,这个函数主要做的事情就是首先创建NioServerSocketChannel,并对NioServerSocketChannel进行初始化,最后将NioServerSocketChannel注册到Main Reactor中。

还记得我们在介绍ServerBootstrap启动辅助类配置服务端ServerSocketChannel类型的时候提到的工厂类ReflectiveChannelFactory吗?

因为当时我们在配置ServerBootstrap启动辅助类的时候,还没到启动阶段,而配置阶段并不是创建具体ServerSocketChannel的时机。

所以Netty通过工厂模式将要创建的ServerSocketChannel的类型(通过泛型指定)以及 创建的过程(封装在newChannel函数中)统统先封装在工厂类ReflectiveChannelFactory中。

ReflectiveChannelFactory通过泛型,反射,工厂的方式灵活创建不同类型的channel

等待创建时机来临,我们调用保存在ServerBootstrap中的channelFactory直接进行创建。

public class ReflectiveChannelFactory<T extends Channel> implements ChannelFactory<T> { private final Constructor<? extends T> constructor; @Override public T newChannel() { try { return constructor.newInstance(); } catch (Throwable t) { throw new ChannelException("Unable to create Channel from class " + constructor.getDeclaringClass(), t); } } }下面我们来看下NioServerSocketChannel的构建过程:

public class NioServerSocketChannel extends AbstractNioMessageChannel implements io.netty.channel.socket.ServerSocketChannel { //SelectorProvider(用于创建Selector和Selectable Channels) private static final SelectorProvider DEFAULT_SELECTOR_PROVIDER = SelectorProvider.provider(); public NioServerSocketChannel() { this(newSocket(DEFAULT_SELECTOR_PROVIDER)); } //创建JDK NIO ServerSocketChannel private static ServerSocketChannel newSocket(SelectorProvider provider) { try { return provider.openServerSocketChannel(); } catch (IOException e) { throw new ChannelException( "Failed to open a server socket.", e); } } //ServerSocketChannel相关的配置 private final ServerSocketChannelConfig config; public NioServerSocketChannel(ServerSocketChannel channel) { //父类AbstractNioChannel中保存JDK NIO原生ServerSocketChannel以及要监听的事件OP_ACCEPT super(null, channel, SelectionKey.OP_ACCEPT); //DefaultChannelConfig中设置用于Channel接收数据用的buffer->AdaptiveRecvByteBufAllocator config = new NioServerSocketChannelConfig(this, javaChannel().socket()); } }- 首先调用

newSocket创建JDK NIO 原生ServerSocketChannel,这里调用了SelectorProvider#openServerSocketChannel来创建JDK NIO 原生ServerSocketChannel,我们在上篇文章《聊聊Netty那些事儿之Reactor在Netty中的实现(创建篇)》中详细的介绍了SelectorProvider相关内容,当时是用SelectorProvider来创建Reactor中的Selector。大家还记得吗??

- 通过父类构造器设置

NioServerSocketChannel感兴趣的IO事件,这里设置的是SelectionKey.OP_ACCEPT事件。并将JDK NIO 原生ServerSocketChannel封装起来。

- 创建

Channel的配置类NioServerSocketChannelConfig,在配置类中封装了对Channel底层的一些配置行为,以及JDK中的ServerSocket。以及创建NioServerSocketChannel接收数据用的Buffer分配器AdaptiveRecvByteBufAllocator。

NioServerSocketChannelConfig没什么重要的东西,我们这里也不必深究,它就是管理NioServerSocketChannel相关的配置,这里唯一需要大家注意的是这个用于Channel接收数据用的Buffer分配器AdaptiveRecvByteBufAllocator,我们后面在介绍Netty如何接收连接的时候还会提到。

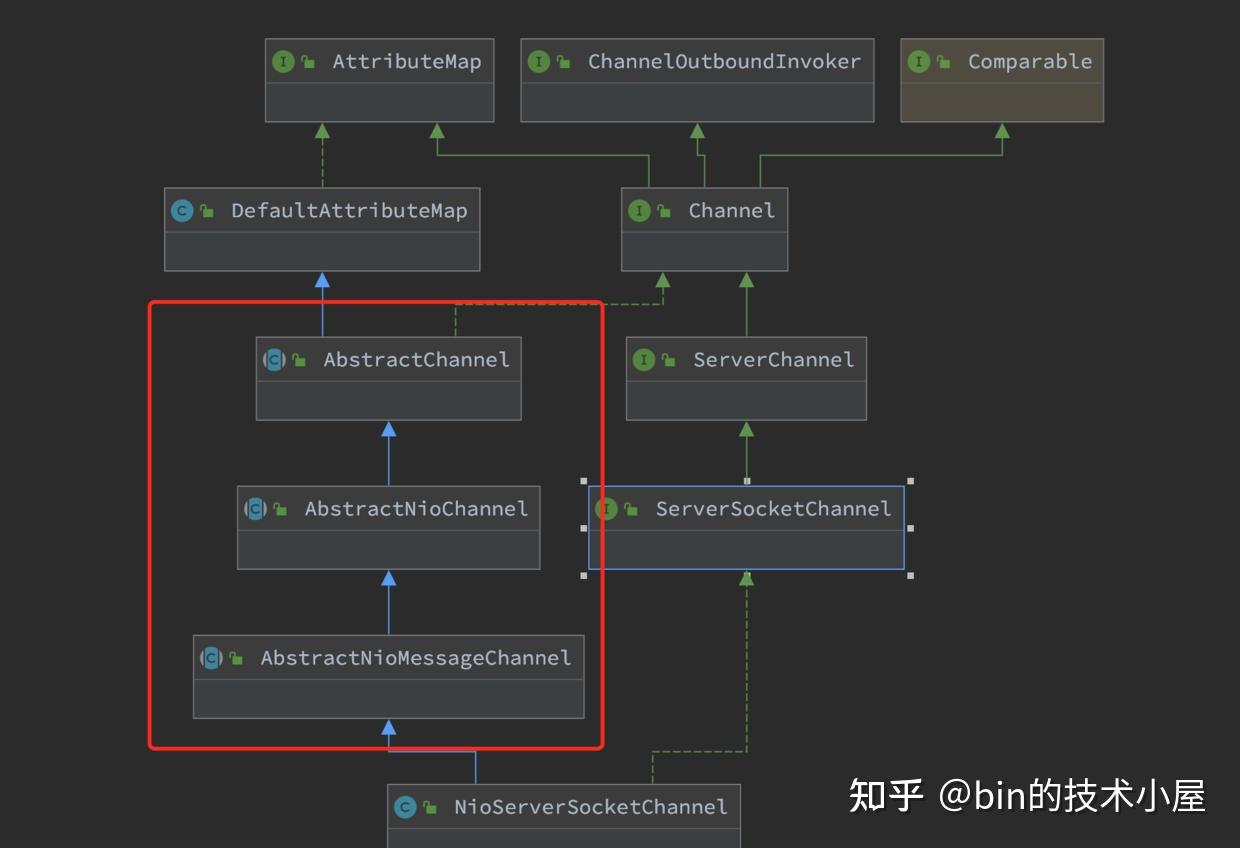

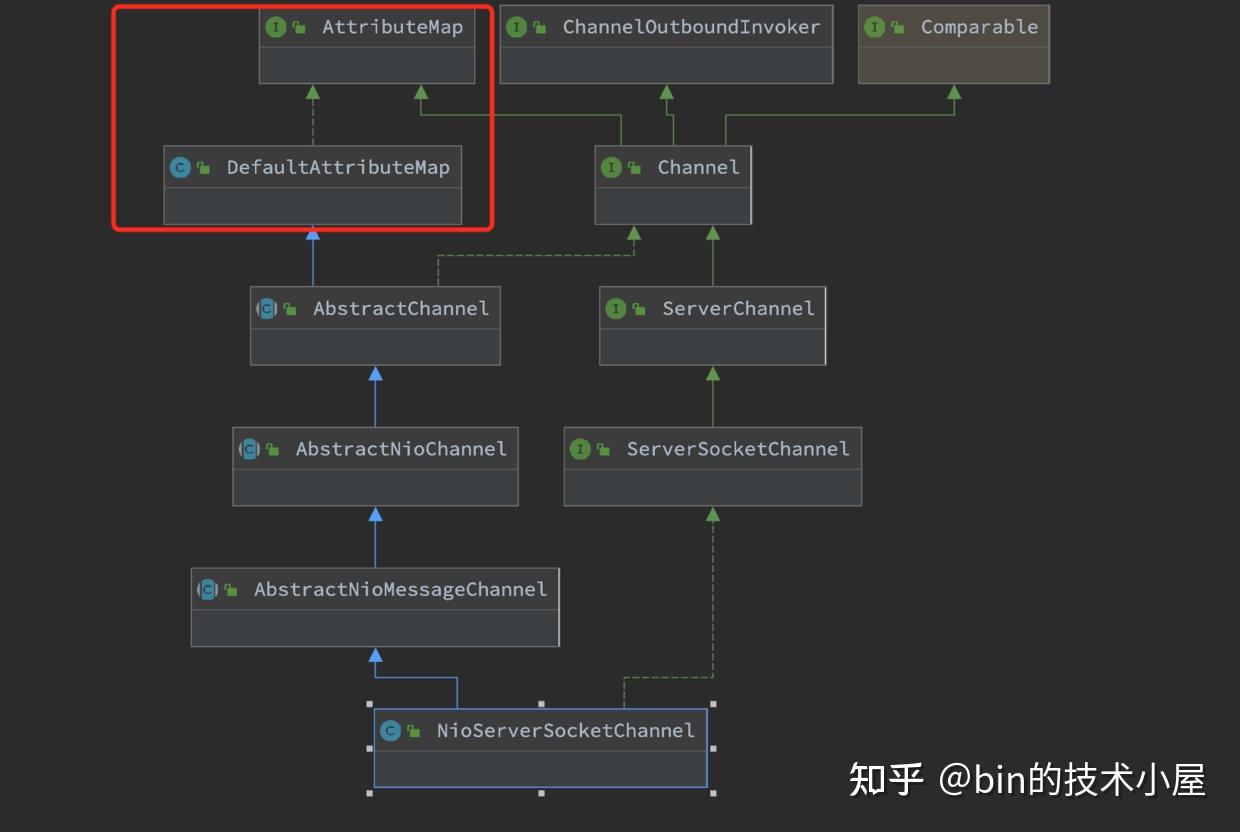

NioServerSocketChannel的整体构建过程介绍完了,现在我们来按照继承层次再回过头来看下NioServerSocketChannel的层次构建,来看下每一层都创建了什么,封装了什么,这些信息都是Channel的核心信息,所以有必要了解一下。

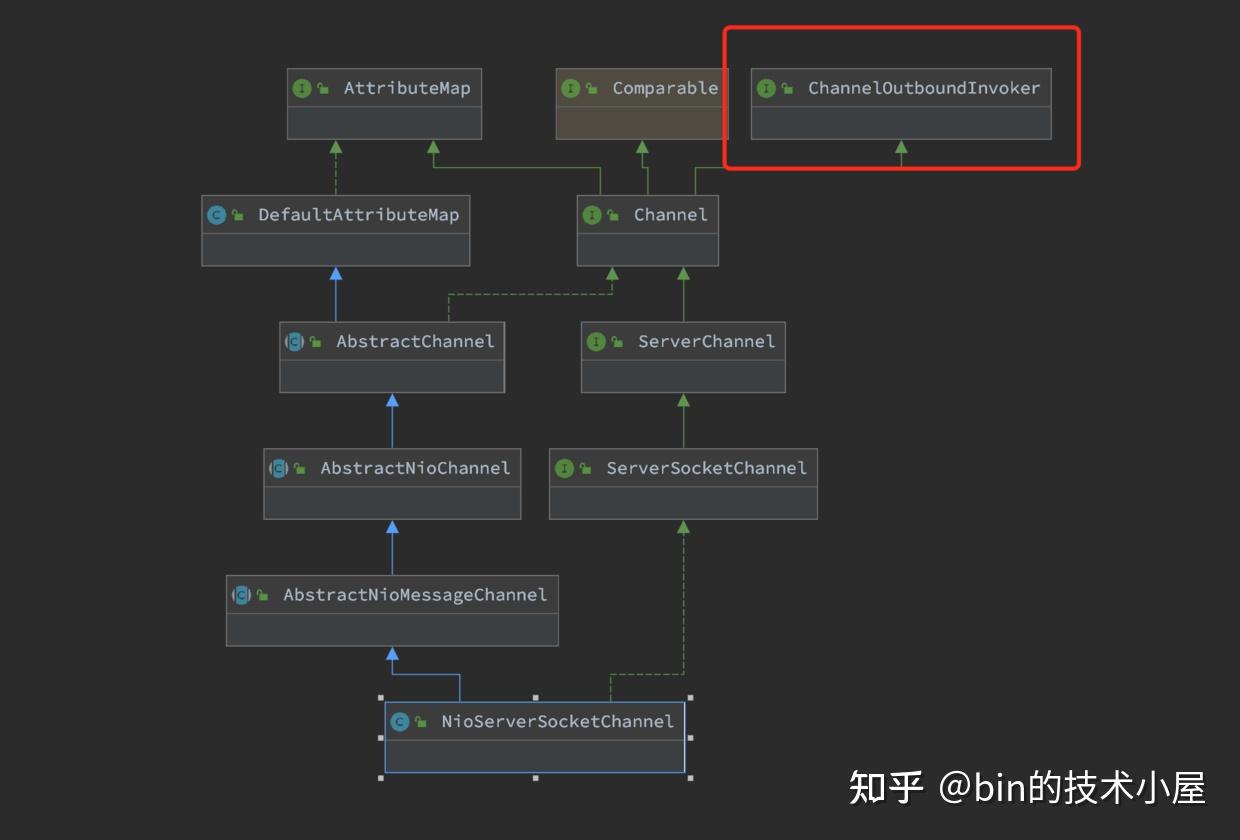

在NioServerSocketChannel的创建过程中,我们主要关注继承结构图中红框标注的三个类,其他的我们占时先不用管。

其中AbstractNioMessageChannel类主要是对NioServerSocketChannel底层读写行为的封装和定义,比如accept接收客户端连接。这个我们后续会介绍到,这里我们并不展开。

public abstract class AbstractNioChannel extends AbstractChannel { //JDK NIO原生Selectable Channel private final SelectableChannel ch; // Channel监听事件集合 这里是SelectionKey.OP_ACCEPT事件 protected final int readInterestOp; protected AbstractNioChannel(Channel parent, SelectableChannel ch, int readInterestOp) { super(parent); this.ch = ch; this.readInterestOp = readInterestOp; try { //设置Channel为非阻塞 配合IO多路复用模型 ch.configureBlocking(false); } catch (IOException e) { .............省略................ } } }- 封装由

SelectorProvider创建出来的JDK NIO原生ServerSocketChannel。

- 封装

Channel在创建时指定感兴趣的IO事件,对于NioServerSocketChannel来说感兴趣的IO事件为OP_ACCEPT事件。

- 设置JDK NIO原生

ServerSocketChannel为非阻塞模式, 配合IO多路复用模型。

public abstract class AbstractChannel extends DefaultAttributeMap implements Channel { //channel是由创建层次的,比如ServerSocketChannel 是 SocketChannel的 parent private final Channel parent; //channel全局唯一ID machineId+processId+sequence+timestamp+random private final ChannelId id; //unsafe用于封装对底层socket的相关操作 private final Unsafe unsafe; //为channel分配独立的pipeline用于IO事件编排 private final DefaultChannelPipeline pipeline; protected AbstractChannel(Channel parent) { this.parent = parent; //channel全局唯一ID machineId+processId+sequence+timestamp+random id = newId(); //unsafe用于定义实现对Channel的底层操作 unsafe = newUnsafe(); //为channel分配独立的pipeline用于IO事件编排 pipeline = newChannelPipeline(); } }- Netty中的

Channel创建是有层次的,这里的parent属性用来保存上一级的Channel,比如这里的NioServerSocketChannel是顶级Channel,所以它的parent = null。客户端NioSocketChannel是由NioServerSocketChannel创建的,所以它的parent = NioServerSocketChannel。

- 为

Channel分配全局唯一的ChannelId。ChannelId由机器Id(machineId),进程Id(processId),序列号(sequence),时间戳(timestamp),随机数(random)构成

private DefaultChannelId() { data = new byte[MACHINE_ID.length + PROCESS_ID_LEN + SEQUENCE_LEN + TIMESTAMP_LEN + RANDOM_LEN]; int i = 0; // machineId System.arraycopy(MACHINE_ID, 0, data, i, MACHINE_ID.length); i += MACHINE_ID.length; // processId i = writeInt(i, PROCESS_ID); // sequence i = writeInt(i, nextSequence.getAndIncrement()); // timestamp (kind of) i = writeLong(i, Long.reverse(System.nanoTime()) ^ System.currentTimeMillis()); // random int random = PlatformDependent.threadLocalRandom().nextInt(); i = writeInt(i, random); assert i == data.length; hashCode = Arrays.hashCode(data); }- 创建

NioServerSocketChannel的底层操作类Unsafe。这里创建的是io.netty.channel.nio.AbstractNioMessageChannel.NioMessageUnsafe。

Unsafe为Channel接口的一个内部接口,用于定义实现对Channel底层的各种操作,Unsafe接口定义的操作行为只能由Netty框架的Reactor线程调用,用户线程禁止调用。

interface Unsafe { //分配接收数据用的Buffer RecvByteBufAllocator.Handle recvBufAllocHandle(); //服务端绑定的端口地址 SocketAddress localAddress(); //远端地址 SocketAddress remoteAddress(); //channel向Reactor注册 void register(EventLoop eventLoop, ChannelPromise promise); //服务端绑定端口地址 void bind(SocketAddress localAddress, ChannelPromise promise); //客户端连接服务端 void connect(SocketAddress remoteAddress, SocketAddress localAddress, ChannelPromise promise); //关闭channle void close(ChannelPromise promise); //读数据 void beginRead(); //写数据 void write(Object msg, ChannelPromise promise); }- 为

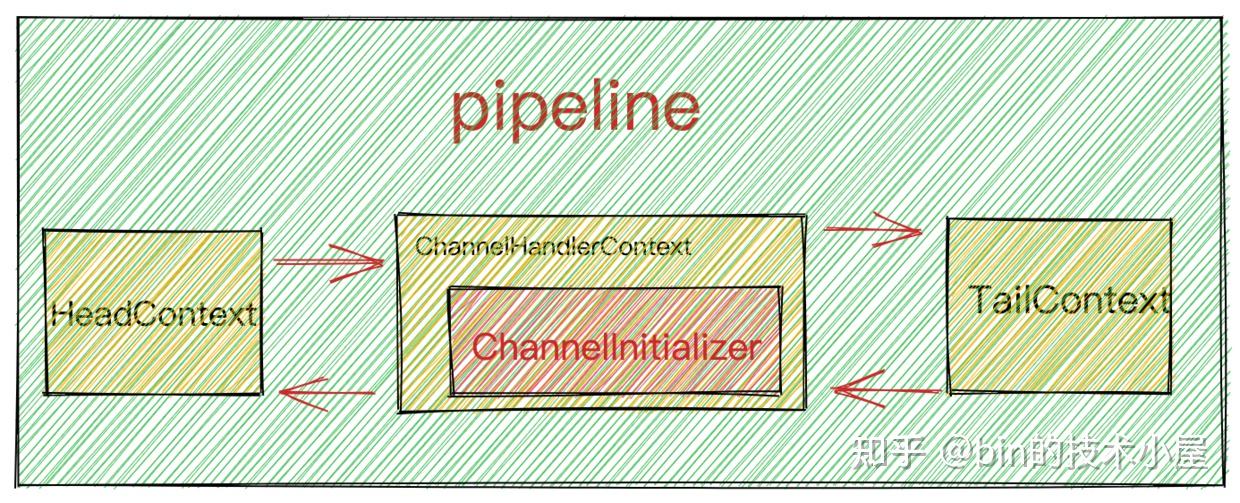

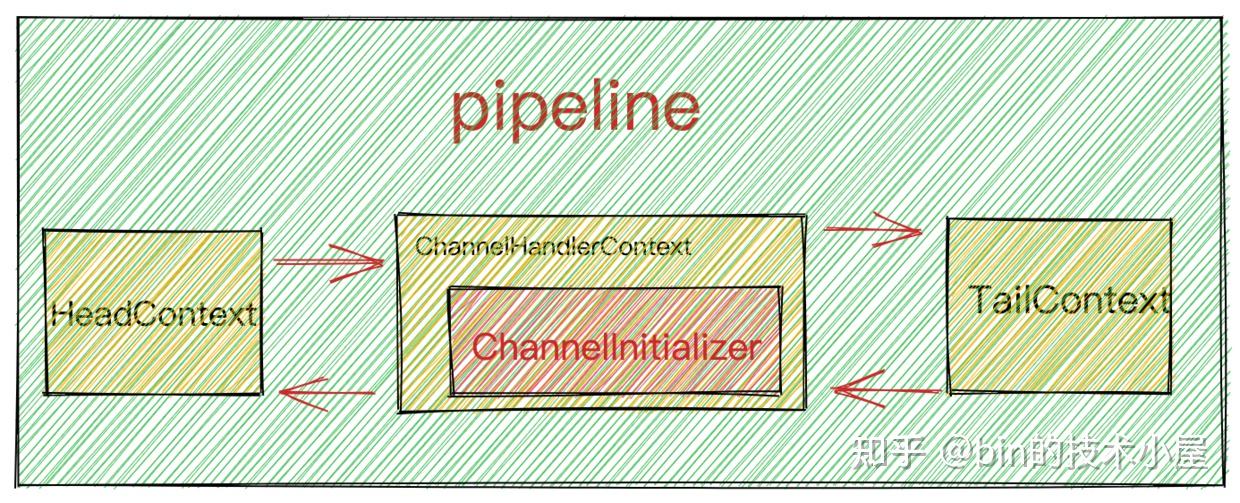

NioServerSocketChannel分配独立的pipeline用于IO事件编排。pipeline其实是一个ChannelHandlerContext类型的双向链表。头结点HeadContext,尾结点TailContext。ChannelHandlerContext中包装着ChannelHandler。

ChannelHandlerContext保存 ChannelHandler上下文信息,用于事件传播。后面笔者会单独开一篇文章介绍,这里我们还是聚焦于启动主线。

这里只是为了让大家简单理解pipeline的一个大致的结构,后面会写一篇文章专门详细讲解pipeline。

protected DefaultChannelPipeline(Channel channel) { this.channel = ObjectUtil.checkNotNull(channel, "channel"); succeededFuture = new SucceededChannelFuture(channel, null); voidPromise = new VoidChannelPromise(channel, true); tail = new TailContext(this); head = new HeadContext(this); head.next = tail; tail.prev = head; }

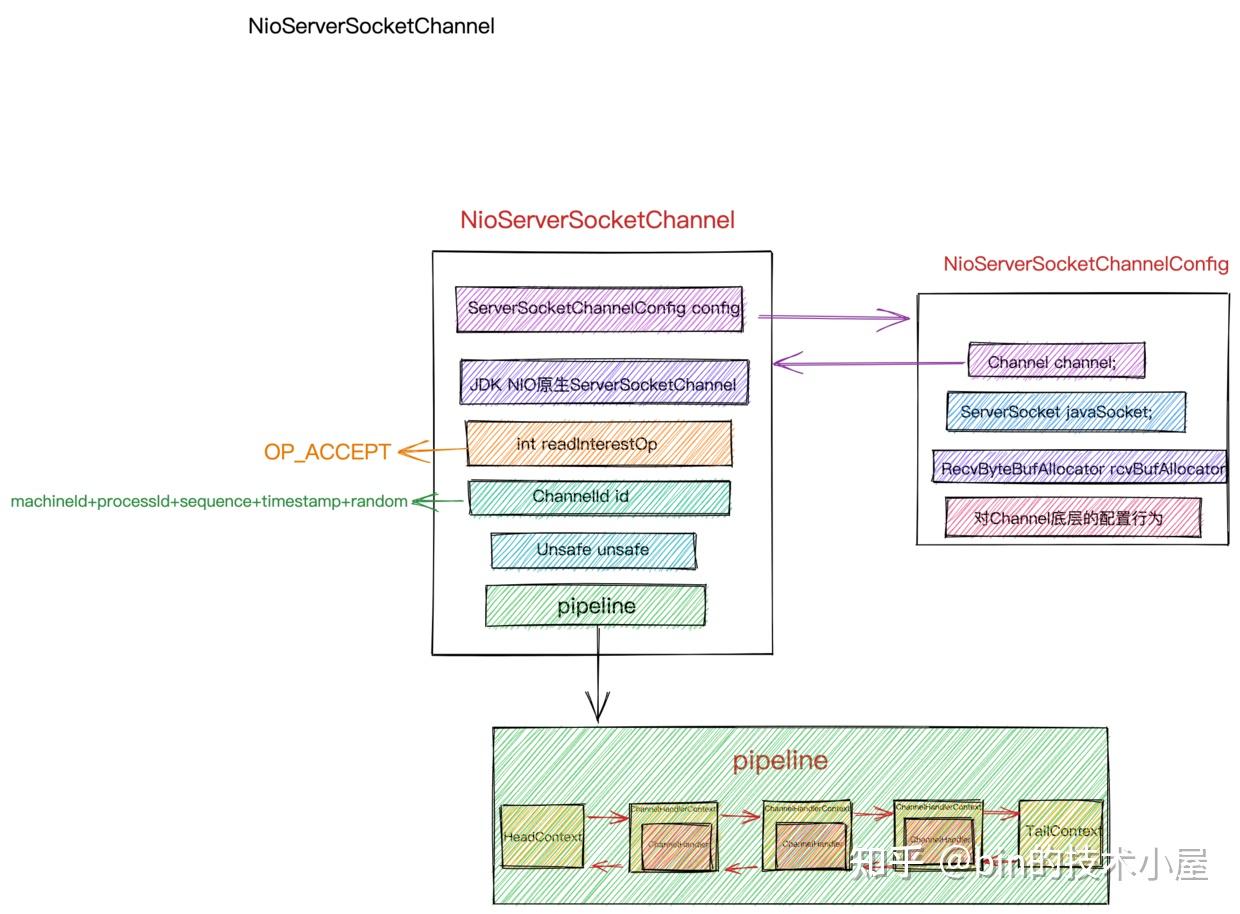

到了这里NioServerSocketChannel就创建完毕了,我们来回顾下它到底包含了哪些核心信息。

void init(Channel channel) { //向NioServerSocketChannelConfig设置ServerSocketChannelOption setChannelOptions(channel, newOptionsArray(), logger); //向netty自定义的NioServerSocketChannel设置attributes setAttributes(channel, attrs0().entrySet().toArray(EMPTY_ATTRIBUTE_ARRAY)); ChannelPipeline p = channel.pipeline(); //获取从Reactor线程组 final EventLoopGroup currentChildGroup = childGroup; //获取用于初始化客户端NioSocketChannel的ChannelInitializer final ChannelHandler currentChildHandler = childHandler; //获取用户配置的客户端SocketChannel的channelOption以及attributes final Entry<ChannelOption<?>, Object>[] currentChildOptions; synchronized (childOptions) { currentChildOptions = childOptions.entrySet().toArray(EMPTY_OPTION_ARRAY); } final Entry<AttributeKey<?>, Object>[] currentChildAttrs = childAttrs.entrySet().toArray(EMPTY_ATTRIBUTE_ARRAY); //向NioServerSocketChannel中的pipeline添加初始化ChannelHandler的逻辑 p.addLast(new ChannelInitializer<Channel>() { @Override public void initChannel(final Channel ch) { final ChannelPipeline pipeline = ch.pipeline(); //ServerBootstrap中用户指定的channelHandler ChannelHandler handler = config.handler(); if (handler != null) { //LoggingHandler pipeline.addLast(handler); } //添加用于接收客户端连接的acceptor ch.eventLoop().execute(new Runnable() { @Override public void run() { pipeline.addLast(new ServerBootstrapAcceptor( ch, currentChildGroup, currentChildHandler, currentChildOptions, currentChildAttrs)); } }); } }); }- 向

NioServerSocketChannelConfig设置ServerSocketChannelOption。

- 向netty自定义的

NioServerSocketChannel设置ChannelAttributes

Netty自定义的SocketChannel类型均继承AttributeMap接口以及DefaultAttributeMap类,正是它们定义了ChannelAttributes。用于向Channel添加用户自定义的一些信息。

这个ChannelAttributes的用处大有可为,Netty后边的许多特性都是依靠这个ChannelAttributes来实现的。这里先卖个关子,大家可以自己先想一下可以用这个ChannelAttributes做哪些事情?

- 获取从Reactor线程组

childGroup,以及用于初始化客户端NioSocketChannel的ChannelInitializer,ChannelOption,ChannelAttributes,这些信息均是由用户在启动的时候向ServerBootstrap添加的客户端NioServerChannel配置信息。这里用这些信息来初始化ServerBootstrapAcceptor。因为后续会在ServerBootstrapAcceptor中接收客户端连接以及创建NioServerChannel。

- 向

NioServerSocketChannel中的pipeline添加用于初始化pipeline的ChannelInitializer。

问题来了,这里为什么不干脆直接将ChannelHandler添加到pipeline中,而是又使用到了ChannelInitializer呢?

其实原因有两点:

- 为了保证

线程安全地初始化pipeline,所以初始化的动作需要由Reactor线程进行,而当前线程是用户程序的启动Main线程并不是Reactor线程。这里不能立即初始化。

- 初始化

Channel中pipeline的动作,需要等到Channel注册到对应的Reactor中才可以进行初始化,当前只是创建好了NioServerSocketChannel,但并未注册到Main Reactor上。

初始化NioServerSocketChannel中pipeline的时机是:当NioServerSocketChannel注册到Main Reactor之后,绑定端口地址之前。

前边在介绍ServerBootstrap配置childHandler时也用到了ChannelInitializer,还记得吗??

问题又来了,大家注意下ChannelInitializer#initChannel方法,在该初始化回调方法中,添加LoggingHandler是直接向pipeline中添加,而添加Acceptor为什么不是直接添加而是封装成异步任务呢?

这里先给大家卖个关子,笔者会在后续流程中为大家解答~~~~~

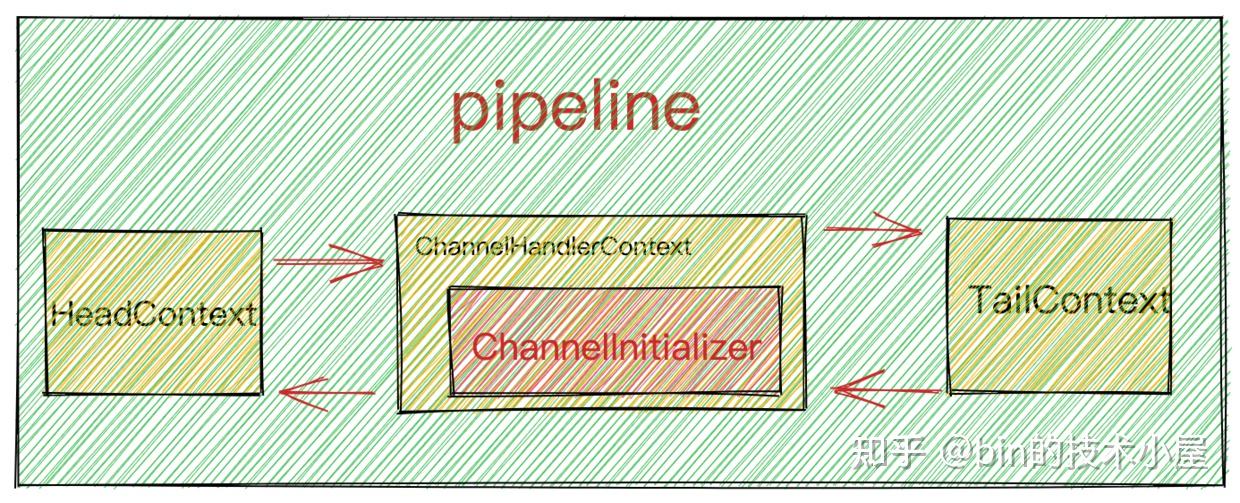

此时NioServerSocketChannel中的pipeline结构如下图所示:

从ServerBootstrap获取主Reactor线程组NioEventLoopGroup,将NioServerSocketChannel注册到NioEventLoopGroup中。

ChannelFuture regFuture = config().group().register(channel);下面我们来看下具体的注册过程:

@Override public ChannelFuture register(Channel channel) { return next().register(channel); } @Override public EventExecutor next() { return chooser.next(); } //获取绑定策略 @Override public EventExecutorChooser newChooser(EventExecutor[] executors) { if (isPowerOfTwo(executors.length)) { return new PowerOfTwoEventExecutorChooser(executors); } else { return new GenericEventExecutorChooser(executors); } } //采用轮询round-robin的方式选择Reactor @Override public EventExecutor next() { return executors[(int) Math.abs(idx.getAndIncrement() % executors.length)]; }Netty通过next()方法根据上篇文章《聊聊Netty那些事儿之Reactor在Netty中的实现(创建篇)》提到的channel到reactor的绑定策略,从ReactorGroup中选取一个Reactor进行注册绑定。之后Channel生命周期内的所有IO 事件都由这个Reactor 负责处理,如 accept、connect、read、write等 IO 事件。

一个channel只能绑定到一个Reactor上,一个Reactor负责监听多个channel。

由于这里是NioServerSocketChannle向Main Reactor进行注册绑定,所以Main Reactor主要负责处理的IO事件是OP_ACCEPT事件。

向Reactor进行注册的行为定义在NioEventLoop的父类SingleThreadEventLoop中,印象模糊的同学可以在回看下上篇文章中的NioEventLoop继承结构小节内容。

public abstract class SingleThreadEventLoop extends SingleThreadEventExecutor implements EventLoop { @Override public ChannelFuture register(Channel channel) { //注册channel到绑定的Reactor上 return register(new DefaultChannelPromise(channel, this)); } @Override public ChannelFuture register(final ChannelPromise promise) { ObjectUtil.checkNotNull(promise, "promise"); //unsafe负责channel底层的各种操作 promise.channel().unsafe().register(this, promise); return promise; } }通过NioServerSocketChannel中的Unsafe类执行底层具体的注册动作。

protected abstract class AbstractUnsafe implements Unsafe { / * 注册Channel到绑定的Reactor上 * */ @Override public final void register(EventLoop eventLoop, final ChannelPromise promise) { ObjectUtil.checkNotNull(eventLoop, "eventLoop"); if (isRegistered()) { promise.setFailure(new IllegalStateException("registered to an event loop already")); return; } //EventLoop的类型要与Channel的类型一样 Nio Oio Aio if (!isCompatible(eventLoop)) { promise.setFailure( new IllegalStateException("incompatible event loop type: " + eventLoop.getClass().getName())); return; } //在channel上设置绑定的Reactor AbstractChannel.this.eventLoop = eventLoop; / * 执行channel注册的操作必须是Reactor线程来完成 * * 1: 如果当前执行线程是Reactor线程,则直接执行register0进行注册 * 2:如果当前执行线程是外部线程,则需要将register0注册操作 封装程异步Task 由Reactor线程执行 * */ if (eventLoop.inEventLoop()) { register0(promise); } else { try { eventLoop.execute(new Runnable() { @Override public void run() { register0(promise); } }); } catch (Throwable t) { ...............省略............... } } } }- 首先检查

NioServerSocketChannel是否已经完成注册。如果以完成注册,则直接设置代表注册操作结果的ChannelPromise为fail状态。

- 通过

isCompatible方法验证Reactor模型EventLoop是否与Channel的类型匹配。NioEventLoop对应于NioServerSocketChannel。

上篇文章我们介绍过 Netty对三种IO模型:Oio,Nio,Aio的支持,用户可以通过改变Netty核心类的前缀轻松切换IO模型。isCompatible方法目的就是需要保证Reactor和Channel使用的是同一种IO模型。

- 在

Channel中保存其绑定的Reactor实例。

- 执行

Channel向Reactor注册的动作必须要确保是在Reactor线程中执行。

- 如果当前线程是

Reactor线程则直接执行注册动作register0 - 如果当前线程不是

Reactor线程,则需要将注册动作register0封装成异步任务,存放在Reactor中的taskQueue中,等待Reactor线程执行。

当前执行线程并不是Reactor线程,而是用户程序的启动线程Main线程。

上篇文章中我们在介绍NioEventLoopGroup的创建过程中提到了一个构造器参数executor,它用于启动Reactor线程,类型为ThreadPerTaskExecutor。

当时笔者向大家卖了一个关子~~“Reactor线程是何时启动的?”

那么现在就到了为大家揭晓谜底的时候了~~

Reactor线程的启动是在向Reactor提交第一个异步任务的时候启动的。

Netty中的主Reactor线程组NioEventLoopGroup中的Main ReactorNioEventLoop是在用户程序Main线程向Main Reactor提交用于注册NioServerSocketChannel的异步任务时开始启动。

eventLoop.execute(new Runnable() { @Override public void run() { register0(promise); } });接下来我们关注下NioEventLoop的execute方法

public abstract class SingleThreadEventExecutor extends AbstractScheduledEventExecutor implements OrderedEventExecutor { @Override public void execute(Runnable task) { ObjectUtil.checkNotNull(task, "task"); execute(task, !(task instanceof LazyRunnable) && wakesUpForTask(task)); } private void execute(Runnable task, boolean immediate) { //当前线程是否为Reactor线程 boolean inEventLoop = inEventLoop(); //addTaskWakesUp = true addTask唤醒Reactor线程执行任务 addTask(task); if (!inEventLoop) { //如果当前线程不是Reactor线程,则启动Reactor线程 //这里可以看出Reactor线程的启动是通过 向NioEventLoop添加异步任务时启动的 startThread(); .....................省略..................... } .....................省略..................... } }- 首先将异步任务

task添加到Reactor中的taskQueue中。

- 判断当前线程是否为

Reactor线程,此时当前执行线程为用户程序启动线程,所以这里调用startThread启动Reactor线程。

public abstract class SingleThreadEventExecutor extends AbstractScheduledEventExecutor implements OrderedEventExecutor { //定义Reactor线程状态 private static final int ST_NOT_STARTED = 1; private static final int ST_STARTED = 2; private static final int ST_SHUTTING_DOWN = 3; private static final int ST_SHUTDOWN = 4; private static final int ST_TERMINATED = 5; //Reactor线程状态 初始为 未启动状态 private volatile int state = ST_NOT_STARTED; //Reactor线程状态字段state 原子更新器 private static final AtomicIntegerFieldUpdater<SingleThreadEventExecutor> STATE_UPDATER = AtomicIntegerFieldUpdater.newUpdater(SingleThreadEventExecutor.class, "state"); private void startThread() { if (state == ST_NOT_STARTED) { if (STATE_UPDATER.compareAndSet(this, ST_NOT_STARTED, ST_STARTED)) { boolean success = false; try { doStartThread(); success = true; } finally { if (!success) { STATE_UPDATER.compareAndSet(this, ST_STARTED, ST_NOT_STARTED); } } } } } }Reactor线程初始化状态为ST_NOT_STARTED,首先CAS更新状态为ST_STARTED

doStartThread启动Reactor线程

- 启动失败的话,需要将

Reactor线程状态改回ST_NOT_STARTED

//ThreadPerTaskExecutor 用于启动Reactor线程 private final Executor executor; private void doStartThread() { assert thread == null; executor.execute(new Runnable() { @Override public void run() { thread = Thread.currentThread(); if (interrupted) { thread.interrupt(); } boolean success = false; updateLastExecutionTime(); try { //Reactor线程开始启动 SingleThreadEventExecutor.this.run(); success = true; } ................省略.............. }这里就来到了ThreadPerTaskExecutor类型的executor的用武之地了。

Reactor线程的核心工作之前介绍过:轮询所有注册其上的Channel中的IO就绪事件,处理对应Channel上的IO事件,执行异步任务。Netty将这些核心工作封装在io.netty.channel.nio.NioEventLoop#run方法中。

- 将

NioEventLoop#run封装在异步任务中,提交给executor执行,Reactor线程至此开始工作了就。

public final class ThreadPerTaskExecutor implements Executor { private final ThreadFactory threadFactory; @Override public void execute(Runnable command) { //启动Reactor线程 threadFactory.newThread(command).start(); } }此时Reactor线程已经启动,后面的工作全部都由这个Reactor线程来负责执行了。

而用户启动线程在向Reactor提交完NioServerSocketChannel的注册任务register0后,就逐步退出调用堆栈,回退到最开始的启动入口处ChannelFuture f = b.bind(PORT).sync()。

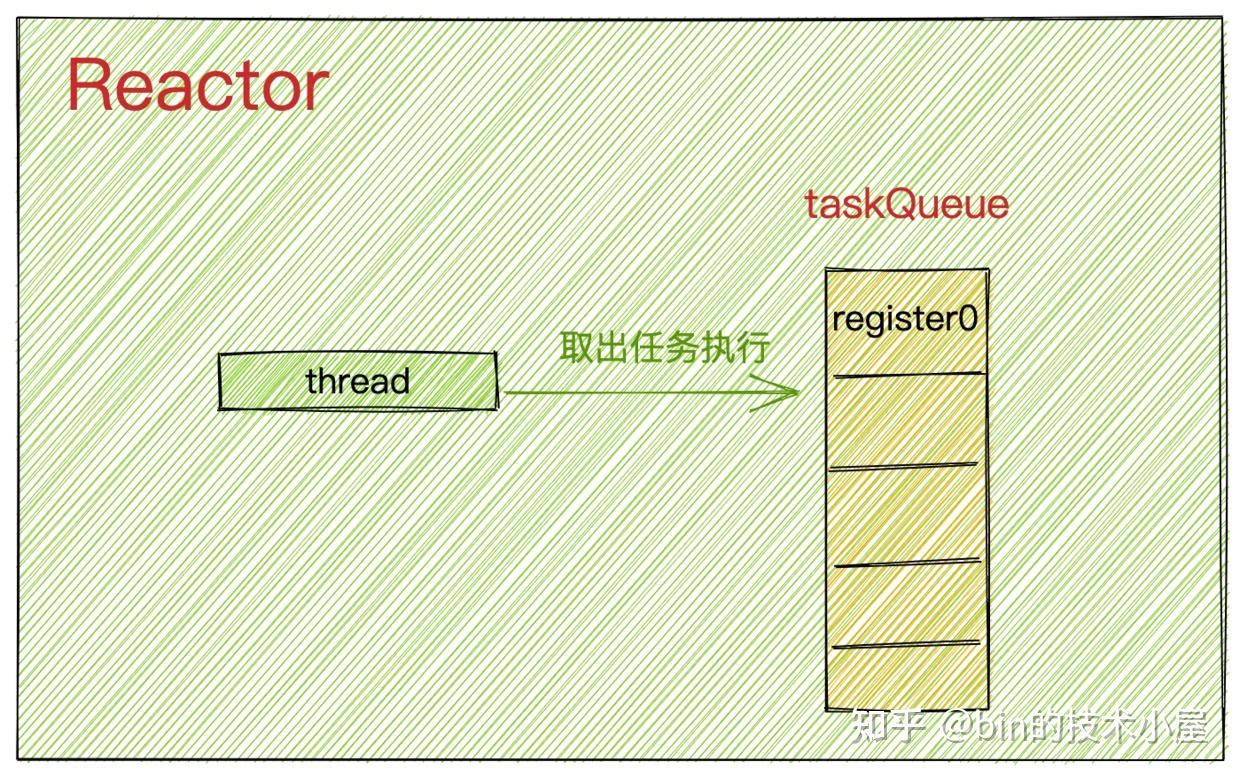

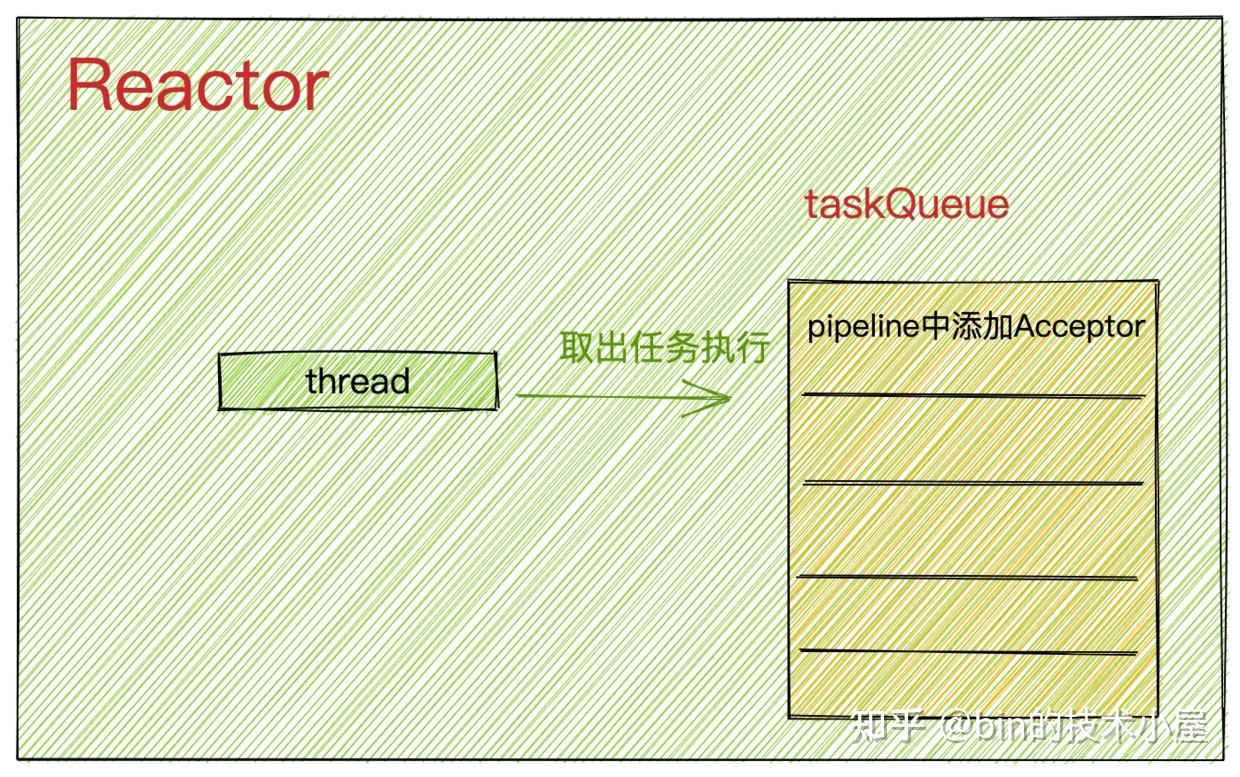

此时Reactor中的任务队列中只有一个任务register0,Reactor线程启动后,会从任务队列中取出任务执行。

至此NioServerSocketChannel的注册工作正式拉开帷幕~~

//true if the channel has never been registered, false otherwise private boolean neverRegistered = true; private void register0(ChannelPromise promise) { try { //查看注册操作是否已经取消,或者对应channel已经关闭 if (!promise.setUncancellable() || !ensureOpen(promise)) { return; } boolean firstRegistration = neverRegistered; //执行真正的注册操作 doRegister(); //修改注册状态 neverRegistered = false; registered = true; //回调pipeline中添加的ChannelInitializer的handlerAdded方法,在这里初始化channelPipeline pipeline.invokeHandlerAddedIfNeeded(); //设置regFuture为success,触发operationComplete回调,将bind操作放入Reactor的任务队列中,等待Reactor线程执行。 safeSetSuccess(promise); //触发channelRegister事件 pipeline.fireChannelRegistered(); //对于服务端ServerSocketChannel来说 只有绑定端口地址成功后 channel的状态才是active的。 //此时绑定操作作为异步任务在Reactor的任务队列中,绑定操作还没开始,所以这里的isActive()是false if (isActive()) { if (firstRegistration) { //触发channelActive事件 pipeline.fireChannelActive(); } else if (config().isAutoRead()) { beginRead(); } } } catch (Throwable t) { ............省略............. } }register0是驱动整个Channel注册绑定流程的关键方法,下面我们来看下它的核心逻辑:

- 首先需要检查

Channel的注册动作是否在Reactor线程外被取消了已经!promise.setUncancellable()。检查要注册的Channel是否已经关闭!ensureOpen(promise)。如果Channel已经关闭或者注册操作已经被取消,那么就直接返回,停止注册流程。

- 调用

doRegister()方法,执行真正的注册操作。最终实现在AbstractChannel的子类AbstractNioChannel中,这个我们一会在介绍,先关注整体流程。

public abstract class AbstractChannel extends DefaultAttributeMap implements Channel { / * Is called after the {@link Channel} is registered with its {@link EventLoop} as part of the register process. * * Sub-classes may override this method */ protected void doRegister() throws Exception { // NOOP } }- 当

Channel向Reactor注册完毕后,调用pipeline.invokeHandlerAddedIfNeeded()方法,触发回调pipeline中添加的ChannelInitializer的handlerAdded方法,在handlerAdded方法中利用前面提到的ChannelInitializer初始化ChannelPipeline。

初始化ChannelPipeline的时机是当Channel向对应的Reactor注册成功后,在handlerAdded事件回调中利用ChannelInitializer进行初始化。

- 设置

regFuture为Success,并回调注册在regFuture上的ChannelFutureListener#operationComplete方法,在operationComplete回调方法中将绑定操作封装成异步任务,提交到Reactor的taskQueue中。等待Reactor的执行。

还记得这个regFuture在哪里出现的吗?它是在哪里被创建,又是在哪里添加的ChannelFutureListener呢? 大家还有印象吗?回忆不起来也没关系,笔者后面还会提到

- 通过

pipeline.fireChannelRegistered()在pipeline中触发channelRegister事件。

pipeline中channelHandler的channelRegistered方法被回调。

- 对于Netty服务端

NioServerSocketChannel来说, 只有绑定端口地址成功后 channel的状态才是active的。此时绑定操作在regFuture上注册的ChannelFutureListener#operationComplete回调方法中被作为异步任务提交到了Reactor的任务队列中,Reactor线程还没开始执行绑定任务。所以这里的isActive()是false。

当Reactor线程执行完register0方法后,才会去执行绑定任务。

下面我们来看下register0方法中这些核心步骤的具体实现:

public abstract class AbstractNioChannel extends AbstractChannel { //channel注册到Selector后获得的SelectKey volatile SelectionKey selectionKey; @Override protected void doRegister() throws Exception { boolean selected = false; for (;;) { try { selectionKey = javaChannel().register(eventLoop().unwrappedSelector(), 0, this); return; } catch (CancelledKeyException e) { ...............省略.................... } } } }调用底层JDK NIO Channel方法java.nio.channels.SelectableChannel#register(java.nio.channels.Selector, int, java.lang.Object),将NettyNioServerSocketChannel中包装的JDK NIO ServerSocketChannel注册到Reactor中的JDK NIO Selector上。

简单介绍下SelectableChannel#register方法参数的含义:

Selector:表示JDK NIO Channel将要向哪个Selector进行注册。

int ops:表示Channel上感兴趣的IO事件,当对应的IO事件就绪时,Selector会返回Channel对应的SelectionKey。

SelectionKey可以理解为Channel在Selector上的特殊表示形式,SelectionKey中封装了Channel感兴趣的IO事件集合~~~interestOps,以及IO就绪的事件集合~~readyOps, 同时也封装了对应的JDK NIO Channel以及注册的Selector。最后还有一个重要的属性attachment,可以允许我们在SelectionKey上附加一些自定义的对象。

Object attachment:向SelectionKey中添加用户自定义的附加对象。

这里NioServerSocketChannel向Reactor中的Selector注册的IO事件为0,这个操作的主要目的是先获取到Channel在Selector中对应的SelectionKey,完成注册。当绑定操作完成后,在去向SelectionKey添加感兴趣的IO事件~~~OP_ACCEPT事件。

同时通过SelectableChannel#register方法将Netty自定义的NioServerSocketChannel(这里的this指针)附着在SelectionKey的attechment属性上, 完成Netty自定义Channel与JDK NIOChannel的关系绑定。这样在每次对Selector进行IO就绪事件轮询时,Netty 都可以从JDK NIO Selector返回的SelectionKey中获取到自定义的Channel对象(这里指的就是NioServerSocketChannel)。

当NioServerSocketChannel注册到Main Reactor上的Selector后,Netty通过调用pipeline.invokeHandlerAddedIfNeeded()开始回调NioServerSocketChannel中pipeline里的ChannelHandler的handlerAdded方法。

此时NioServerSocketChannel的pipeline结构如下:

此时pipeline中只有在初始化NioServerSocketChannel时添加的ChannelInitializer。

我们来看下ChannelInitializer中handlerAdded回调方法具体作了哪些事情~~

public abstract class ChannelInitializer<C extends Channel> extends ChannelInboundHandlerAdapter { @Override public void handlerAdded(ChannelHandlerContext ctx) throws Exception { if (ctx.channel().isRegistered()) { if (initChannel(ctx)) { //初始化工作完成后,需要将自身从pipeline中移除 removeState(ctx); } } } //ChannelInitializer实例是被所有的Channel共享的,用于初始化ChannelPipeline //通过Set集合保存已经初始化的ChannelPipeline,避免重复初始化同一ChannelPipeline private final Set<ChannelHandlerContext> initMap = Collections.newSetFromMap( new ConcurrentHashMap<ChannelHandlerContext, Boolean>()); private boolean initChannel(ChannelHandlerContext ctx) throws Exception { if (initMap.add(ctx)) { // Guard against re-entrance. try { initChannel((C) ctx.channel()); } catch (Throwable cause) { exceptionCaught(ctx, cause); } finally { ChannelPipeline pipeline = ctx.pipeline(); if (pipeline.context(this) != null) { //初始化完毕后,从pipeline中移除自身 pipeline.remove(this); } } return true; } return false; } //匿名类实现,这里指定具体的初始化逻辑 protected abstract void initChannel(C ch) throws Exception; private void removeState(final ChannelHandlerContext ctx) { //从initMap防重Set集合中删除ChannelInitializer if (ctx.isRemoved()) { initMap.remove(ctx); } else { ctx.executor().execute(new Runnable() { @Override public void run() { initMap.remove(ctx); } }); } } }ChannelInitializer中的初始化逻辑比较简单明了:

- 首先要判断必须是当前

Channel已经完成注册后,才可以进行pipeline的初始化。ctx.channel().isRegistered()

- 调用

ChannelInitializer的匿名类指定的initChannel执行自定义的初始化逻辑。

p.addLast(new ChannelInitializer<Channel>() { @Override public void initChannel(final Channel ch) { final ChannelPipeline pipeline = ch.pipeline(); //ServerBootstrap中用户指定的channelHandler ChannelHandler handler = config.handler(); if (handler != null) { pipeline.addLast(handler); } ch.eventLoop().execute(new Runnable() { @Override public void run() { pipeline.addLast(new ServerBootstrapAcceptor( ch, currentChildGroup, currentChildHandler, currentChildOptions, currentChildAttrs)); } }); } });还记得在初始化NioServerSocketChannel时。io.netty.bootstrap.ServerBootstrap#init方法中向pipeline中添加的ChannelInitializer吗?

- 当执行完

initChannel 方法后,ChannelPipeline的初始化就结束了,此时ChannelInitializer就没必要再继续呆在pipeline中了,所需要将ChannelInitializer从pipeline中删除。pipeline.remove(this)

当初始化完pipeline时,此时pipeline的结构再次发生了变化:

此时Main Reactor中的任务队列taskQueue结构变化为:

添加ServerBootstrapAcceptor的任务是在初始化NioServerSocketChannel的时候向main reactor提交过去的。还记得吗?

在本小节《Netty服务端的启动》的最开始,我们介绍了服务端启动的入口函数io.netty.bootstrap.AbstractBootstrap#doBind,在函数的最开头调用了initAndRegister()方法用来创建并初始化NioServerSocketChannel,之后便会将NioServerSocketChannel注册到Main Reactor中。

注册的操作是一个异步的过程,所以在initAndRegister()方法调用后返回一个代表注册结果的ChannelFuture regFuture。

public abstract class AbstractBootstrap<B extends AbstractBootstrap<B, C>, C extends Channel> implements Cloneable { private ChannelFuture doBind(final SocketAddress localAddress) { //异步创建,初始化,注册ServerSocketChannel final ChannelFuture regFuture = initAndRegister(); final Channel channel = regFuture.channel(); if (regFuture.cause() != null) { return regFuture; } if (regFuture.isDone()) { //如果注册完成,则进行绑定操作 ChannelPromise promise = channel.newPromise(); doBind0(regFuture, channel, localAddress, promise); return promise; } else { final PendingRegistrationPromise promise = new PendingRegistrationPromise(channel); //添加注册完成 回调函数 regFuture.addListener(new ChannelFutureListener() { @Override public void operationComplete(ChannelFuture future) throws Exception { ...............省略............... // 注册完成后,Reactor线程回调这里 doBind0(regFuture, channel, localAddress, promise); } } }); return promise; } } }之后会向ChannelFuture regFuture添加一个注册完成后的回调函数~~~~ ChannelFutureListener。在回调函数operationComplete中开始发起绑端口地址流程。

那么这个回调函数在什么时候?什么地方发起的呢??

让我们在回到本小节的主题register0方法的流程中:

当调用doRegister()方法完成NioServerSocketChannel向Main Reactor的注册后,紧接着会调用pipeline.invokeHandlerAddedIfNeeded()方法中触发ChannelInitializer#handlerAdded回调中对pipeline进行初始化。

最后在safeSetSuccess方法中,开始回调注册在regFuture上的ChannelFutureListener。

protected final void safeSetSuccess(ChannelPromise promise) { if (!(promise instanceof VoidChannelPromise) && !promise.trySuccess()) { logger.warn("Failed to mark a promise as success because it is done already: {}", promise); } } @Override public boolean trySuccess() { return trySuccess(null); } @Override public boolean trySuccess(V result) { return setSuccess0(result); } private boolean setSuccess0(V result) { return setValue0(result == null ? SUCCESS : result); } private boolean setValue0(Object objResult) { if (RESULT_UPDATER.compareAndSet(this, null, objResult) || RESULT_UPDATER.compareAndSet(this, UNCANCELLABLE, objResult)) { if (checkNotifyWaiters()) { //回调注册在promise上的listeners notifyListeners(); } return true; } return false; }safeSetSuccess的逻辑比较简单,首先设置regFuture结果为success,并且回调注册在regFuture上的ChannelFutureListener。

需要提醒的是,执行safeSetSuccess方法,以及后边回调regFuture上的ChannelFutureListener这些动作都是由Reactor线程执行的。

关于Netty中的Promise模型后边我会在写一篇专门的文章进行分析,这里大家只需清楚大体的流程即可。不必在意过多的细节。

下面我们把视角切换到regFuture上的ChannelFutureListener回调中,看看在Channel注册完成后,Netty又会做哪些事情?

public abstract class AbstractBootstrap<B extends AbstractBootstrap<B, C>, C extends Channel> implements Cloneable { private static void doBind0( final ChannelFuture regFuture, final Channel channel, final SocketAddress localAddress, final ChannelPromise promise) { channel.eventLoop().execute(new Runnable() { @Override public void run() { if (regFuture.isSuccess()) { channel.bind(localAddress, promise).addListener(ChannelFutureListener.CLOSE_ON_FAILURE); } else { promise.setFailure(regFuture.cause()); } } }); } }这里Netty又将绑定端口地址的操作封装成异步任务,提交给Reactor执行。

但是这里有一个问题,其实此时执行doBind0方法的线程正是Reactor线程,那为什么不直接在这里去执行bind操作,而是再次封装成异步任务提交给Reactor中的taskQueue呢?

反正最终都是由Reactor线程执行,这其中又有什么分别呢?

经过上小节的介绍我们知道,bind0方法的调用是由io.netty.channel.AbstractChannel.AbstractUnsafe#register0方法在将NioServerSocketChannel注册到Main Reactor之后,并且NioServerSocketChannel的pipeline已经初始化完毕后,通过safeSetSuccess方法回调过来的。

这个过程全程是由Reactor线程来负责执行的,但是此时register0方法并没有执行完毕,还需要执行后面的逻辑。

而绑定逻辑需要在注册逻辑执行完之后执行,所以在doBind0方法中Reactor线程会将绑定操作封装成异步任务先提交给taskQueue中保存,这样可以使Reactor线程立马从safeSetSuccess中返回,继续执行剩下的register0方法逻辑。

private void register0(ChannelPromise promise) { try { ................省略............ doRegister(); pipeline.invokeHandlerAddedIfNeeded(); safeSetSuccess(promise); //触发channelRegister事件 pipeline.fireChannelRegistered(); if (isActive()) { ................省略............ } } catch (Throwable t) { ................省略............ } }当Reactor线程执行完register0方法后,就会从taskQueue中取出异步任务执行。

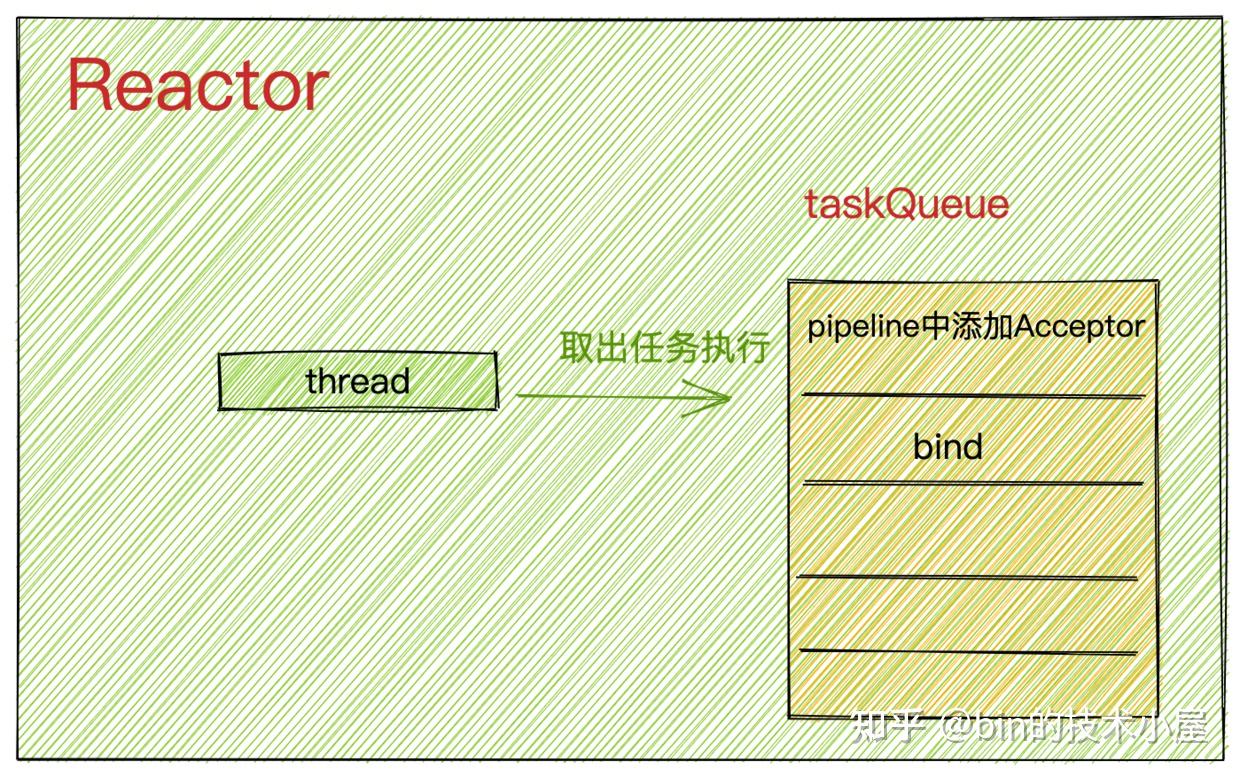

此时Reactor线程中的taskQueue结构如下:

Reactor线程会先取出位于taskQueue队首的任务执行,这里是指向NioServerSocketChannel的pipeline中添加ServerBootstrapAcceptor的异步任务。

此时NioServerSocketChannel中pipeline的结构如下:

Reactor线程执行绑定任务。

对Channel的操作行为全部定义在ChannelOutboundInvoker接口中。

public interface ChannelOutboundInvoker { / * Request to bind to the given {@link SocketAddress} and notify the {@link ChannelFuture} once the operation * completes, either because the operation was successful or because of an error. * */ ChannelFuture bind(SocketAddress localAddress, ChannelPromise promise); }bind方法由子类AbstractChannel实现。

public abstract class AbstractChannel extends DefaultAttributeMap implements Channel { @Override public ChannelFuture bind(SocketAddress localAddress, ChannelPromise promise) { return pipeline.bind(localAddress, promise); } }调用pipeline.bind(localAddress, promise)在pipeline中传播bind事件,触发回调pipeline中所有ChannelHandler的bind方法。

事件在pipeline中的传播具有方向性:

inbound事件从HeadContext开始逐个向后传播直到TailContext。outbound事件则是反向传播,从TailContext开始反向向前传播直到HeadContext。

inbound事件只能被pipeline中的ChannelInboundHandler响应处理outbound事件只能被pipeline中的ChannelOutboundHandler响应处理

然而这里的bind事件在Netty中被定义为outbound事件,所以它在pipeline中是反向传播。先从TailContext开始反向传播直到HeadContext。

然而bind的核心逻辑也正是实现在HeadContext中。

final class HeadContext extends AbstractChannelHandlerContext implements ChannelOutboundHandler, ChannelInboundHandler { @Override public void bind( ChannelHandlerContext ctx, SocketAddress localAddress, ChannelPromise promise) { //触发AbstractChannel->bind方法 执行JDK NIO SelectableChannel 执行底层绑定操作 unsafe.bind(localAddress, promise); } }在HeadContext#bind回调方法中,调用Channel里的unsafe操作类执行真正的绑定操作。

protected abstract class AbstractUnsafe implements Unsafe { @Override public final void bind(final SocketAddress localAddress, final ChannelPromise promise) { .................省略................ //这时channel还未激活 wasActive = false boolean wasActive = isActive(); try { //io.netty.channel.socket.nio.NioServerSocketChannel.doBind //调用具体channel实现类 doBind(localAddress); } catch (Throwable t) { .................省略................ return; } //绑定成功后 channel激活 触发channelActive事件传播 if (!wasActive && isActive()) { invokeLater(new Runnable() { @Override public void run() { //pipeline中触发channelActive事件 pipeline.fireChannelActive(); } }); } //回调注册在promise上的ChannelFutureListener safeSetSuccess(promise); } protected abstract void doBind(SocketAddress localAddress) throws Exception; }- 首先执行子类

NioServerSocketChannel具体实现的doBind方法,通过JDK NIO 原生 ServerSocketChannel执行底层的绑定操作。

@Override protected void doBind(SocketAddress localAddress) throws Exception { //调用JDK NIO 底层SelectableChannel 执行绑定操作 if (PlatformDependent.javaVersion() >= 7) { javaChannel().bind(localAddress, config.getBacklog()); } else { javaChannel().socket().bind(localAddress, config.getBacklog()); } }- 判断是否为首次绑定,如果是的话将

触发pipeline中的ChannelActive事件封装成异步任务放入Reactor中的taskQueue中。

- 执行

safeSetSuccess(promise),回调注册在promise上的ChannelFutureListener。

还是同样的问题,当前执行线程已经是Reactor线程了,那么为何不直接触发pipeline中的ChannelActive事件而是又封装成异步任务呢??

因为如果直接在这里触发ChannelActive事件,那么Reactor线程就会去执行pipeline中的ChannelHandler的channelActive事件回调。

这样的话就影响了safeSetSuccess(promise)的执行,延迟了注册在promise上的ChannelFutureListener的回调。

到现在为止,Netty服务端就已经完成了绑定端口地址的操作,NioServerSocketChannel的状态现在变为Active。

最后还有一件重要的事情要做,我们接着来看pipeline中对channelActive事件处理。

channelActive事件在Netty中定义为inbound事件,所以它在pipeline中的传播为正向传播,从HeadContext一直到TailContext为止。

在channelActive事件回调中需要触发向Selector指定需要监听的IO事件~~OP_ACCEPT事件。

这块的逻辑主要在HeadContext中实现。

final class HeadContext extends AbstractChannelHandlerContext implements ChannelOutboundHandler, ChannelInboundHandler { @Override public void channelActive(ChannelHandlerContext ctx) { //pipeline中继续向后传播channelActive事件 ctx.fireChannelActive(); //如果是autoRead 则自动触发read事件传播 //在read回调函数中 触发OP_ACCEPT注册 readIfIsAutoRead(); } private void readIfIsAutoRead() { if (channel.config().isAutoRead()) { //如果是autoRead 则触发read事件传播 channel.read(); } } //AbstractChannel public Channel read() { //触发read事件 pipeline.read(); return this; } @Override public void read(ChannelHandlerContext ctx) { //触发注册OP_ACCEPT或者OP_READ事件 unsafe.beginRead(); } }- 在

HeadContext中的channelActive回调中触发pipeline中的read事件。 - 当

read事件再次传播到HeadContext时,触发HeadContext#read方法的回调。在read回调中调用channel底层操作类unsafe的beginRead方法向selector注册监听OP_ACCEPT事件。

protected abstract class AbstractUnsafe implements Unsafe { @Override public final void beginRead() { assertEventLoop(); //channel必须是Active if (!isActive()) { return; } try { // 触发在selector上注册channel感兴趣的监听事件 doBeginRead(); } catch (final Exception e) { .............省略.............. } } } public abstract class AbstractChannel extends DefaultAttributeMap implements Channel { //子类负责继承实现 protected abstract void doBeginRead() throws Exception; }- 断言判断执行该方法的线程必须是

Reactor线程。

- 此时

NioServerSocketChannel已经完成端口地址的绑定操作,isActive() = true

- 调用

doBeginRead实现向Selector注册监听事件OP_ACCEPT

public abstract class AbstractNioChannel extends AbstractChannel { //channel注册到Selector后获得的SelectKey volatile SelectionKey selectionKey; // Channel监听事件集合 protected final int readInterestOp; @Override protected void doBeginRead() throws Exception { final SelectionKey selectionKey = this.selectionKey; if (!selectionKey.isValid()) { return; } readPending = true; final int interestOps = selectionKey.interestOps(); / * 1:ServerSocketChannel 初始化时 readInterestOp设置的是OP_ACCEPT事件 * */ if ((interestOps & readInterestOp) == 0) { //添加OP_ACCEPT事件到interestOps集合中 selectionKey.interestOps(interestOps | readInterestOp); } } }- 前边提到在

NioServerSocketChannel在向Main Reactor中的Selector注册后,会获得一个SelectionKey。这里首先要获取这个SelectionKey。

- 从

SelectionKey中获取NioServerSocketChannel感兴趣的IO事件集合 interestOps,当时在注册的时候interestOps设置为0。

- 将在

NioServerSocketChannel初始化时设置的readInterestOp = OP_ACCEPT,设置到SelectionKey中的interestOps集合中。这样Reactor中的Selector就开始监听interestOps集合中包含的IO事件了。

Main Reactor中主要监听的是OP_ACCEPT事件。

流程走到这里,Netty服务端就真正的启动起来了,下一步就开始等待接收客户端连接了。大家此刻在来回看这副启动流程图,是不是清晰了很多呢?

此时Netty的Reactor模型结构如下:

本文我们通过图解源码的方式完整地介绍了整个Netty服务端启动流程,并介绍了在启动过程中涉及到的ServerBootstrap相关的属性以及配置方式。NioServerSocketChannel的创建初始化过程以及类的继承结构。

其中重点介绍了NioServerSocketChannel向Reactor的注册过程以及Reactor线程的启动时机和pipeline的初始化时机。

最后介绍了NioServerSocketChannel绑定端口地址的整个流程。

上述介绍的这些流程全部是异步操作,各种回调绕来绕去的,需要反复回想下,读异步代码就是这样,需要理清各种回调之间的关系,并且时刻提醒自己当前的执行线程是什么?

好了,现在Netty服务端已经启动起来,接着就该接收客户端连接了,我们下篇文章见~~~~

旗帜鲜明说观点,本机之间的Socket通信,有可能走网卡,剩下的全部不走网卡。

这是一道路由(IP Routing)题,所以这道题只和IP Routing有关,即TCP/IP协议栈的IP路由有关。

不走网卡的场景

场景1:服务器IP = 127.0.0.1

服务器IP =127.0.0.1,即IP包的目IP=127.0.0.1,那IP包的源IP地址是什么?

IP模块基于目的IP =127.0.0.1,查询路由表发现最佳路由的出口为虚拟接口(127.0.0.1),于是就用它(127.0.0.1)作为源IP,它距离目的地最近。这是操作系统默认行为,如果用户没有明确指定源IP地址,操作系统选择路由出接口(Exiting Interface)的IP地址。

既然IP包已经完成了封装,IP Routing按照路由查询结果进行发送,并进入Sending Queue,IP Routing有一个判断逻辑,如果IP包的目的IP == 本地接口IP,需要将Sending Queue的该IP包移入Receiving Queue,相当于发送线与接收线短接(loopback)。

然后该IP包按照IP路由提交给虚拟接口(127.0.0.1),IP包没有经过网卡。

场景2:服务器IP = 10.1.1.1,IP绑定一个硬件网卡

同上,由于用户没有指定源IP,系统默认使用10.1.1.1作为源IP。该IP包被IP Routing做了收发短接,IP包在IP Routing模块里即发生了收发,IP包不经过网卡。

场景3:服务器IP = 10.1.1.1(一块网卡),客户端10.1.1.2 (同机另一块网卡),开启多接口路由功能

服务器IP =10.1.1.1,即IP包的目IP=10.1.1.1,源IP = 10.1.1.2 (由用户明确指定)。操作系统开启了多个网络接口IP Routing功能,如下图所示:

此时主机是一台路由器,该IP包被IP Routing做了收发短接,IP包在IP Routing模块里即发生了收发,IP包不经过网卡。

走网卡的场景

场景4:服务器IP = 10.1.1.1(一块网卡),客户端10.1.1.2 (同机另一块网卡),关闭多接口路由功能。

这个场景非常容易让人迷惑,之所以容易迷惑,是因为尽管服务器有两块网卡,但是这两块网卡老死不相往来。如果没有其它网络设备的帮助,是无法通信的,因为两块网卡之间的路由功能已经关闭,如下图所示:

目的IP =10.1.1.1,按照正常查询路由表的决策,最优路由(10.1.1.1/32,匹配长度为32bit)的出接口为10.1.1.1接口,那么应该使用10.1.1.1接口的IP= 10.1.1.1作为源IP地址,但是这和客户端指定的IP = 10.1.1.2并不相同,很显然无法满足客户端的需求。

于是,在次优路由里看看是否有满足用户需求的路由条目,值得欣慰的是,确实有这么一条次优路由(10.1.1.0/24,匹配长度为24bit),这条路由对应的出接口为10.1.1.2,系统会使用该接口的IP =10.1.1.2 作为源IP地址,恰好满足客户的需求。

然后这个IP包完成封装,进入Sending Queue,接下来会发生什么?

有同学说,由于IP包的目的IP地址 = 10.1.1.1, 恰好满足上文的判断逻辑,收发短接,同样不会经过网卡,对吗?

不对!

上文说了,这两块网卡是两个平行世界的接口,所以上文的判断逻辑不再适用。在出接口10.1.1.2的平行世界里,本地只有自己一个接口,接口10.1.1.1并不存在。

所以,接下来的一切主机之间的通信,就仿佛是两个主机之间的通信。需要发ARP广播请求对方的MAC地址,ARP通过网卡到达交换机,然后交换机广播ARP,ARP请求到达10.1.1.1。

服务器10.1.1.1发送ARP回复,经过网卡到达交换机,然后再到达主机10.1.1.2。最后两个主机就可以通信了,整个通信过程都会经过网卡。

上文的Routing的开关,在Windows操作系统使用“Services.msc” 设置”Routing and Remote Access”完成,Linux系统应该也有对应的开关配置。

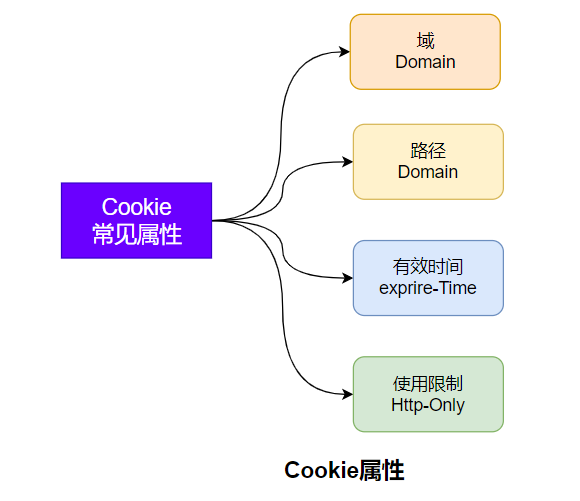

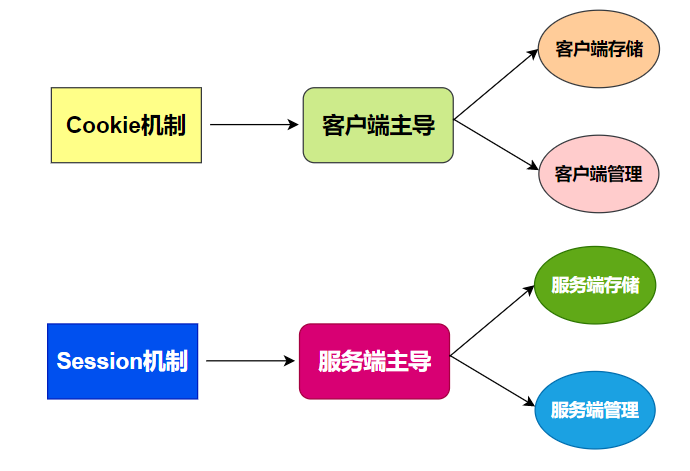

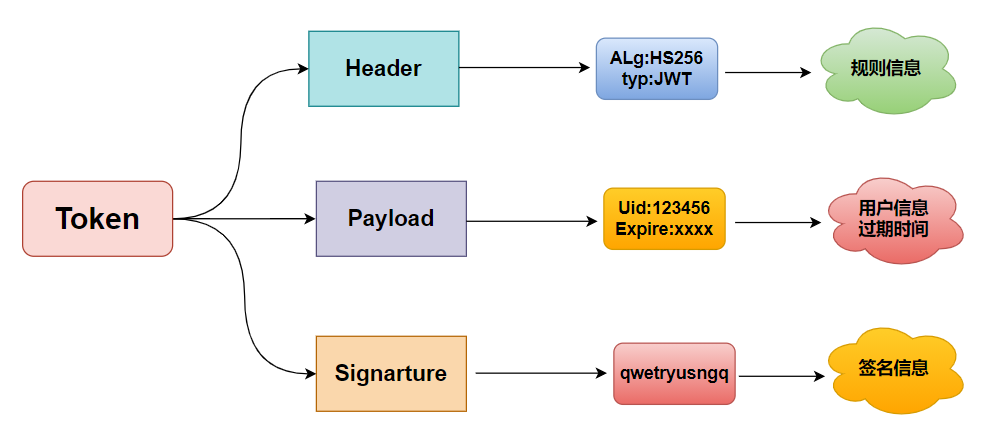

摘要:Cookie、Session、Token 这三者是不同发展阶段的产物,并且各有优缺点,三者也没有明显的对立关系,反而常常结伴出现,这也是容易被混淆的原因。

作为网友的我们,每天都会使用浏览器来逛各种网站,来满足日常的工作生活需求。

现在的交互体验还是很丝滑的,但早期并非如此,而是一锤子买卖。

无状态的 HTTP 协议是什么鬼?

HTTP 无状态协议,是指协议对于业务处理没有记忆能力,之前做了啥完全记不住。每次请求都是完全独立互不影响的,没有任何上下文信息。

缺少状态意味着如果后续处理需要前面的信息,则它必须重传关键信息,这样可能导致每次连接传送的数据量增大。

假如一直用这种原生无状态的 HTTP 协议,我们每换一个页面可能就得重新登录一次,那还玩个球。

所以必须要解决 HTTP 协议的无状态,提升网站的交互体验,否则星辰大海是去不了的。

整个事情交互的双方只有客户端和服务端,所以必然要在这两个当事者身上下手。

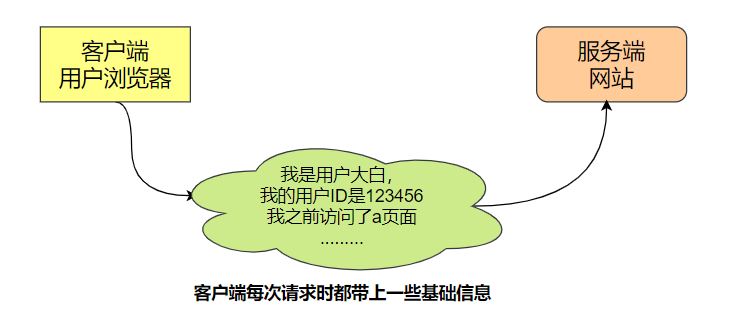

客户端来买单

客户端每次请求时把自己必要的信息封装发送给服务端,服务端查收处理一下就行。

服务端来买单

客户端第一次请求之后,服务端就开始做记录,然后客户端在后续请求中只需要将最基本最少的信息发过来就行,不需要太多信息了。

Cookie 总是保存在客户端中。按在客户端中的存储位置,可分为内存 Cookie 和硬盘Cookie。

内存 Cookie 由浏览器维护,保存在内存中,浏览器关闭后就消失了,其存在时间是短暂的。硬盘 Cookie 保存在硬盘里,有一个过期时间。除非用户手工清理或到了过期时间,硬盘Cookie不会被删除,其存在时间是长期的。

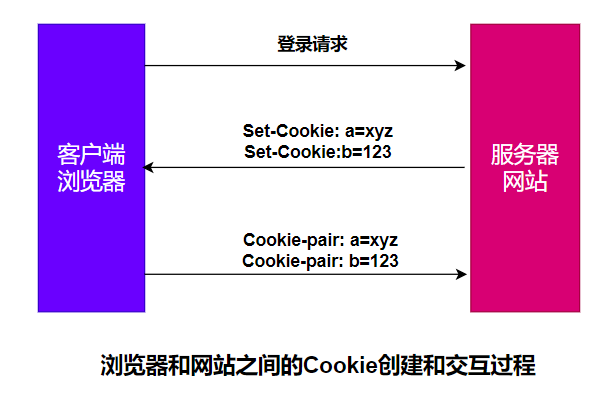

HTTP Cookie(也叫 Web Cookie 或浏览器 Cookie)是服务器发送到用户浏览器并保存在本地的一小块数据。它会在浏览器下次向同一服务器再发起请求时,被携带并发送到服务器上。

通常 Cookie 用于告知服务端两个请求是否来自同一浏览器,如保持用户的登录状态。Cookie 使基于无状态的HTTP协议记录稳定的状态信息成为了可能。

Cookie 主要用于以下三个方面:

- 会话状态管理(如用户登录状态、购物车等其它需要记录的信息)

- 个性化设置(如用户自定义设置、主题等)

- 浏览器行为跟踪(如跟踪分析用户行为等)

当服务器收到 HTTP 请求时,服务器可以在响应头里面添加一个 Set-Cookie 选项。

浏览器收到响应后通常会保存下 Cookie,之后对该服务器每一次请求中都通过 Cookie 请求头部将 Cookie 信息发送给服务器。另外,Cookie 的过期时间、域、路径、有效期、适用站点都可以根据需要来指定。

服务器使用 Set-Cookie 响应头部向用户浏览器发送 Cookie信息。

一个简单的 Cookie 可能像这样:

Set-Cookie: <cookie名>=<cookie值>

HTTP/1.0 200 OKContent-type: text/htmlSet-Cookie: yummy_cookie=chocoSet-Cookie: tasty_cookie=strawberry客户端对该服务器发起的每一次新请求,浏览器都会将之前保存的Cookie信息通过 Cookie 请求头部再发送给服务器。

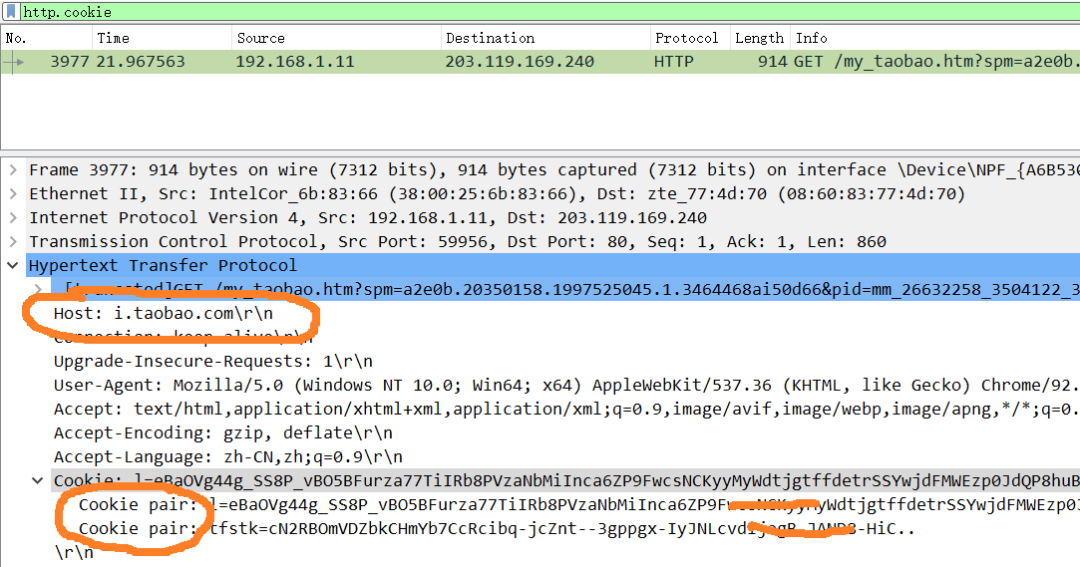

GET /sample_page.html HTTP/1.1Host: www.example.orgCookie: yummy_cookie=choco; tasty_cookie=strawberry我来访问下淘宝网,抓个包看看这个真实的过程:

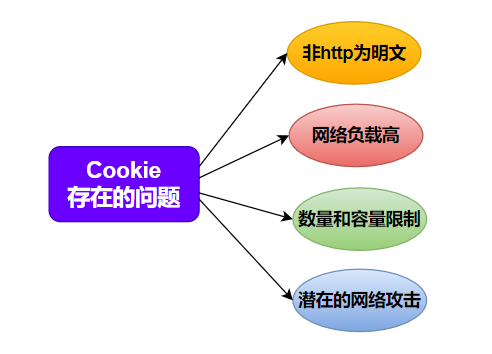

Cookie 常用来标记用户或授权会话,被浏览器发出之后可能被劫持,被用于非法行为,可能导致授权用户的会话受到攻击,因此存在安全问题。

还有一种情况就是跨站请求伪造 CSRF,简单来说 比如你在登录银行网站的同时,登录了一个钓鱼网站,在钓鱼网站进行某些操作时可能会获取银行网站相关的Cookie信息,向银行网站发起转账等非法行为。

跨站请求伪造(英语:Cross-site request forgery),也被称为 one-click attack 或者 session riding,通常缩写为 CSRF 或者 XSRF, 是一种挟制用户在当前已登录的 Web 应用程序上执行非本意的操作的攻击方法。跟跨网站脚本(XSS)相比,XSS 利用的是用户对指定网站的信任,CSRF 利用的是网站对用户网页浏览器的信任。

跨站请求攻击,简单地说,是攻击者通过一些技术手段欺骗用户的浏览器去访问一个自己曾经认证过的网站并运行一些操作(如发邮件,发消息,甚至财产操作如转账和购买商品)。

由于浏览器曾经认证过,所以被访问的网站会认为是真正的用户操作而去运行。这利用了 Web 中用户身份验证的一个漏洞:简单的身份验证只能保证请求发自某个用户的浏览器,却不能保证请求本身是用户自愿发出的。

不过这种情况有很多解决方法,特别对于银行这类金融性质的站点,用户的任何敏感操作都需要确认,并且敏感信息的 Cookie 只能拥有较短的生命周期。

同时 Cookie 有容量和数量的限制,每次都要发送很多信息带来额外的流量消耗、复杂的行为 Cookie 无法满足要求。

特别注意:以上存在的问题只是 Cookie 被用于实现交互状态时存在的问题,但并不是说 Cookie 本身的问题。

试想一下:菜刀可以用来做菜,也可以被用来从事某些暴力行为,你能说菜刀应该被废除吗?

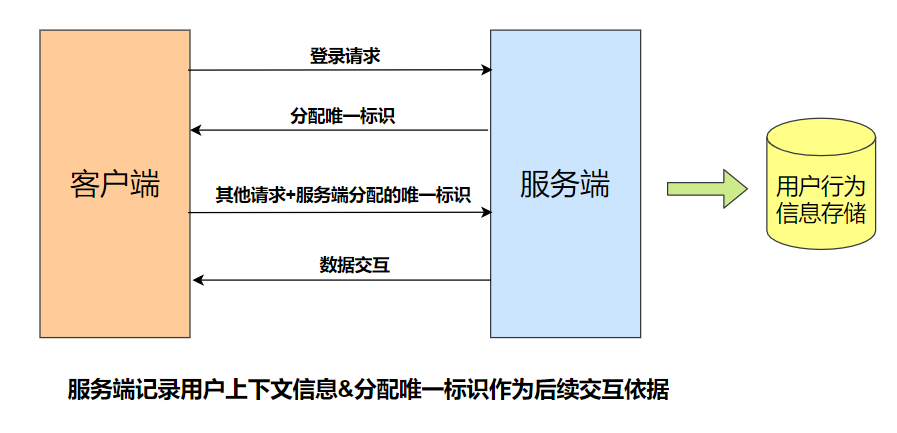

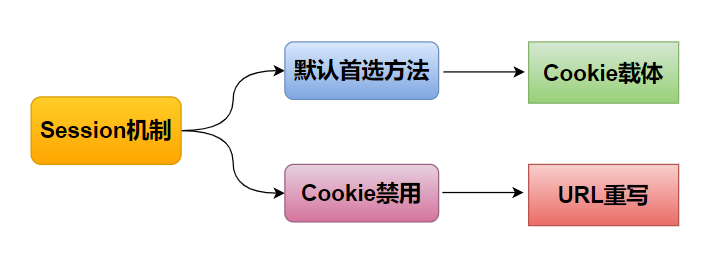

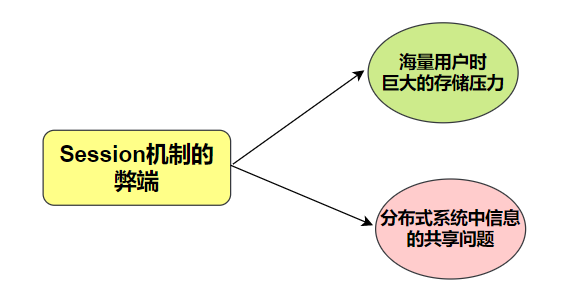

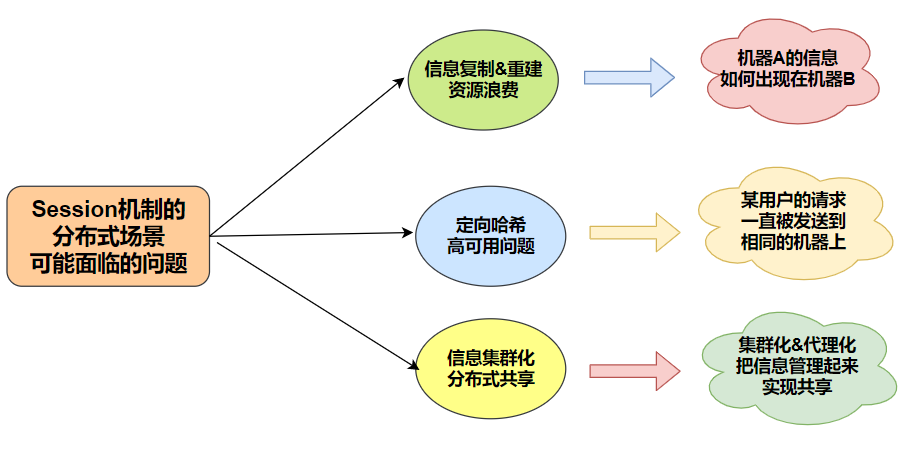

如果说 Cookie 是客户端行为,那么 Session 就是服务端行为。

Cookie 机制在最初和服务端完成交互后,保持状态所需的信息都将存储在客户端,后续直接读取发送给服务端进行交互。

Session 代表服务器与浏览器的一次会话过程,并且完全由服务端掌控,实现分配ID、会话信息存储、会话检索等功能。