出现如下内容:

回车即可,出现如下内容:

直接回车,出现内容:

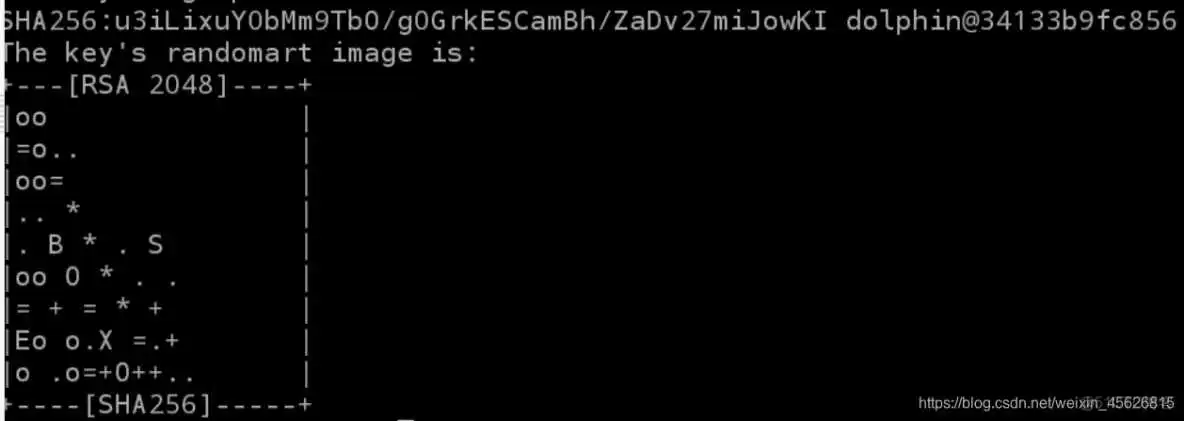

直接回车,创建完成,结果内容如下:

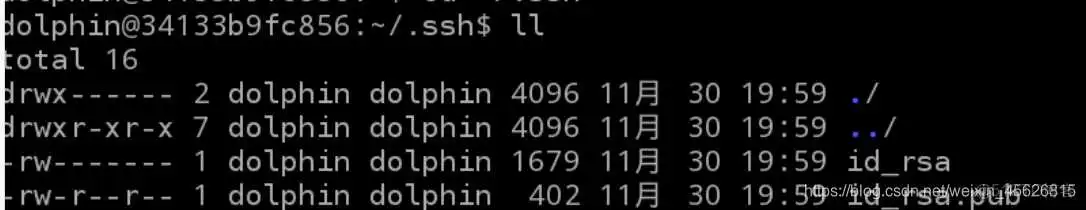

- 此时ssh公钥和私钥已经生成完毕,且放置在~ /.ssh目录下。切换到~/.ssh目录下

- ~/.ssh目录下的文件有:

- 下面在~/.ssh目录下,创建一个空文本,名为authorized_keys

- 将存储公钥文件的id_rsa.pub里的内容,追加到authorized_keys中

- 下面执行ssh localhost测试ssh配置是否正确

- 一次使用ssh访问,会提醒是否继续连接

- 输入yes

后续再执行ssh localhost时,就不用输入密码了

- 退出:

- jdk安装包:http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

- Hadoop安装包:http://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-3.0.0/hadoop-3.0.0.tar.gz

- 上传Hadoop,jdk安装包到/data/hadoop目录下,

- 将jdk-8u161-linux-x64.tar.gz加压缩到/apps目录下,

- 切换到apps目录下,查看内容

- 下面将jdk1.8.0_161目录重命名为java,执行:

- 切换到root用户下进行环境变量设置

- 输入上面的命令,打开存储环境变量的文件。在文件末尾空几行,将java的环境变量,追加进用户环境变量中。

- 保存并关闭编辑器

- 让环境变量生效。

- 执行source命令,让java环境变量生效。执行完毕后,可以输入java,来测试环境变量是否配置正确。如果出现下面界面,则正常运行。

- 正常结果显示如下

- 切换到/data/hadoop目录下,将hadoop-3.0.0.tar.gz解压缩到/apps目录下。

- 为了便于操作,我们也将hadoop-3.0.0重命名为hadoop。

- 切换到root用户下进行环境变量设置

- 输入上面的命令,打开存储环境变量的文件。在文件末尾空几行,将java的环境变量,追加进用户环境变量中。

- 保存并关闭编辑器

- 让环境变量生效。

- 验证hadoop环境变量配置是否正常

- 正常结果显示如下

- 首先切换到hadoop配置目录下。

cd /apps/hadoop/etc/hadoop

1、配置hadoop-env.sh

- 输入sudo vi /apps/hadoop/etc/hadoop/hadoop-env.sh,打开hadoop-env.sh配置文件。

- 将下面JAVA_HOME追加到hadoop-env.sh文件中。

2、配置core-site.xml

- 输入sudo vi /apps/hadoop/etc/hadoop/core-site.xml,打开core-site.xml配置文件。

- 添加下面配置到< configuration>与< /configuration>标签之间。

3、配置hdfs-site.xml

- 输入sudo vi /apps/hadoop/etc/hadoop/hdfs-site.xml,打开hdfs-site.xml配置文件。

- 添加下面配置到< configuration>与< /configuration>标签之间。

- 配置项说明:

dfs.replication,配置每个数据库备份数,由于目前我们使用1台节点,所以,设置为1,如果设置为2的话,运行会报错。

4、配置slaves

- 输入sudo vi /apps/hadoop/etc/hadoop/slaves,打开slaves配置文件。

- 将集群中slave角色的节点的主机名,添加进slaves文件中。目前只有一台节点,所以slaves文件内容为:

5、下面格式化HDFS文件系统。

- 执行:

6、切换目录到/apps/hadoop/sbin目录下。

7、启动hadoop的hdfs相关进程。

8、输入jps查看HDFS相关进程是否已经启动。

- 我们可以看到以下相关进程

9、下面可以再进一步验证HDFS运行状态。先在HDFS上创建目录。

- 将输入文件复制到分布式文件系统中。

10、执行下面命令

- 查看执行结果

- 显示如下

以上,便是HDFS安装过程。

11、配置MapReduce

- 下面来配置MapReduce相关配置。再次切换到hadoop配置文件目录

12、配置mapred-site.xml

- 输入sudo vi /apps/hadoop/etc/hadoop/mapred-site.xml,打开mapred-site.xml配置文件。

sudo vi /apps/hadoop/etc/hadoop/mapred-site.xml - 将mapreduce相关配置,添加到< configuration></ configuration>标签之间。

这里指定mapreduce任务处理所使用的框架。

13、配置yarn-site.xml

- 输入sudo vi /apps/hadoop/etc/hadoop/yarn-site.xml,打开yarn-site.xml配置文件。

- 将yarn相关配置,添加到< configuration>标签之间。

14、启动

- 下面来启动计算层面相关进程,切换到hadoop启动目录。

15、执行命令,启动yarn。

- 执行:

- 输出结果必须包含6个进程,结果如下:

16、执行测试。

- 清空原先测试数据

- 添加新测试数据

- 执行下面命令

- 获取执行结果

- 如果列表中结果包含”_SUCCESS“文件,代码集群运行成功。查看具体的执行结果,可以用如下命令:

- 显示如下

test 1

至此,Hadoop 单点模式已经安装完成!

到此这篇ssh免密登录配置不生效(配置ssh免密码登陆)的文章就介绍到这了,更多相关内容请继续浏览下面的相关推荐文章,希望大家都能在编程的领域有一番成就!版权声明:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权、违法违规、事实不符,请将相关资料发送至xkadmin@xkablog.com进行投诉反馈,一经查实,立即处理!

转载请注明出处,原文链接:https://www.xkablog.com/bcyy/59631.html